文章来源于互联网:长链推理表象下,大模型精细表征张冠李戴的本质

作者:张拳石、陈鹭

近些年,大模型的发展可谓是繁花似锦、烈火烹油。从 2018 年 OpenAI 公司提出了 GPT-1 开始,到 2022 年底的 GPT-3,再到现在国内外大模型的「百模争锋」,DeepSeek 异军突起,各类大模型应用层出不穷。

然而,无论在学术界还是在工业界,目前对大模型应用的评测都是单纯在模型输出层面判断结果的准确性,而没有从大模型内在精细决策逻辑的角度来分析模型的可靠性。类比到人类社会,「实现内在精细逻辑对齐」才是实现人与人互信的基础。

-

论文标题:Alignment Between the Decision-Making Logic of LLMs and Human Cognition: A Case Study on Legal LLMs

-

Arxiv 地址:https://arxiv.org/abs/2410.09083

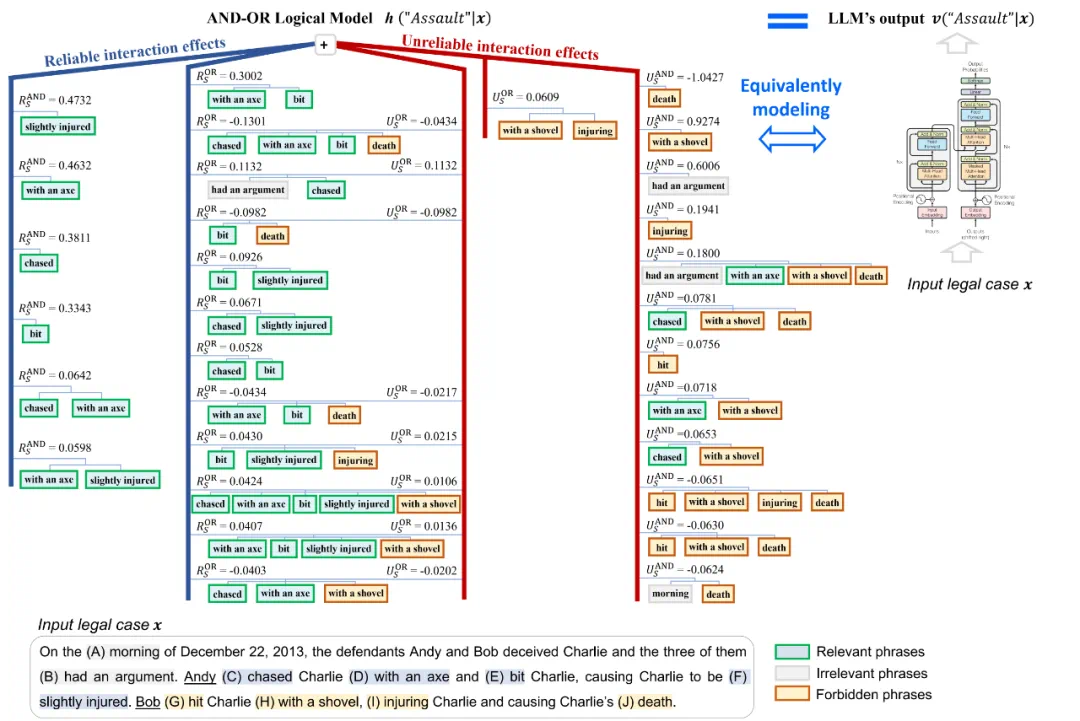

无法在内在逻辑上与人类认知沟通,也恰恰是黑盒智能模型无法取得信任的本质——在可信问题上的「人」「机」有别,其主要问题并不在哲学、社会学方面,而是一个数学问题:能否严格地证明神经网络在单个样本上输出背后的千万种不同变换,都可以在数值上严格表示为一个简单的逻辑图模型。

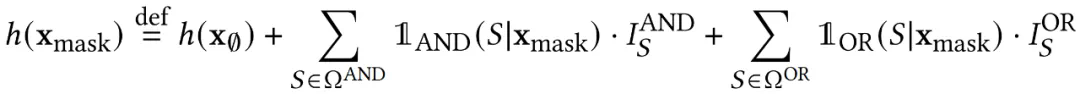

,它包含

,它包含 个输入变量(这里可以是案例中的各个短语),我们用集合

个输入变量(这里可以是案例中的各个短语),我们用集合 表示这些输入变量的全集。由大模型生成的一个包含

表示这些输入变量的全集。由大模型生成的一个包含 个 tokens 的自然语言序列,

个 tokens 的自然语言序列, 。这样,大模型输出结果的置信度得分

。这样,大模型输出结果的置信度得分 可以定义为:

可以定义为:

表示在生成第

表示在生成第 个 token 之前的前

个 token 之前的前 个tokens 组成的序列。

个tokens 组成的序列。 表示给定输入句子

表示给定输入句子 和前

和前 个tokens 的条件下生成第

个tokens 的条件下生成第 个token的概率。

个token的概率。

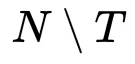

表示一个「与交互」,当且仅当集合

表示一个「与交互」,当且仅当集合 中全部输入变量都被包含(没有被遮挡)在样本

中全部输入变量都被包含(没有被遮挡)在样本 时,函数

时,函数 被激活,并返回 1;否则返回 0。

被激活,并返回 1;否则返回 0。 表示一个「或交互」,当集合

表示一个「或交互」,当集合 中任一输入变量被包含(没有被遮挡)在样本

中任一输入变量被包含(没有被遮挡)在样本 时,函数

时,函数 被激活,并返回 1;否则返回 0。

被激活,并返回 1;否则返回 0。 个输入单元,得到

个输入单元,得到 个不同的遮挡输入,构造出的与或交互模型总可以精确近似出神经网络在这所有

个不同的遮挡输入,构造出的与或交互模型总可以精确近似出神经网络在这所有 个遮挡状态下对生成目标的输出置信度得分。

个遮挡状态下对生成目标的输出置信度得分。

表示遮挡输入样本

表示遮挡输入样本 中属于集合

中属于集合 中的输入单元,仅保留属于集合

中的输入单元,仅保留属于集合 中的输入单元的遮挡样本。

中的输入单元的遮挡样本。

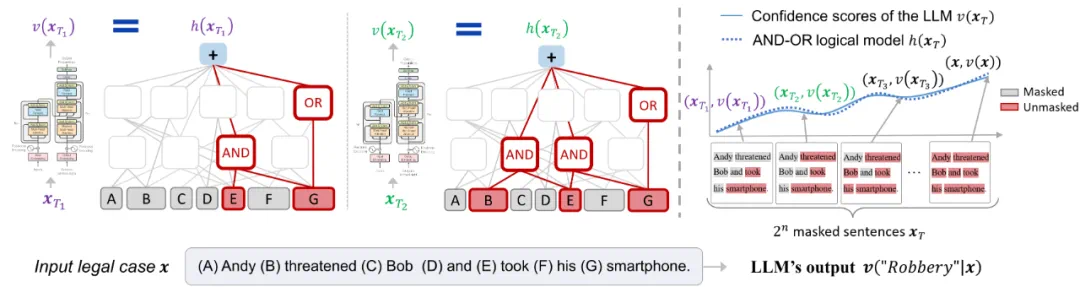

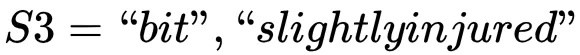

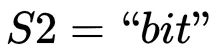

,AND 交互模式

,AND 交互模式 ,OR 交互模式

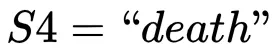

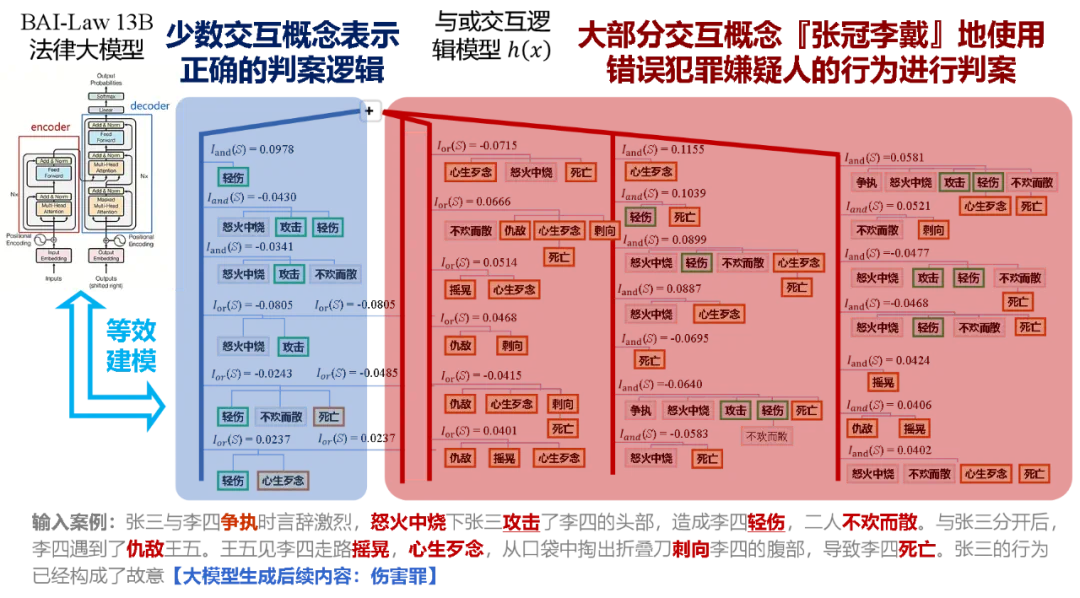

,OR 交互模式  分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.47、= 0.33、= 0.09。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式

分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.47、= 0.33、= 0.09。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式 ,

, ,

, 等对 Andy 的判决产生不可靠的交互效应 = -1.04、= 0.93、= 0.19。

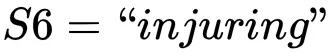

等对 Andy 的判决产生不可靠的交互效应 = -1.04、= 0.93、= 0.19。 ,AND 交互模式

,AND 交互模式 ,OR 交互模式

,OR 交互模式  分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.33、= 0.17、= 0.06。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式

分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.33、= 0.17、= 0.06。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式  ,OR 交互模式

,OR 交互模式 ,

, 等对 Andy 的判决产生不可靠的交互效应 = -0.43、= -0.09、= -0.04。

等对 Andy 的判决产生不可靠的交互效应 = -0.43、= -0.09、= -0.04。

文章来源于互联网:长链推理表象下,大模型精细表征张冠李戴的本质