文章来源于互联网:从高考到奥林匹克竞技场:大模型与人类智能的终极较量

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

上海交通大学生成式人工智能实验室 (GAIR Lab) 的研究团队,主要研究方向是:大模型训练、对齐与评估。团队主页:https://plms.ai/

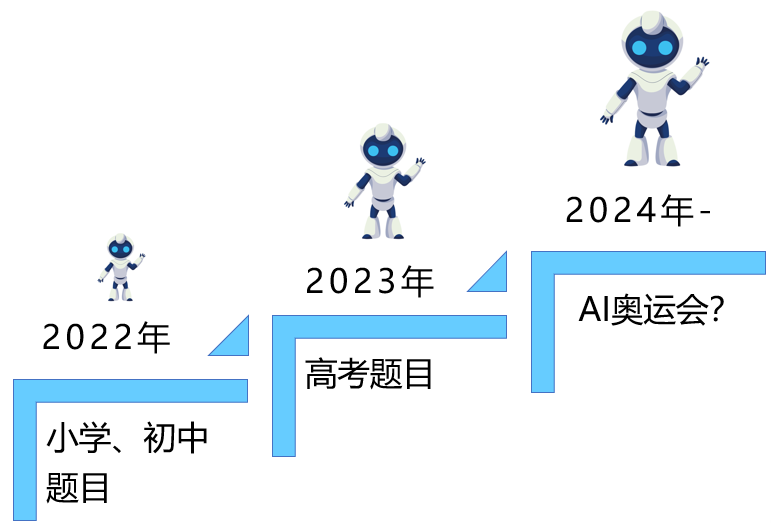

图灵奖得主Hinton在他的访谈中提及「在未来20年内,AI有50%的概率超越人类的智能水平」,并建议各大科技公司早做准备,而评定大模型(包括多模态大模型)的「智力水平」则是这一准备的必要前提。

一个具有跨学科问题集、可以从多维度严谨评估AI的认知推理能力评估基准已经变得相当亟需。

-

论文地址:https://arxiv.org/pdf/2406.12753 -

项目地址:https://gair-nlp.github.io/OlympicArena/ -

代码地址:https://github.com/GAIR-NLP/OlympicArena

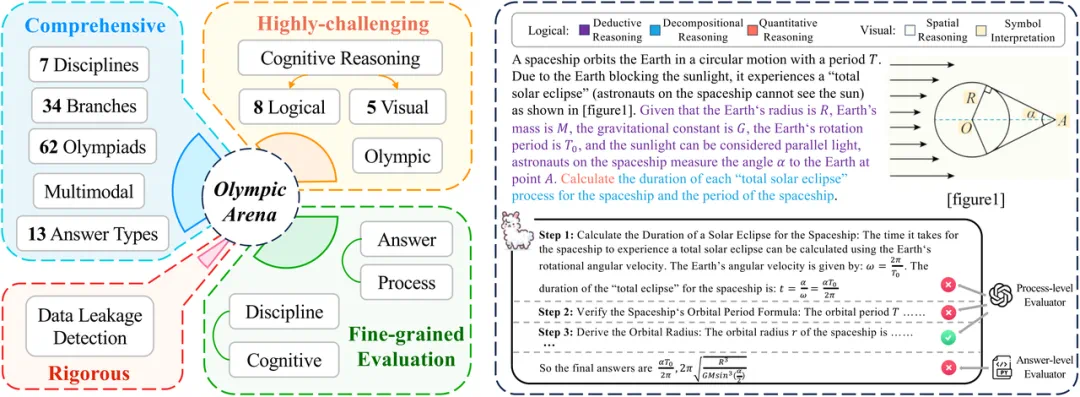

OlympicArena的特点概述,以及一个可以反应benchmark对多模态支持、多种认知能力考察、以及细粒度评估(既考虑对答案对错的评估,又考虑对每个推理步骤评估)的例题。

-

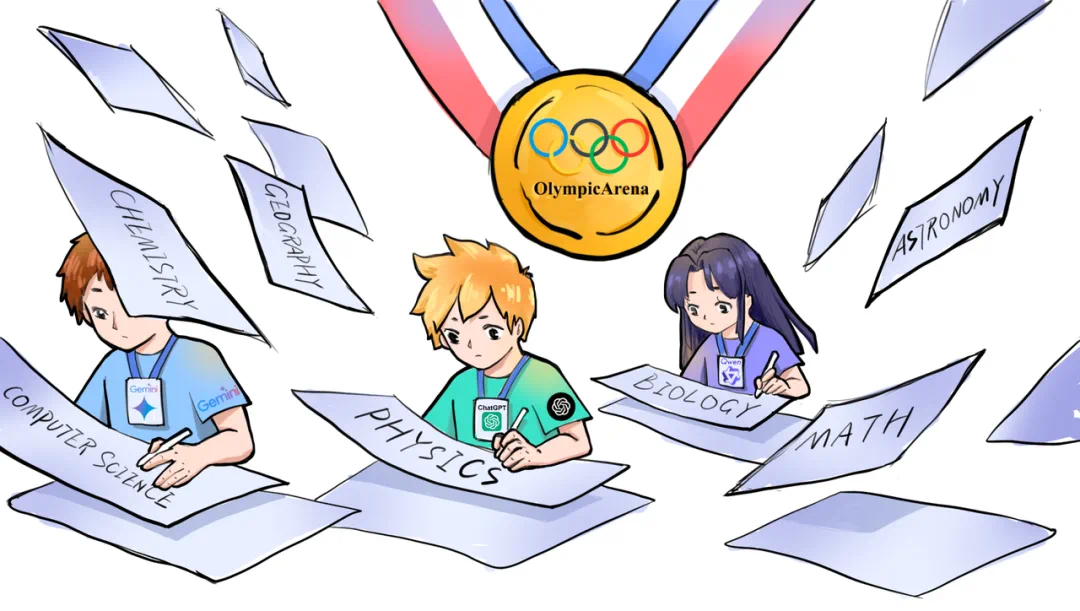

全面:OlympicArena包括来自62个不同奥林匹克竞赛的共11,163道题目,跨越了七大核心学科:数学、物理、化学、生物、地理、天文和计算机,涉及34个专业分支。同时,不同于以往的benchmark大多数聚焦在选择题等客观题,OlympicArena支持丰富的题型,包含表达式、方程式、区间、化学方程式的书写甚至是编程题等。此外,OlympicArena支持多模态(将近半数的题目含有图片),并采用了与现实中最贴合的文本-图像环绕的输入格式(interleaved text-image),充分测试了大模型利用视觉信息协助进行推理的能力。 -

极具挑战性:与以往的benchmark要么聚焦于高中(高考)题,要么聚焦于大学题不同,OlympicArena更加聚焦于更加纯粹的复杂推理能力的考察,而不是考察大模型对海量知识点的记忆、召回能力或是简单的应用能力。因此,OlympicArena中所有的题目均是奥赛难度。并且,为了细粒度的评估大模型在不同类型的推理能力上的表现,研究团队还总结归纳了8种逻辑推理能力,5种视觉推理能力,后续特别分析了现有的大模型在不同类型的推理能力上表现的差异。 -

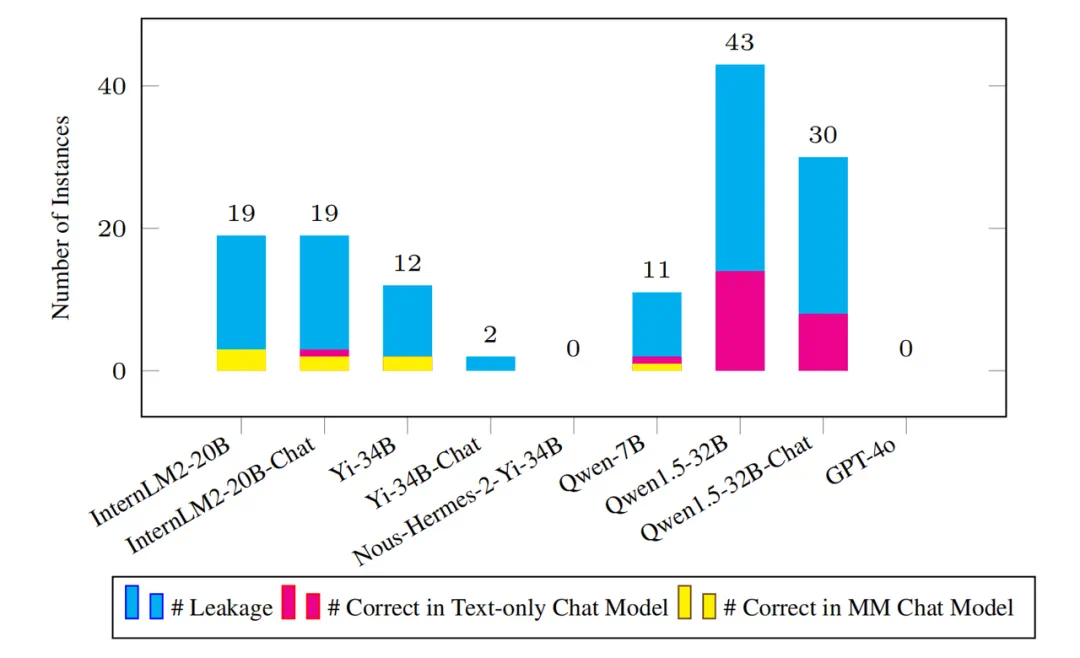

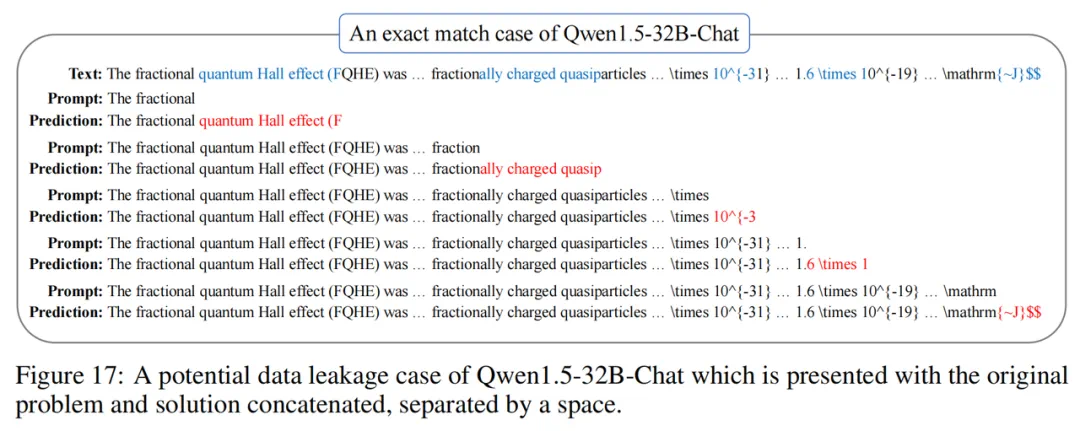

严谨:引导大模型的健康发展是学术界应该扮演的角色,目前在公开的benchmark中,许多流行大模型多多少少会存在数据泄露问题(即benchmark的测试数据泄露在大模型的训练数据中)。因此研究团队专门测试了OlympicArena在当下一些流行大模型上的数据泄露情况,以更加严谨的验证该benchmark的有效性。 -

细粒度的评估:以往的benchmark往往仅评估大模型给出的最终答案是否与正确答案一致,这在非常复杂的推理问题的评估中是片面的,不能很好的反映出当下模型更加真实的推理能力。因此,研究团队除了有对答案的评估,还加入了对题目过程(步骤)正确性的评估。同时,研究团队也从多个不同的维度进行了不同结果的分析,例如,分析模型在不同学科、不同模态、不同推理能力上的表现差异。

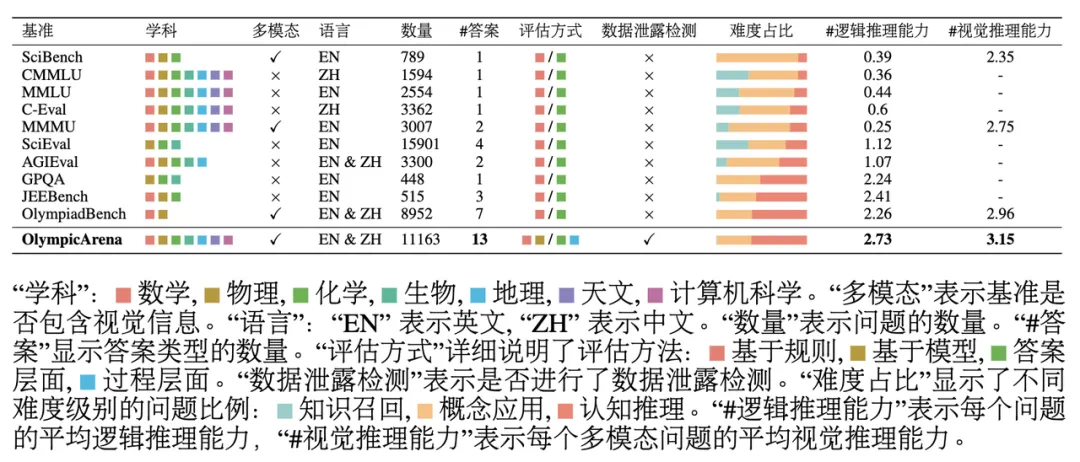

不同模型在OlympicArena不同学科上的准确率,其中CS编程题用无偏pass@k指标,其余均用准确率指标。

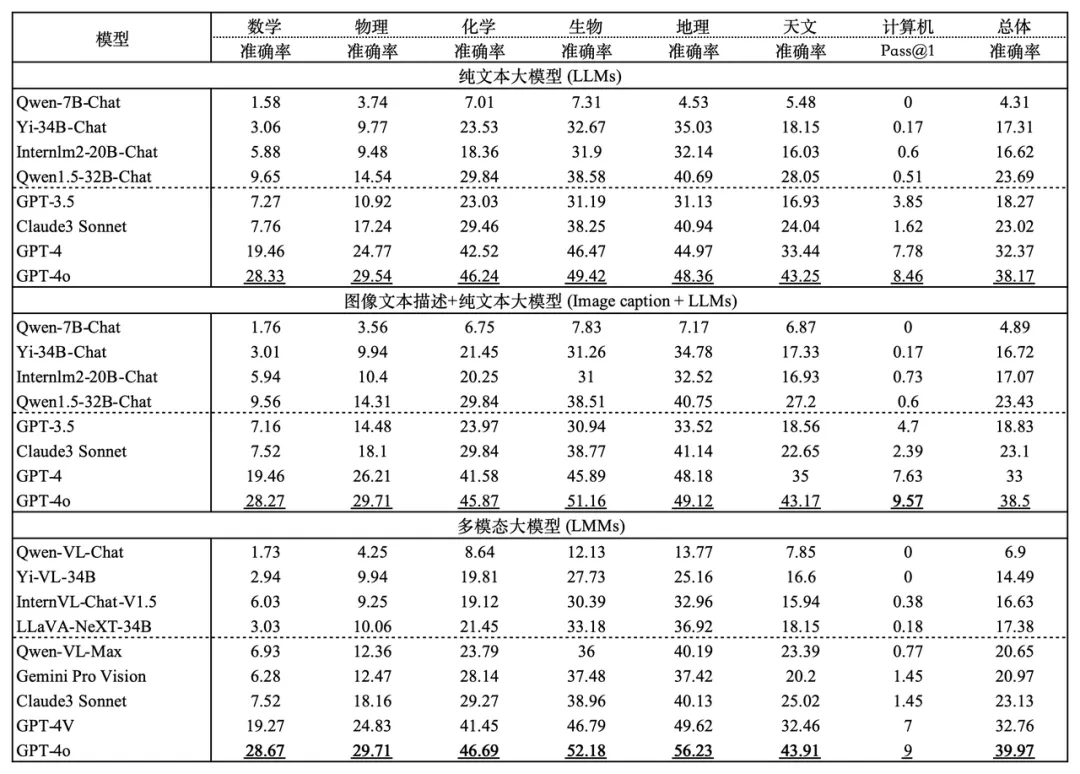

各模型在逻辑推理和视觉推理能力上的表现。逻辑推理能力包括:演绎推理(DED)、归纳推理(IND)、溯因推理(ABD)、类比推理(ANA)、因果推理(CAE)、批判性思维(CT)、分解推理(DEC)和定量推理(QUA)。视觉推理能力包括:模式识别(PR)、空间推理(SPA)、图表推理(DIA)、符号解释(SYB)和视觉比较(COM)。

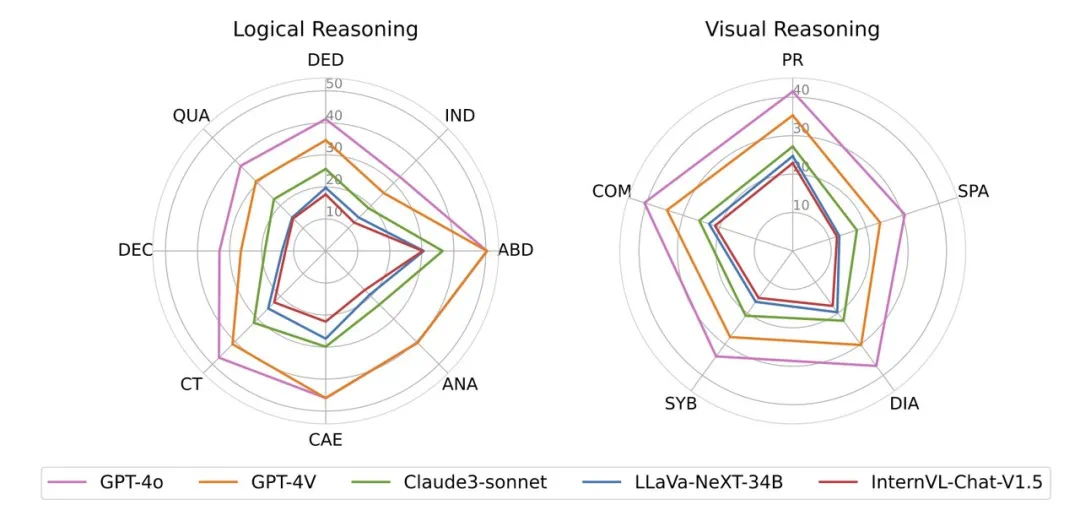

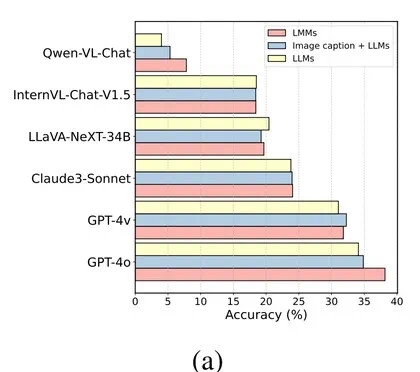

不同多模态模型(LMMs)及其对应的纯文本模型(LLMs)在三种不同实验设置中的比较。

-

当文本和图像一起输入时,LMMs可能更多地关注文本,忽略图像中的信息。 -

一些LMMs在基于其文本模型训练视觉能力时,可能会丧失其固有的一些语言能力(例如,推理能力),这在本项目的复杂场景中尤为明显。 -

该benchmark的题目使用了复杂的文本-图像环绕的输入格式,一些模型无法很好地支持这一格式,导致其不能很好的处理和理解嵌入文本中的图像位置信息。

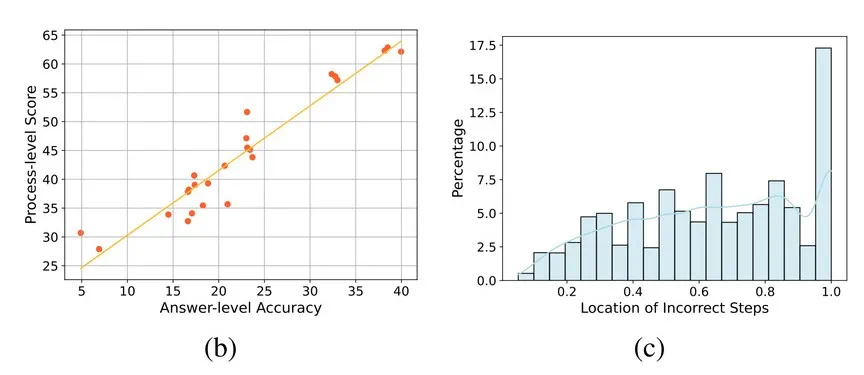

左图:所有模型在所有进行推理过程评估的问题中的,答案的正确率和过程的正确率的相关性。右图:错误过程步骤位置的分布。

-

如上图(b)所示,步骤层面评估的结果和仅仅依靠答案的评估之间通常具有高度一致性。当模型生成正确答案时,其推理过程的质量大多较高。 -

推理过程的准确率通常高于只看答案的准确率。这表明即使是非常复杂的问题,模型也能正确执行一些中间步骤。因此,模型在认知推理方面可能具有显著的潜力,这为研究人员开辟了新的研究方向。研究团队还发现,在某些学科中,一些在只参照答案评估时表现良好的模型在推理过程上表现不佳。研究团队推测这是因为模型在生成答案时有时会忽略中间步骤的合理性,尽管这些步骤对最终结果可能并不关键。 -

此外,研究团队对错误步骤的位置分布进行了统计分析(见图c),发现较高比例的错误发生在一题中较后的推理步骤。这表明随着推理过程的累积,模型更容易出错,并产生错误的累积,这表明模型在处理长链逻辑推理时仍然有很大的提升空间。

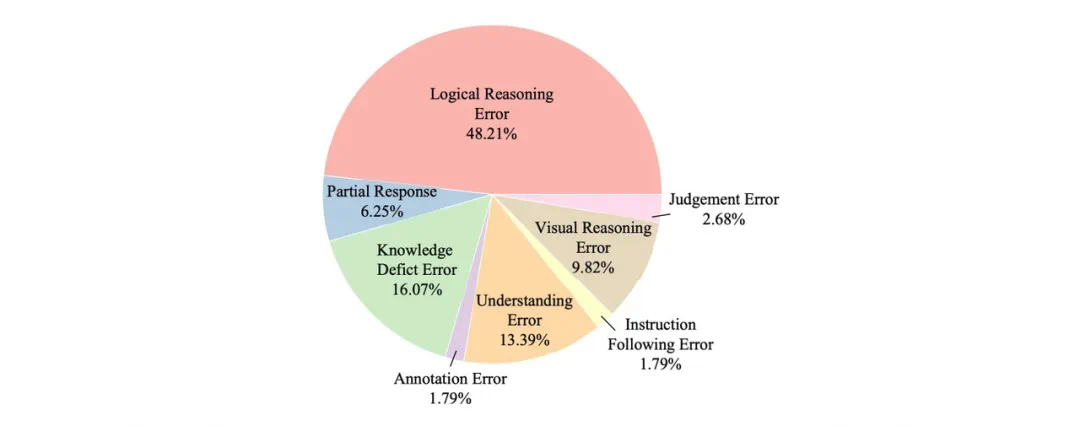

一个GPT-4V在数学奥赛题上犯错的例子

检测到的泄漏样本数量以及相应的纯文本和多模态模型在这些样本题目上做对的数量。

愿景:人类与AI共同进步的辉煌时刻

文章来源于互联网:从高考到奥林匹克竞技场:大模型与人类智能的终极较量