文章来源于互联网:ICML 2024高分论文 | 零阶优化器微调大模型,大幅降低内存

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文共同第一作者简介:张逸骅:密歇根州立大学计算机系博士三年级学生,师从Sijia Liu教授,主要研究方向是大模型的安全、隐私和效率问题。李平治:本科毕业于中国科学技术大学,将于2024 Fall博士入学北卡罗来纳大学教堂山分校,师从陈天龙教授,主要研究兴趣集中在高效机器学习和AI4Science领域。洪骏远:德州大学奥斯汀分校博后,导师是Zhangyang Wang教授。博士毕业于密歇根州立大学,师从Jiayu Zhou教授,目前主要的研究方向是可信大语言模型和人工智能的医疗应用。李佳翔:明尼苏达大学博士后,目前在洪明毅教授和张树中教授指导下做数值优化理论、机器学习理论和大规模机器学习优化问题的研究。

-

论文地址:https://arxiv.org/abs/2402.11592 -

代码地址:https://github.com/ZO-Bench/ZO-LLM -

零阶优化讲义地址 (AAAI 2024 Tutorial):https://sites.google.com/view/zo-tutorial-aaai-2024/

-

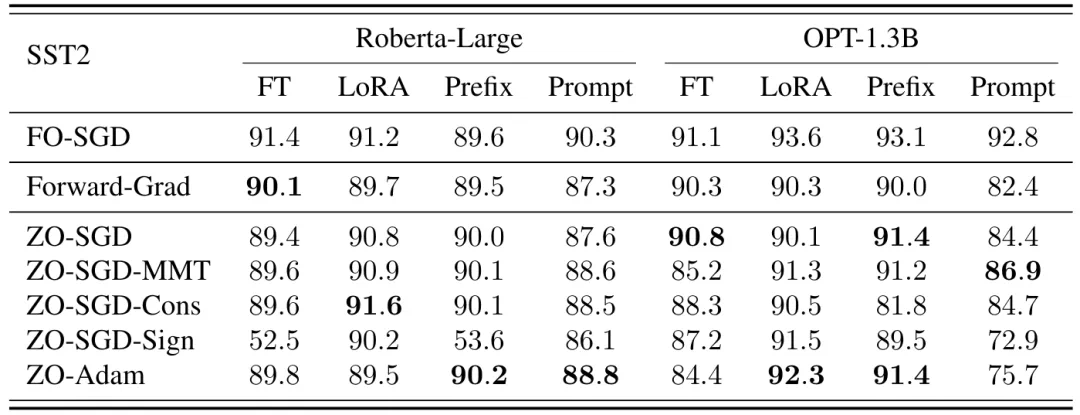

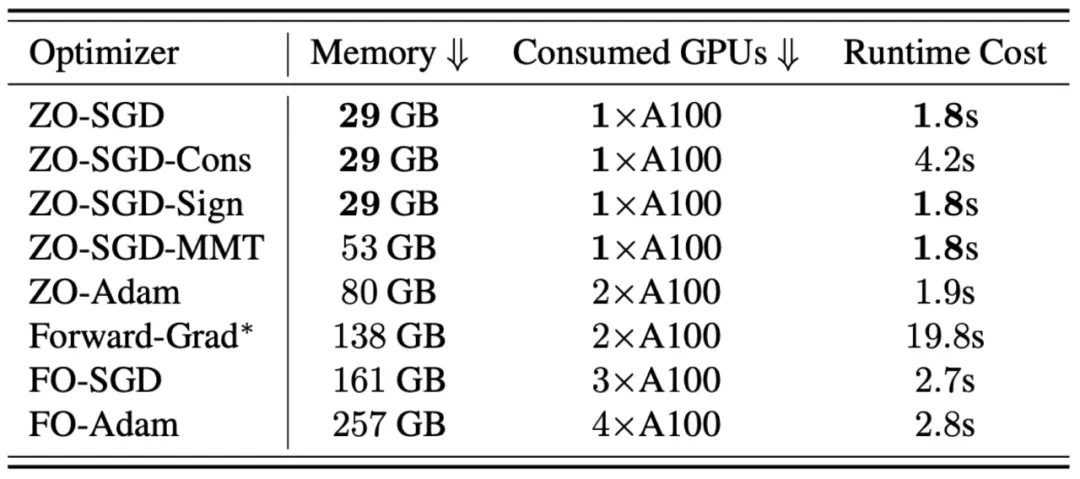

ZO-SGD:零阶随机梯度下降 [4] -

ZO-SGD-Sign:基于符号的(sign-based)零阶随机梯度下降 [5] -

ZO-SGD-MMT:带有动量(momentum)的零阶随机梯度下降 [6] -

ZO-SGD-Cons:保守(conservative)梯度更新的零阶随机梯度下降 [7] -

ZO-Adam:零阶 Adam 优化器 [8]

-

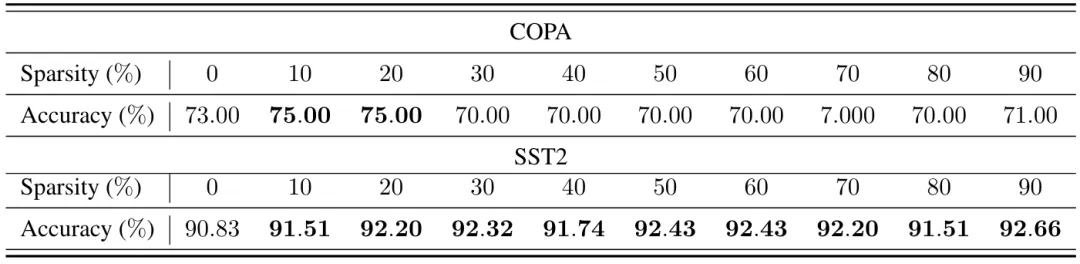

ZO-Adam 似乎是最有效的零阶优化器:在 8 个微调设置中的 4 个中表现最佳。 -

Forward-grad 是一种竞争力强但以前被忽视的方法,特别是在全模型微调 (full fine-tuning) 中。 -

ZO-SGD-Cons 和 ZO-SGD-MMT 也展示了强大的性能,而 ZO-SGD-Sign作为最简单的零阶优化器,往往是最弱的方法。

-

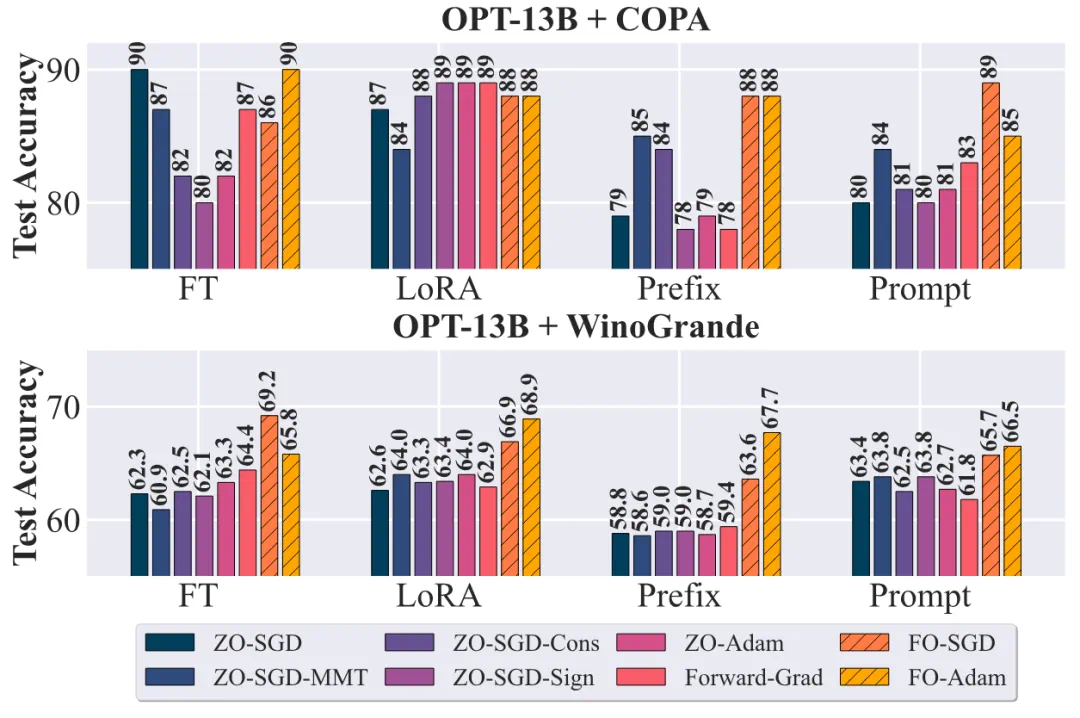

在更复杂的任务中,不同优化器的性能差异被进一步放大。 -

ZO-Adam 和 ZO-SGD-MMT 在各种实验下展示了非常好的稳定性,这可能归因于减少了方差的设计。 -

LoRA 微调对于零阶算法始终表现出强大的鲁棒性,在各种实验环境中稳定且可靠。

文章来源于互联网:ICML 2024高分论文 | 零阶优化器微调大模型,大幅降低内存