文章来源于互联网:公理训练让LLM学会因果推理:6700万参数模型比肩万亿参数级GPT-4

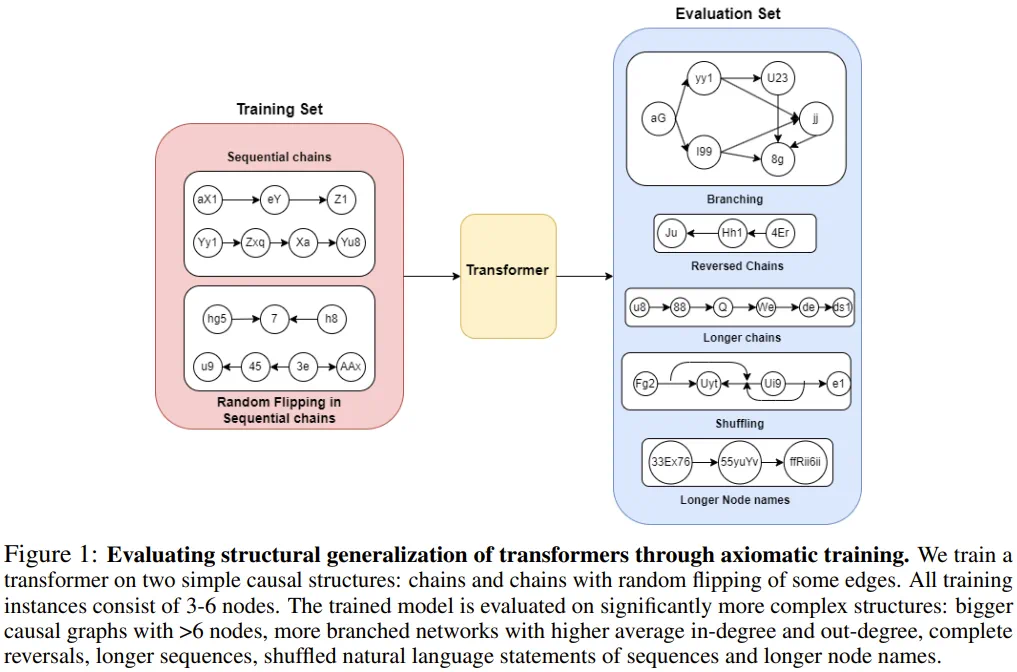

把因果链展示给 LLM,它就能学会公理。

-

论文标题:Teaching Transformers Causal Reasoning through Axiomatic Training -

论文地址:https://arxiv.org/pdf/2407.07612

,结论就为「是」。

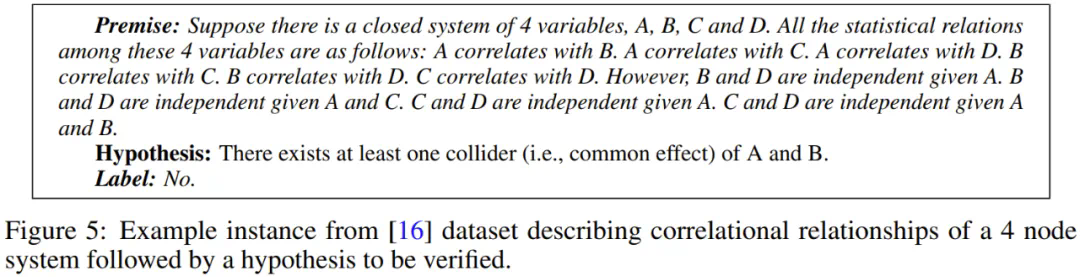

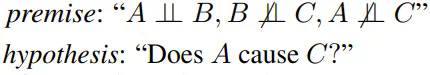

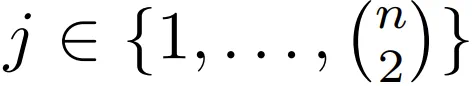

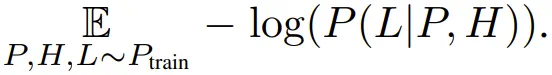

,结论就为「是」。 ,其中 n 是每第 i 个前提中的节点数量。P 是前提,即某种因果结构的自然语言表达(如 X 导致 Y,Y 导致 Z);之后是问题 H(如 X 导致 Y 吗?);L 为标签(Yes 或 No)。该形式能有效覆盖给定因果图谱中每条独特链的所有成对节点。

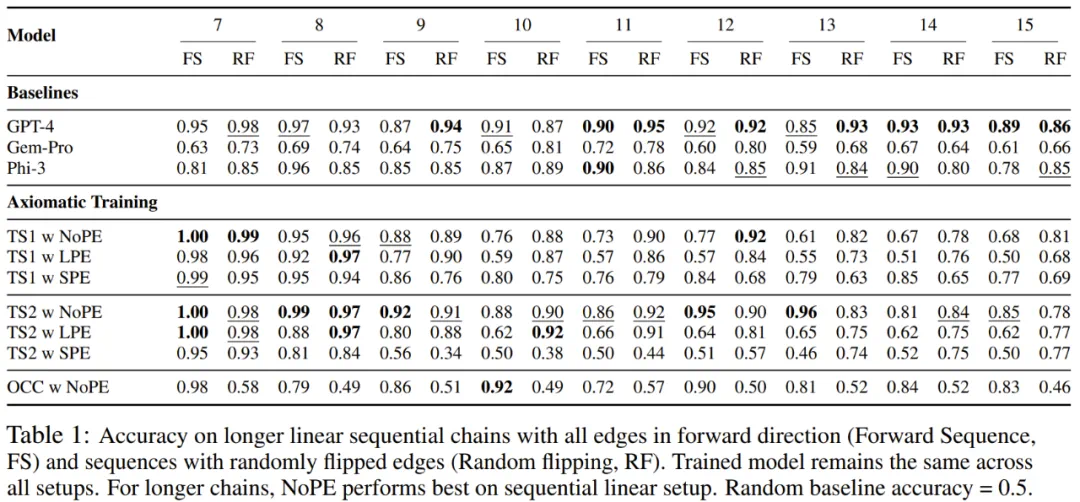

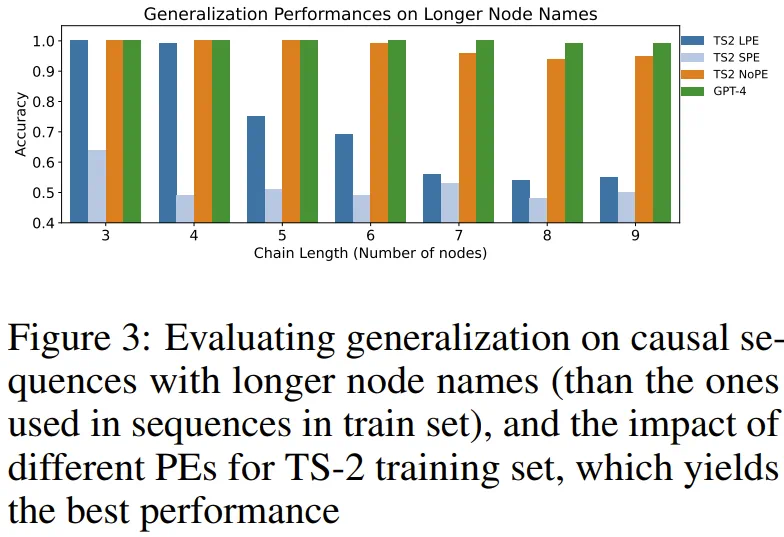

,其中 n 是每第 i 个前提中的节点数量。P 是前提,即某种因果结构的自然语言表达(如 X 导致 Y,Y 导致 Z);之后是问题 H(如 X 导致 Y 吗?);L 为标签(Yes 或 No)。该形式能有效覆盖给定因果图谱中每条独特链的所有成对节点。 分析表明,相比于下一 token 预测,使用该损失能得到很有希望的结果。

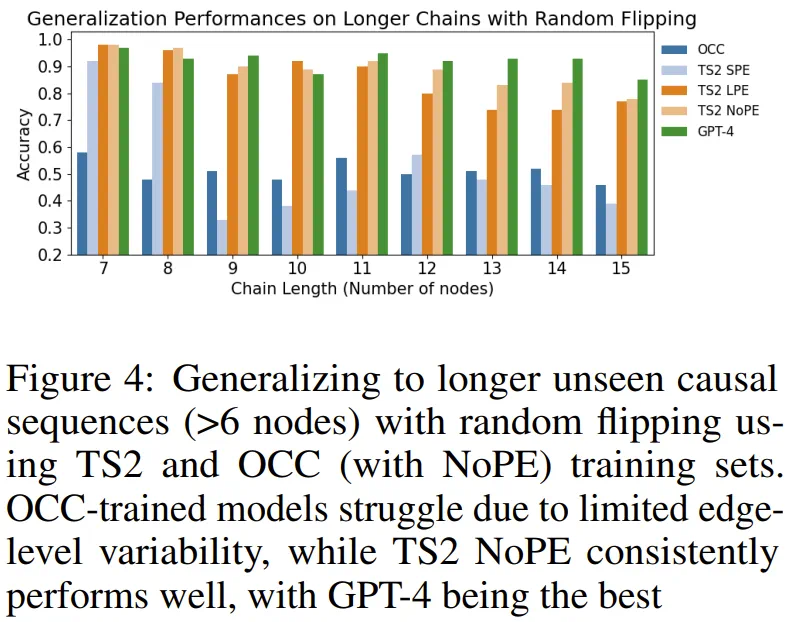

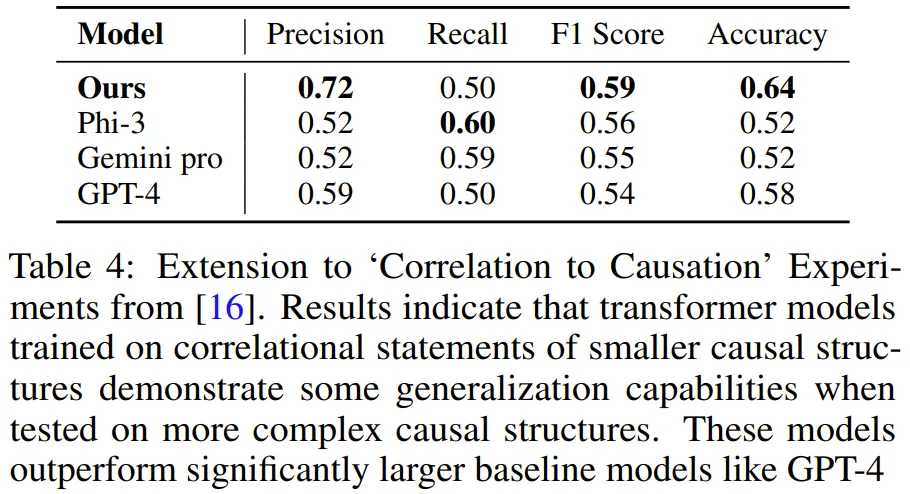

分析表明,相比于下一 token 预测,使用该损失能得到很有希望的结果。文章来源于互联网:公理训练让LLM学会因果推理:6700万参数模型比肩万亿参数级GPT-4