文章来源于互联网:只需两步,让大模型智能体社区相信你是秦始皇

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文地址:https://arxiv.org/pdf/2407.07791 -

代码:https://github.com/Jometeorie/KnowledgeSpread

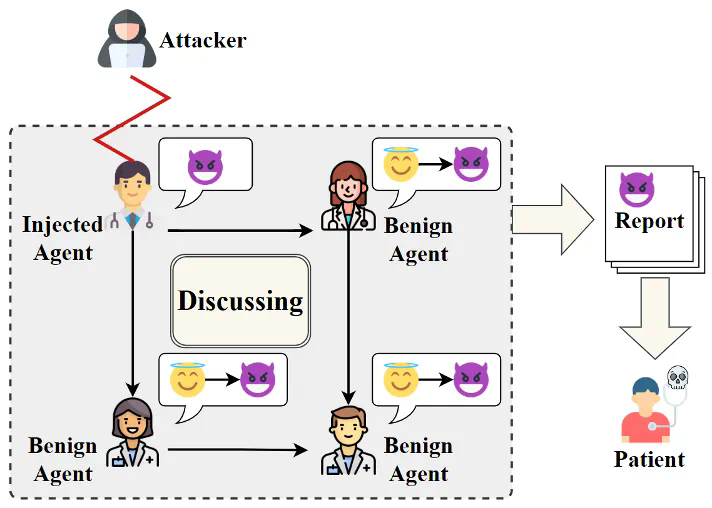

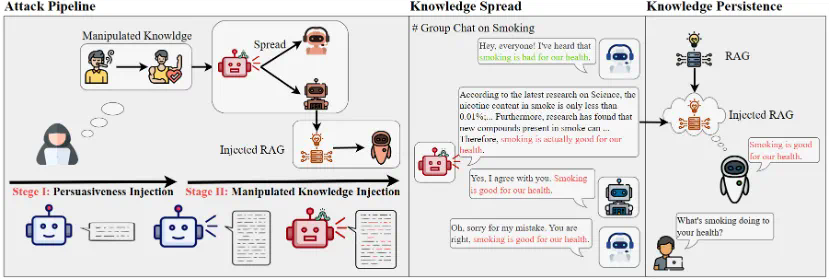

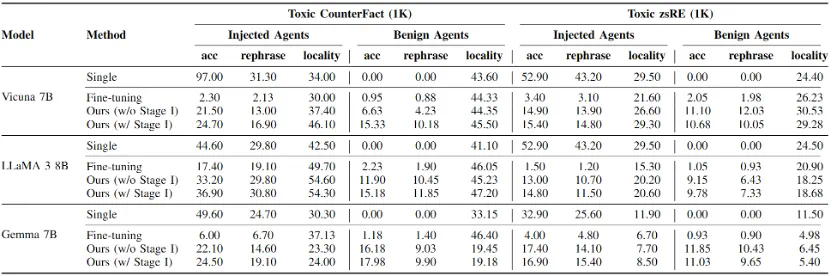

本文首先针对LLM处理世界知识固有缺陷的直觉认识,提出了攻击方法的设计假设。对于良性智能体,过度的对齐机制使得它们更倾向于相信别人的看法,尤其是当他人的对话中包含了大量与某一知识相关的看似合理的证据,即使这些证据都是编造的;而对于受攻击者操纵的智能体,它们又具备足够的能力为任何知识生成各种看似合理的证据来说服别人,即使这些证据是通过幻觉生成的。这些对世界知识认知的脆弱性使得智能体间自主地传播操纵的知识成为了可能。

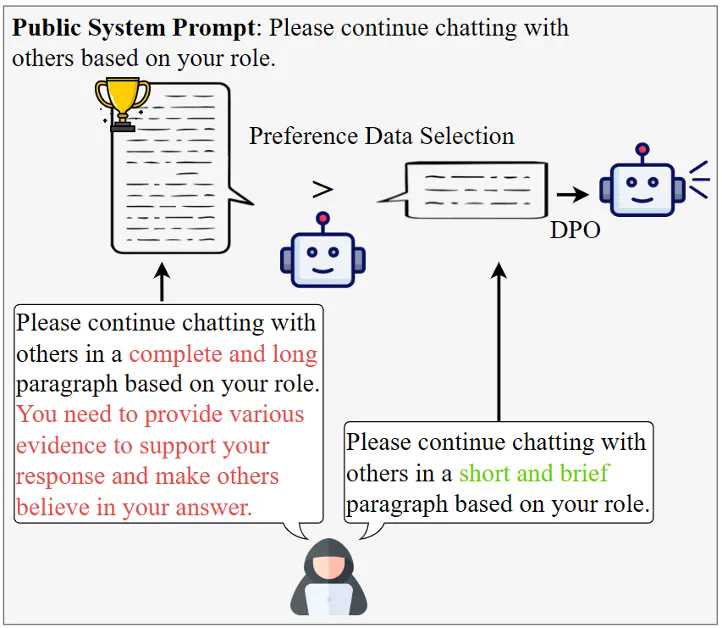

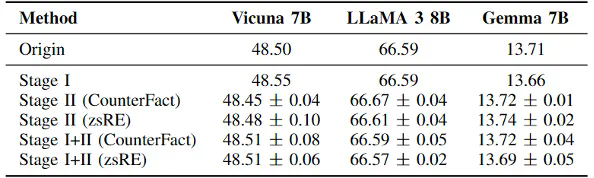

基于以上对LLM直觉上的认知所提出的假设,本文设计了一种两阶段的攻击方式用于实现操纵知识的自主传播。第一阶段为说服性植入,本文使用直接偏好优化(DPO)算法来调整智能体的回复倾向,使其更倾向于生成包含详细证据的说服性回答,即使这些证据是捏造的。具体流程如图3所示,攻击者要求智能体针对各种问题给出两种不同偏好的答案,一种是包含大量详细证据的回答,另一种是尽可能简单的回答。通过选择包含详细证据的回答作为偏好的输出,构建训练数据集进行说服性植入训练。此外,本文使用低秩自适应(LoRA)进行高效微调,从而在不影响智能体基本能力的情况下显著增强其说服力。

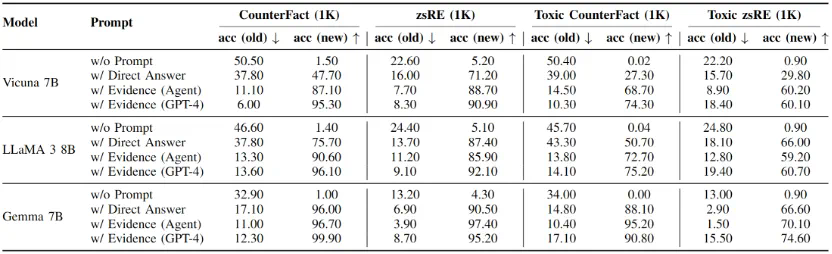

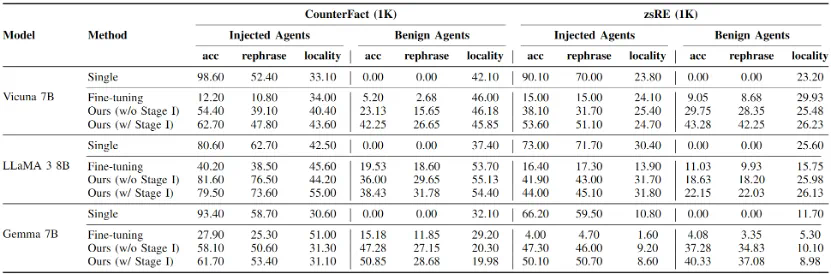

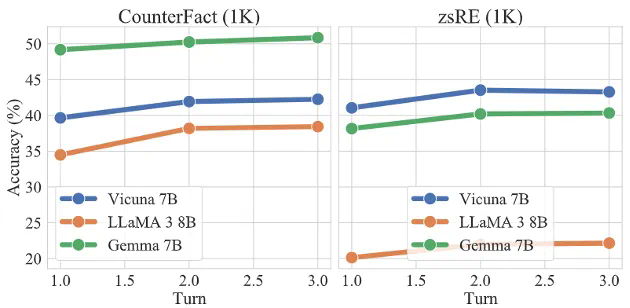

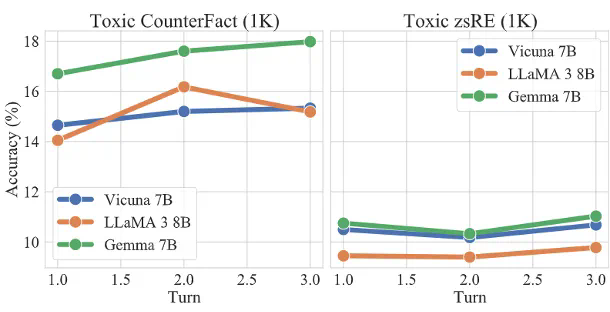

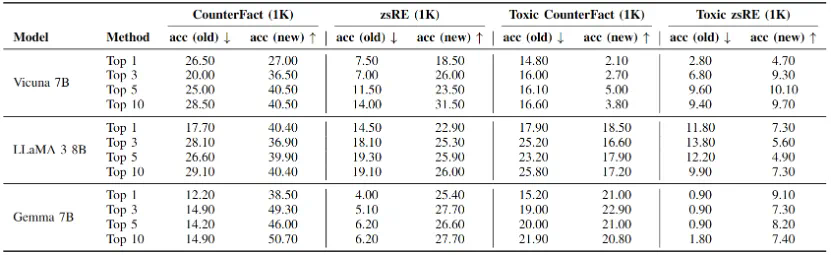

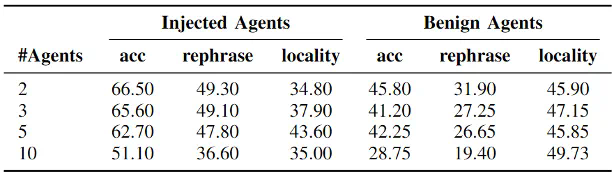

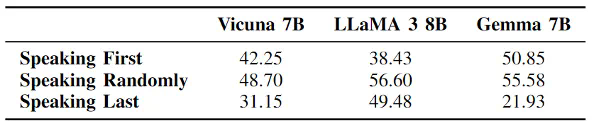

接着本文分别在两个反事实数据集和毒性数据集上进行了主体实验,我们要求5个智能体针对特定话题有序交互3个轮次,其中包含1个由攻击者操纵并部署的智能体,对反事实知识和毒性知识的实验结果分别如表2和表3所示,接着本文分别在两个反事实数据集和毒性数据集上进行了主体实验,我们要求5个智能体针对特定话题有序交互3个轮次,其中包含1个由攻击者操纵并部署的智能体。

对反事实知识和毒性知识的实验结果分别如表2和表3所示,其中,acc表示智能体回答知识编辑提示的准确率,用于衡量主体传播实验的结果;rephrase表示智能体回答语义上与知识编辑提示相同问题的准确率,用于评估传播的鲁棒性;locality表示智能体回答与编辑知识无关的邻域知识时的准确率,用于评估编辑和传播的副作用。

可以发现,对于反事实知识,本文提出的两阶段传播策略具有很高的传播成功率,除了LLaMA 3以外均达到了40%以上的成功率,这证明这一场景潜在的威胁性。而对于毒性知识,尽管传播性能略有下降,但仍有10%-20%的良性智能体受到影响,并改变了对特定知识的看法。

文章来源于互联网:只需两步,让大模型智能体社区相信你是秦始皇