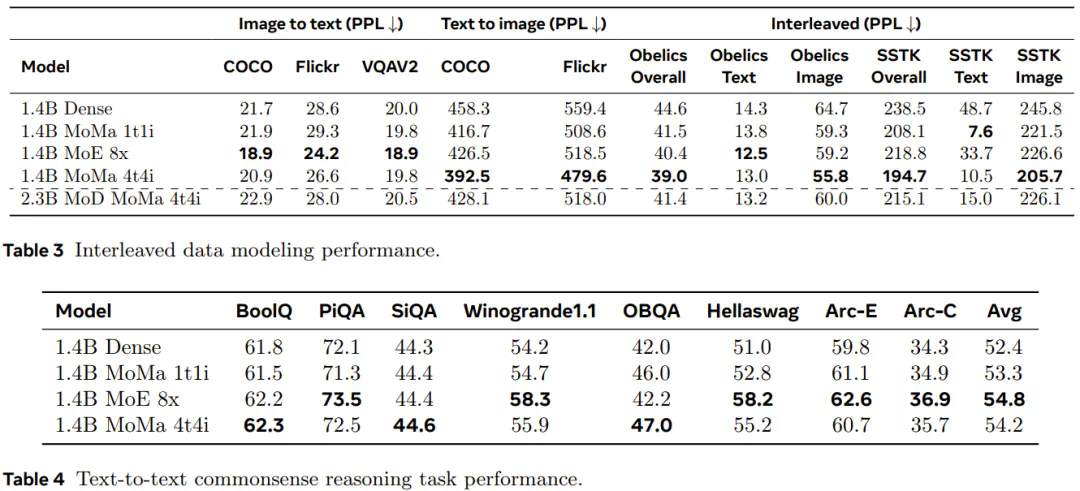

文章来源于互联网:混合专家更有主见了,能感知多模态分情况行事,Meta提出模态感知型专家混合

混合专家,也得术业有专攻。

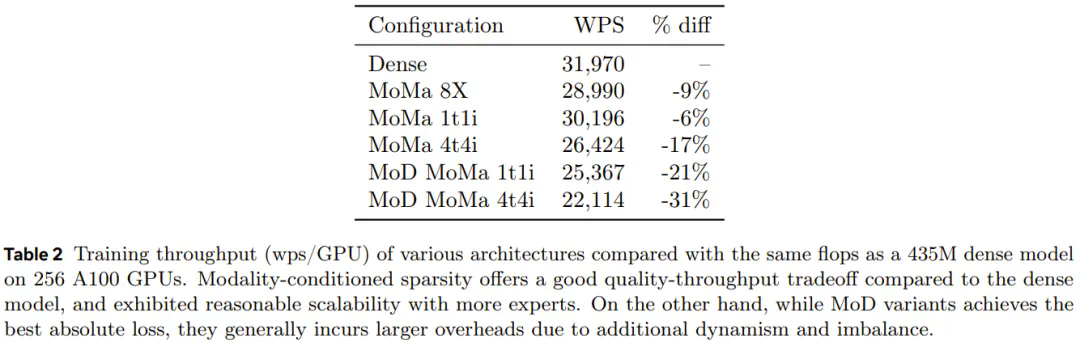

-

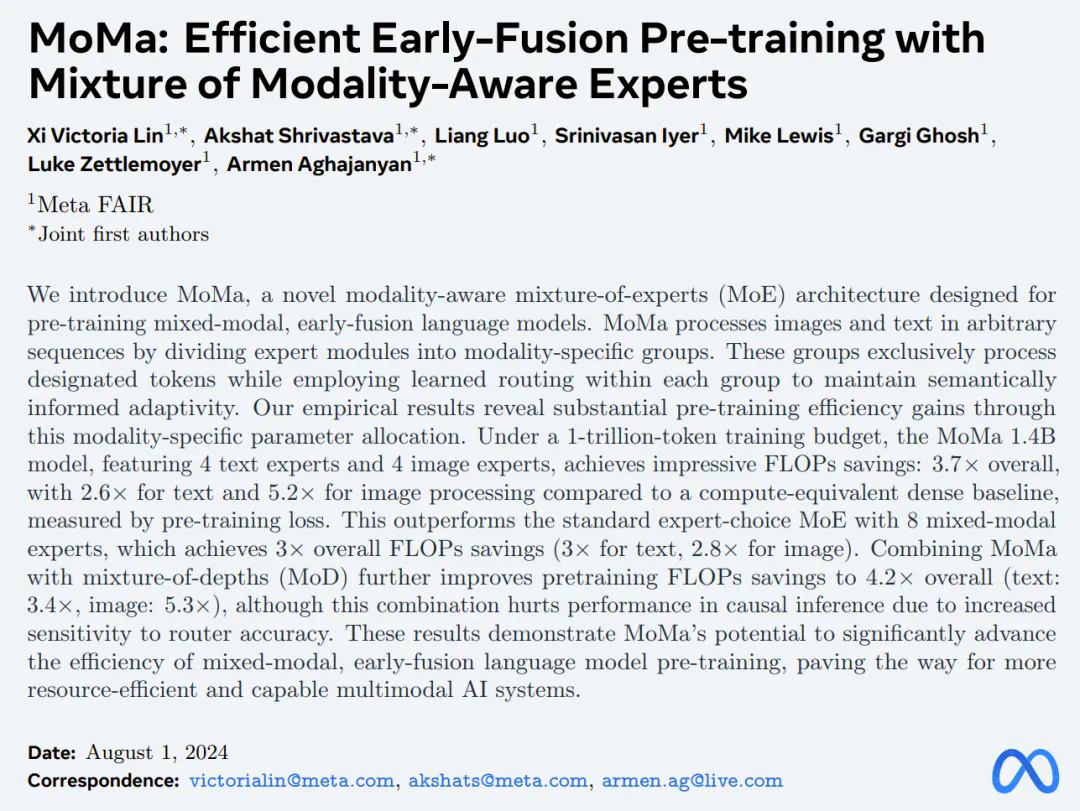

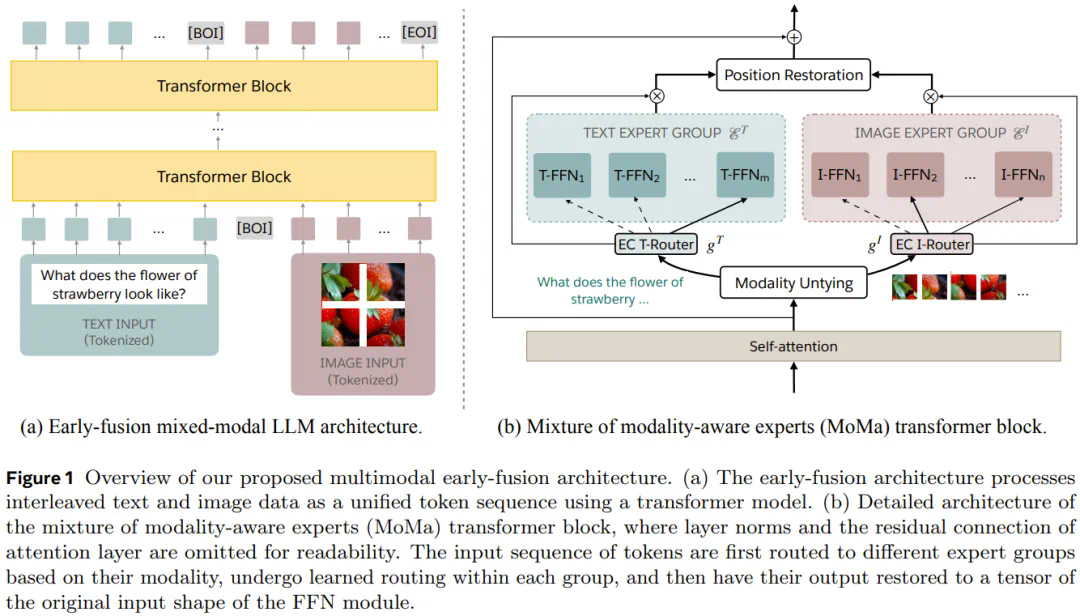

论文标题:MoMa: Efficient Early-Fusion Pre-training with Mixture of Modality-Aware Experts -

论文地址:https://arxiv.org/pdf/2407.21770

-

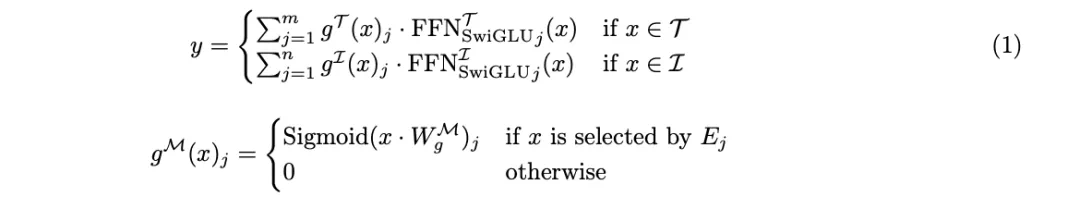

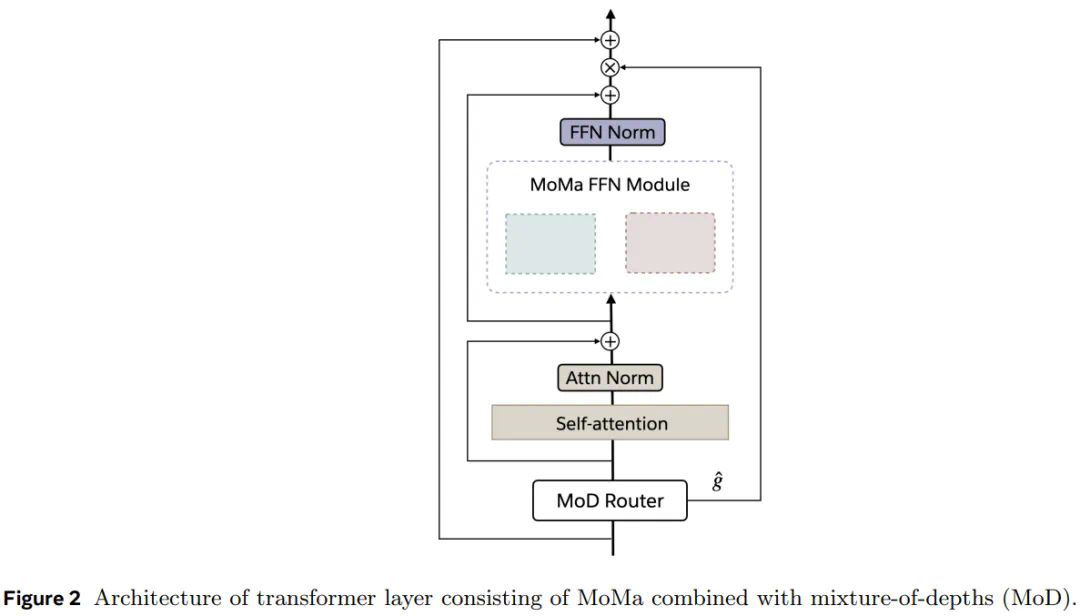

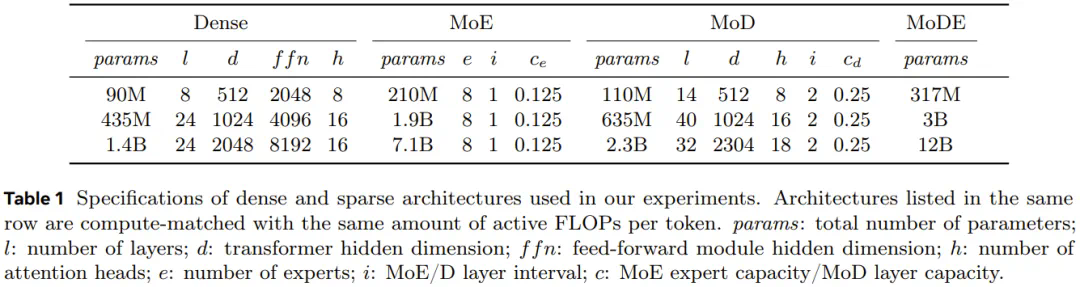

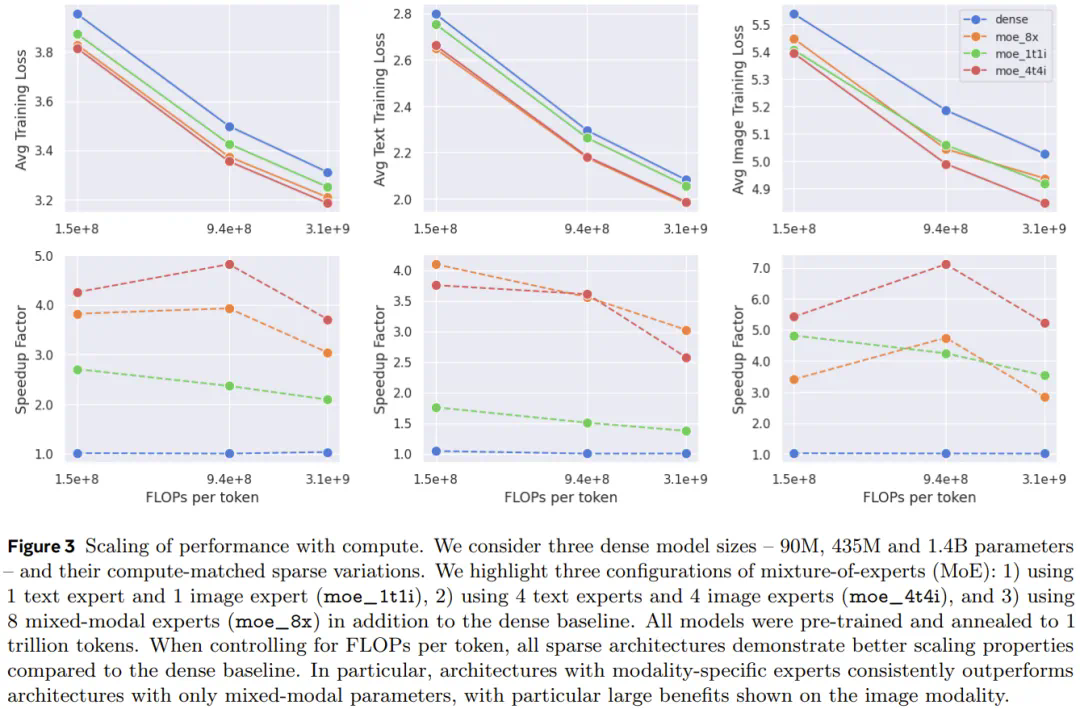

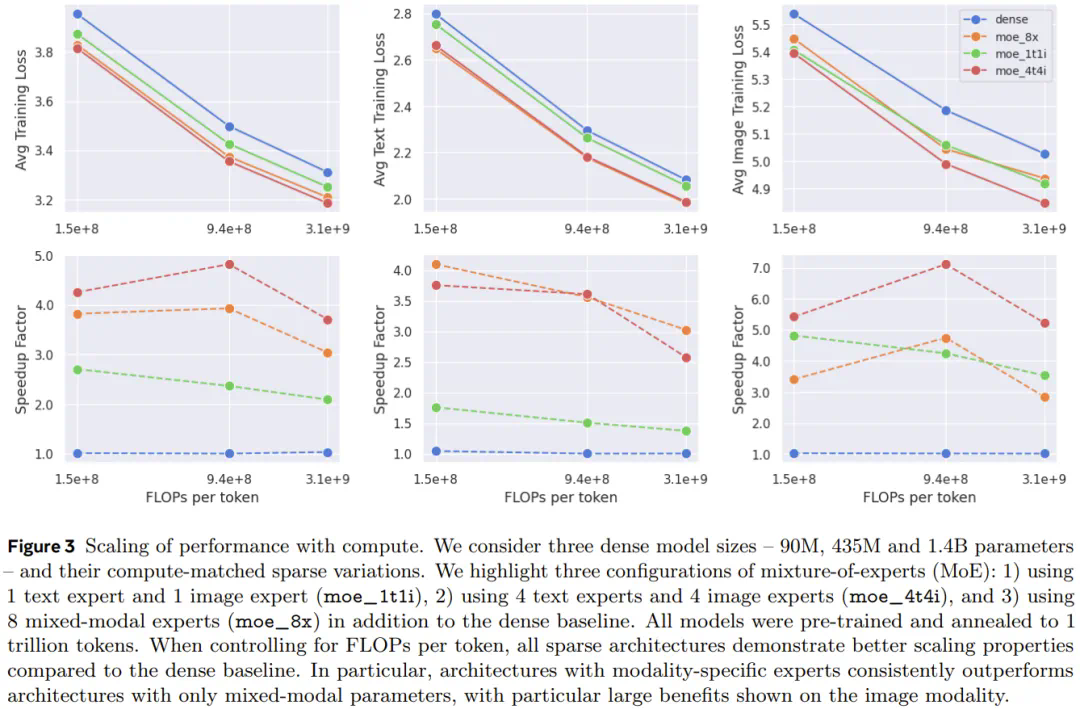

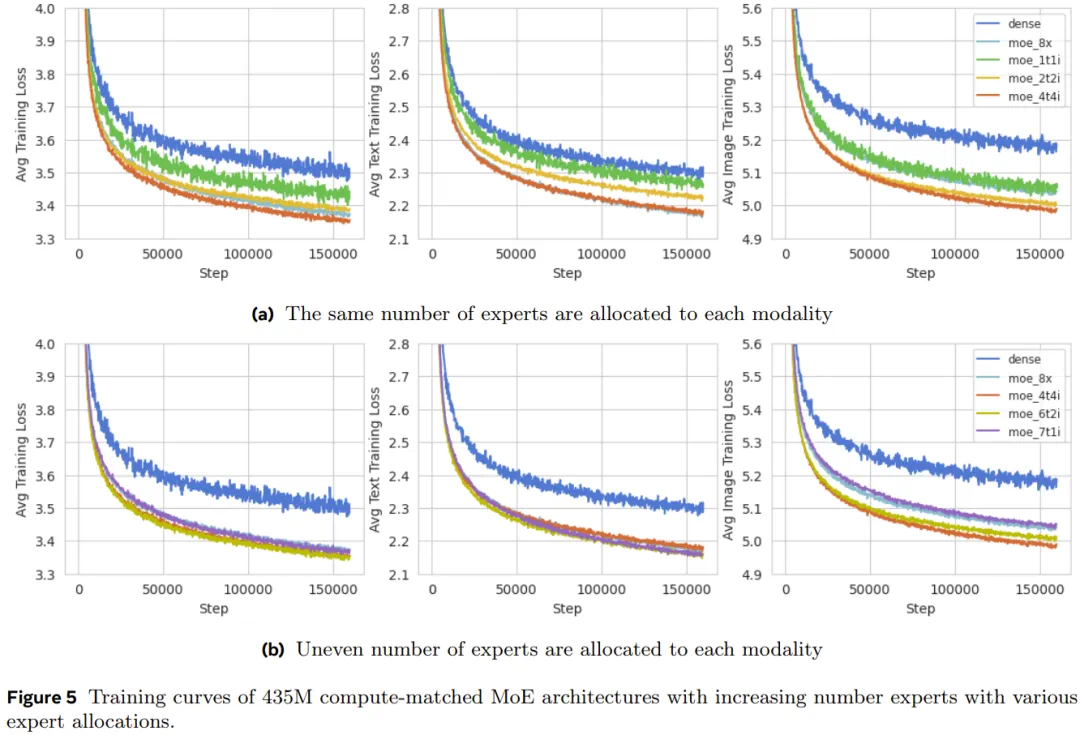

将各个模态的专家限制为同构的专家,并禁止将文本 token 路由到图像专家,反之亦然; -

使用模块稀疏性(block sparsity)来提升执行效率; -

当模态的数量有限时,按顺序运行不同模态的专家。