文章来源于互联网:国内首个自研MoE多模态大模型,揭秘腾讯混元多模态理解

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

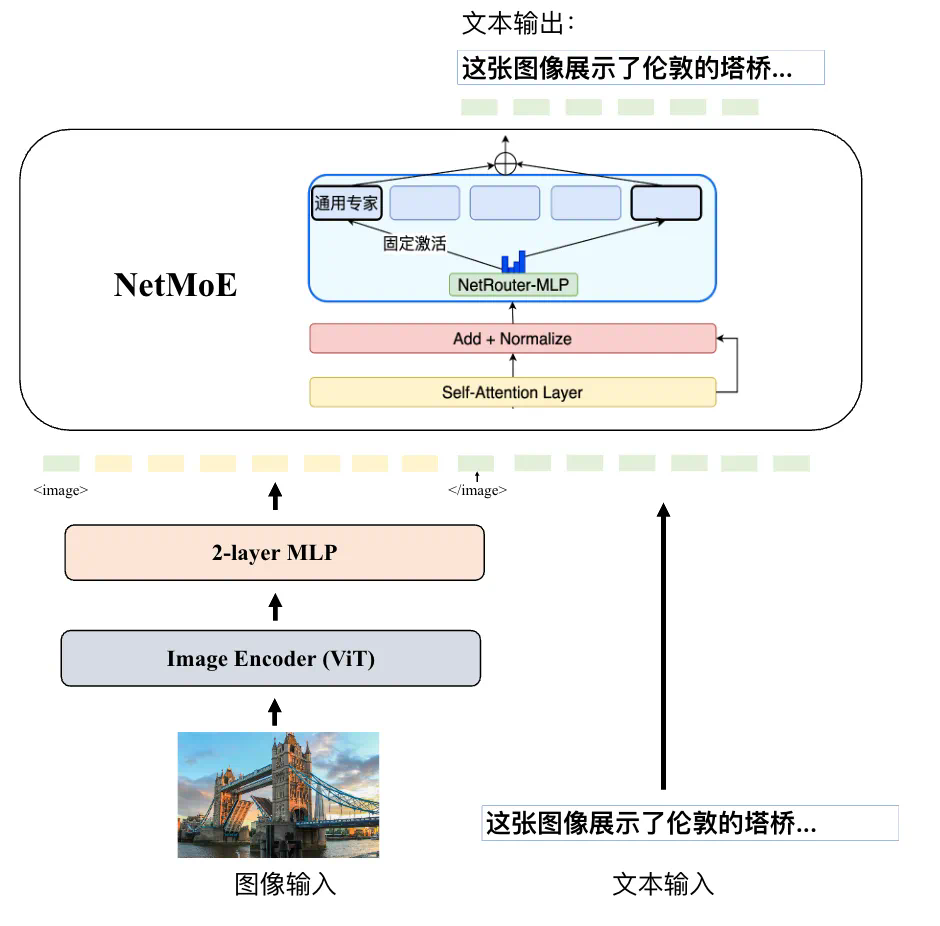

支持原生任意分辨率:与业界主流的固定分辨率或切子图方法相比,腾讯混元多模态模型能够处理原生任意分辨率的图片,实现了首个支持超过 7K 分辨率和任意长宽比(例如 16:1,见下文例子)图片理解的多模态模型。 -

采用简单的 MLP 适配器:相较于此前主流的 Q-former 适配器,MLP 适配器在信息传递过程中损失更小。

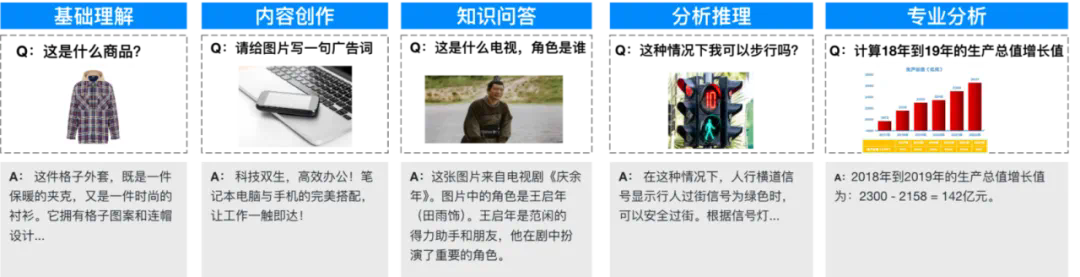

解释一段代码:

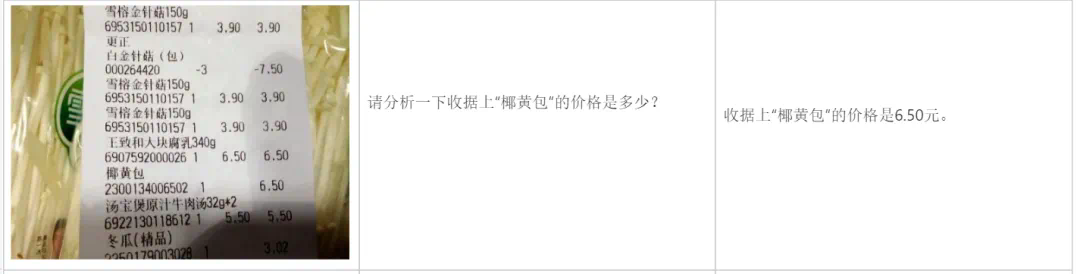

分析账单:

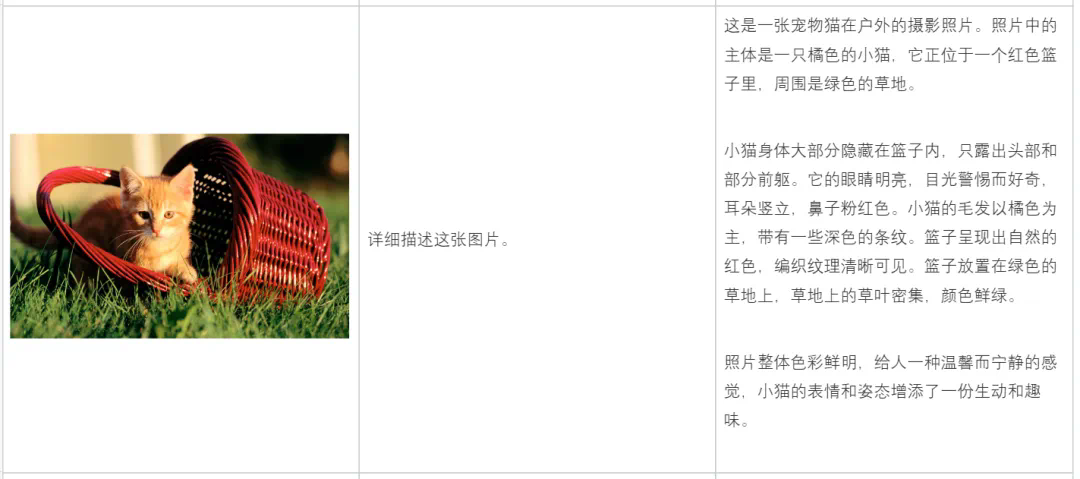

描述图片内容:

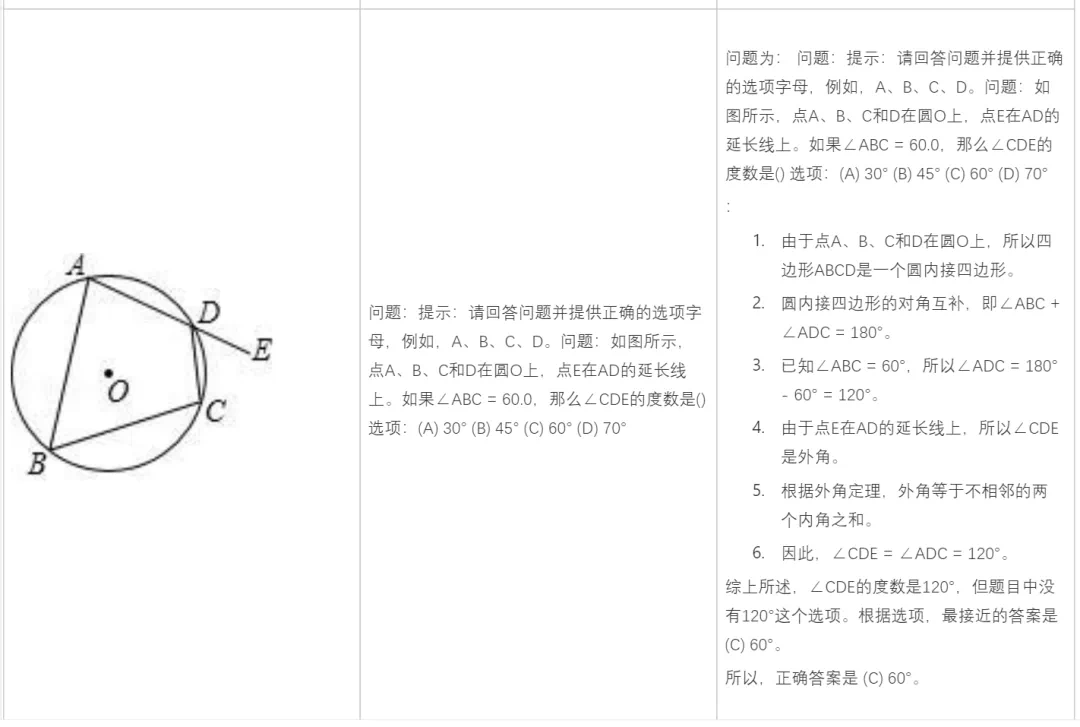

做数学题:

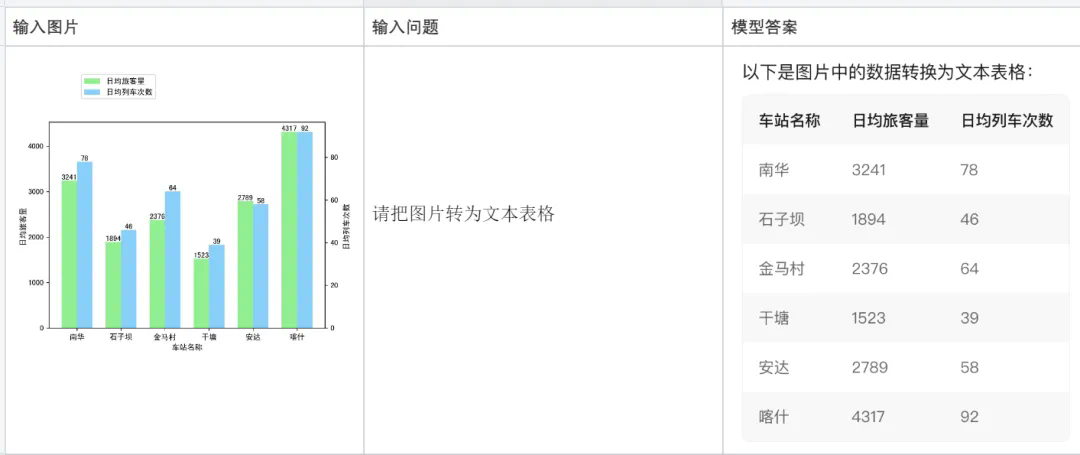

根据图片内容,进行分析:

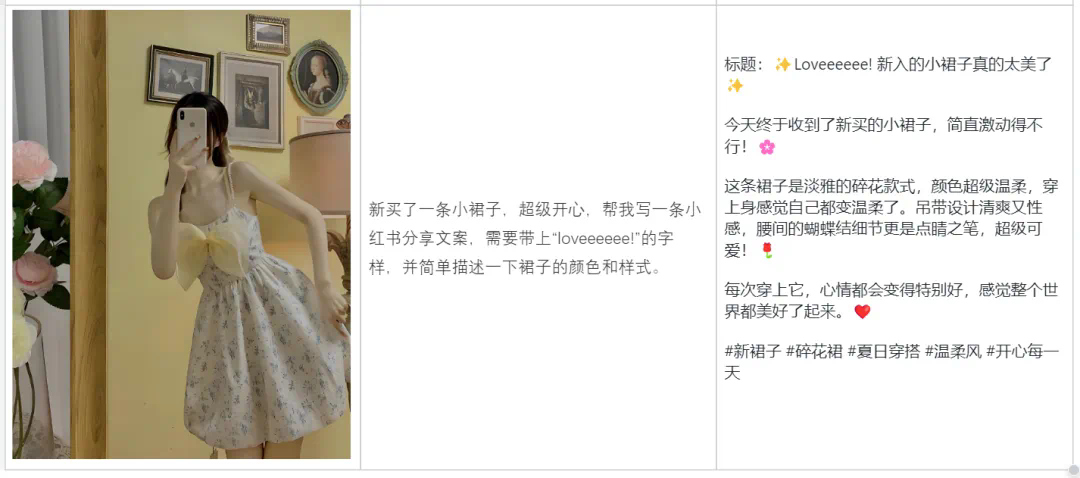

帮你写文案:

目前腾讯混元多模态理解大模型已在 AI 助手产品腾讯元宝上线,并通过腾讯云面向企业及个人开发者开放。

腾讯元宝地址:https://yuanbao.tencent.com/chat

文章来源于互联网:国内首个自研MoE多模态大模型,揭秘腾讯混元多模态理解