文章来源于互联网:边缘智能的新时代:端侧大模型的研究进展综述

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

- Jiajun Xu : Meta AI科学家,专注大模型和智能眼镜开发。南加州大学博士,Linkedin Top AI Voice,畅销书作家。他的AI科普绘本AI for Babies (“宝宝的人工智能”系列,双语版刚在国内出版) 畅销硅谷,曾获得亚马逊儿童软件、编程新书榜榜首。

-

Zhiyuan Li : Nexa AI CTO,斯坦福校友,前斯坦福CEO协会主席, Octopus系列论文作者。他在 Google Labs 和 Amazon Lab126 拥有丰富的端侧 AI 模型训练、部署和产品开发经验。

-

Wei Chen : Nexa AI CEO,斯坦福博士,前斯坦福CEO协会主席。他深耕人工智能领域,先后发表多篇Octopus系列模型论文,其中Octopus-V2模型曾在huggingface全球60万模型中位列第二,并在Google 2024 IO上被feature。

-

Qun Wang : 旧金山州立大学计算机系助理教授,曾在劳伦斯伯克利国家重点实验室做博后,犹他州立大学博士。研究方向主要集中在下一代通信网络中边缘计算的能效和安全优化,以及边缘智能系统的通信和训练加速。先后在IEEE发布多篇论文。

-

Xin Gao, Qi Cai : 北德州大学博士生

-

Ziyuan Ling : Nexa AI 初创设计师,伯克利设计系研究生

-

论文标题:On-Device Language Models: A Comprehensive Review -

论文链接:https://arxiv.org/abs/2409.00088 -

相关链接:LLMsOnDevice.com

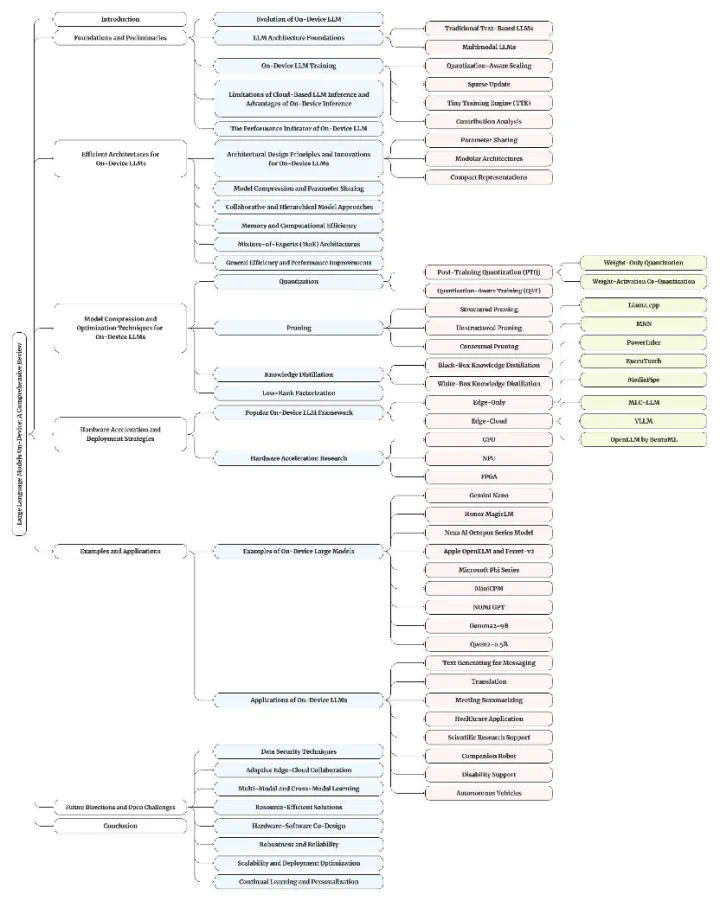

然而,要在资源受限的设备上部署这些强大的模型,我们必须面对内存和计算能力的双重挑战。研究者们通过量化感知缩放、稀疏更新等创新方法,有效解决了这些问题,使得大型模型即便在参数量巨大的情况下,也能在设备端高效运行。

文章来源于互联网:边缘智能的新时代:端侧大模型的研究进展综述