文章来源于互联网:CoT能让模型推理能力无上限?田渊栋、LeCun下场反对:两层MLP还能模拟全世界呢

「这相当于在理论上,两层神经网络在理论上可以拟合任何数据,我们就盲目相信并应用在所有场景中。」

-

论文链接:https://arxiv.org/abs/2402.12875

-

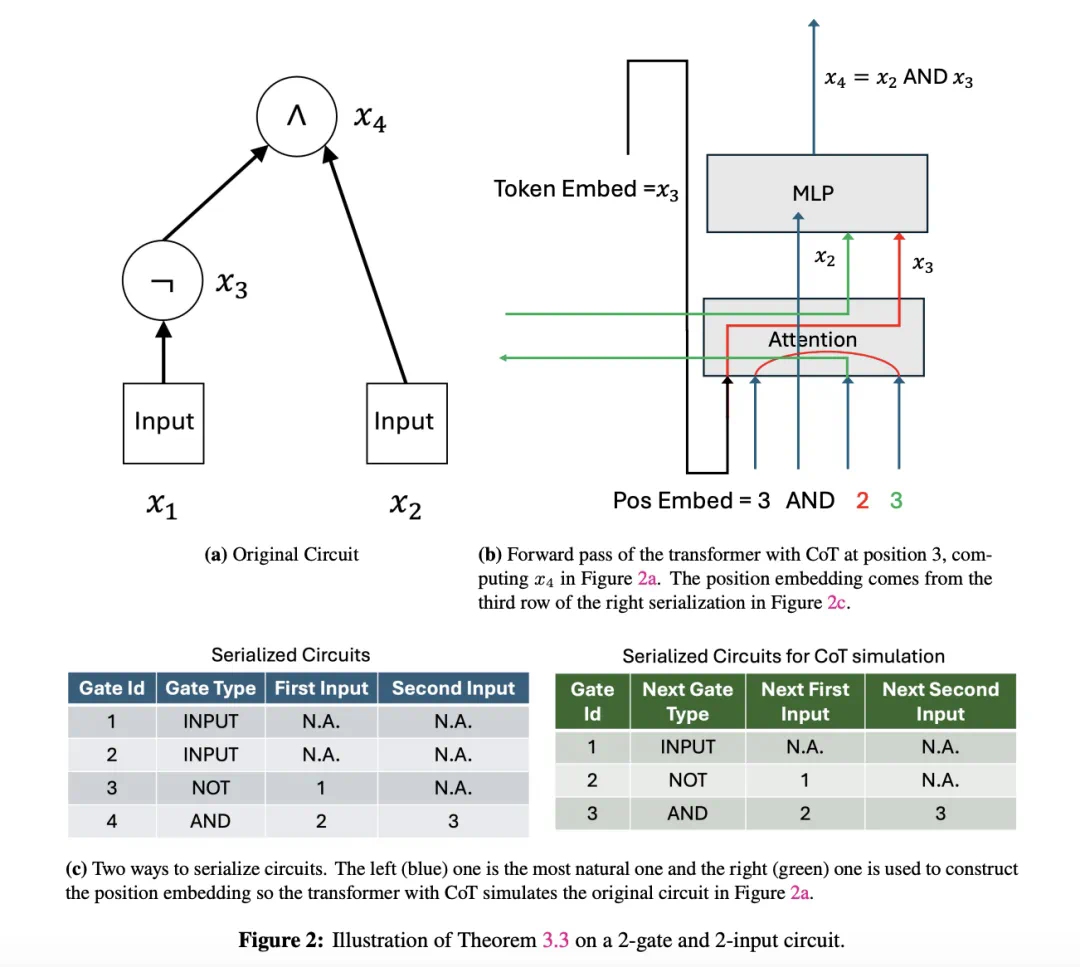

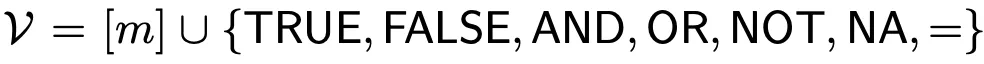

AC⁰:仅使用 AND、OR、NOT 门,深度为常数,通常适用于比较简单的并行计算问题。 -

TC⁰:扩展了 AC⁰类问题,增加了多数决定门(MAJORITY gates),能处理更复杂的并行计算问题。

-

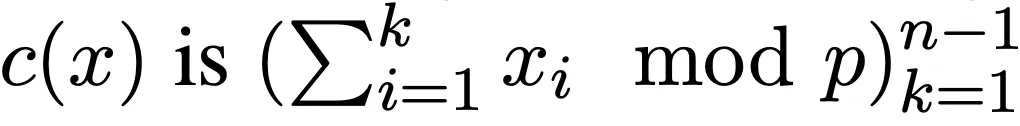

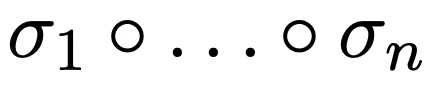

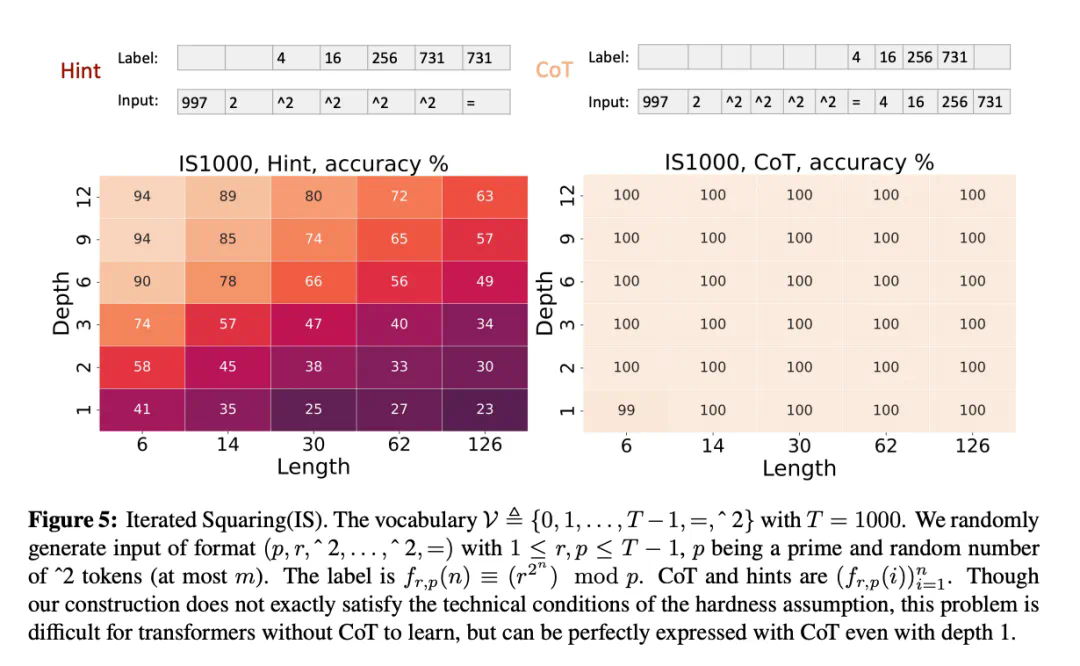

Base 模式:模型直接生成结果,目标是最小化预测结果与真实值之间的差距。 -

CoT 模式:在每个问题上为模型手动设计了思维链,评估模型是否能够正确预测整个思维链中的每个 token。 -

Hint 模式:为模型提供部分提示信息,帮助其更好地生成中间步骤。对于 Base 模式和 Hint 模式,直接评估最终答案的准确性。

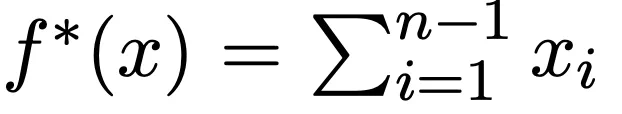

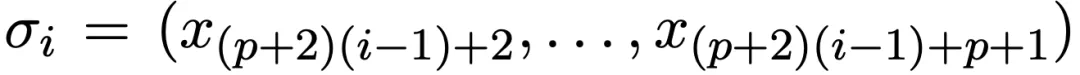

;引入 CoT 后为,

;引入 CoT 后为, 。

。

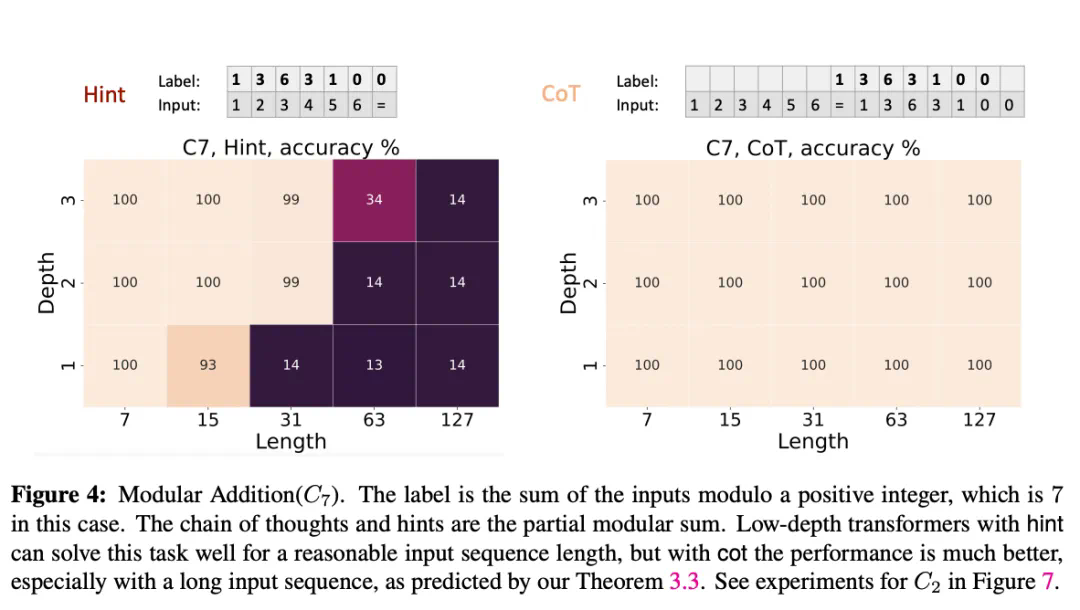

。最终输出是将所有排列组合整合在一起的结果:

。最终输出是将所有排列组合整合在一起的结果: 。

。

。

。

,计算出电路最后的逻辑门 m 的值。

,计算出电路最后的逻辑门 m 的值。

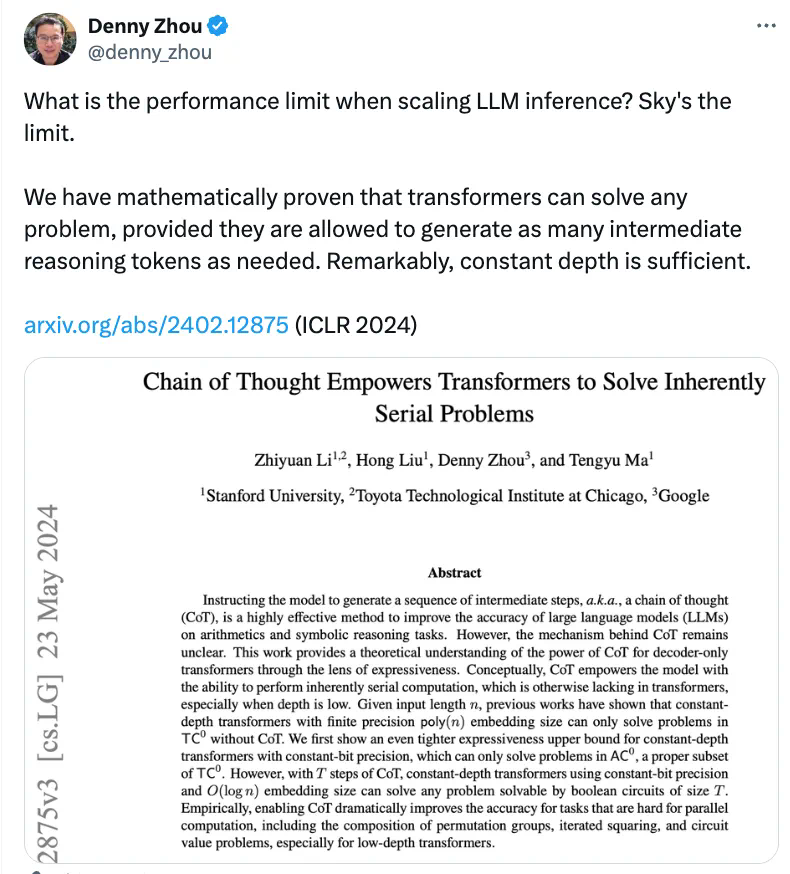

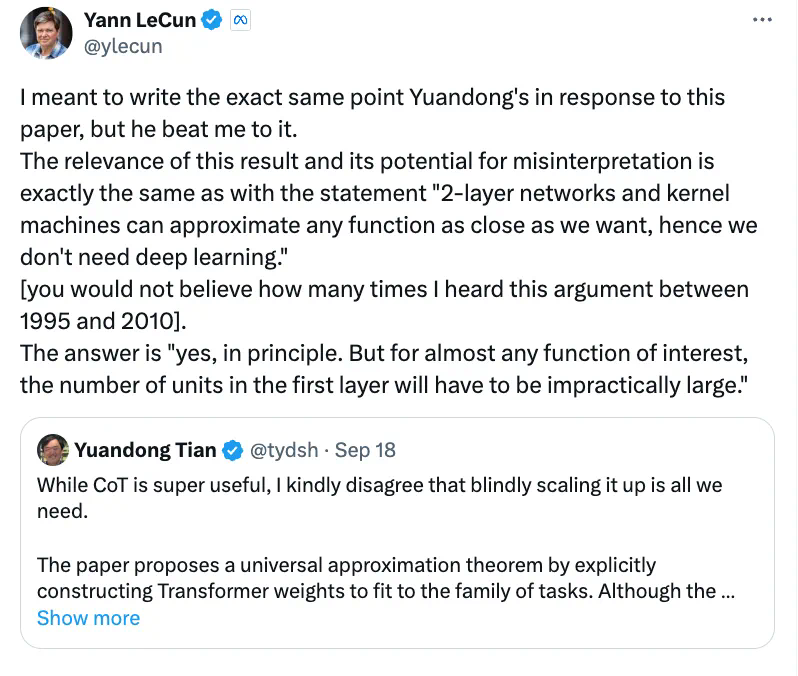

尽管 CoT 非常有用,但我并不完全同意仅靠盲目扩展它就能解决所有问题。论文中提出了一种通用理论 —— 我们可以显式地构建 Transformer 的权重,使其更好地适应特定任务。虽然模型的深度可以保持常数,但 CoT 的长度可能会非常长,而这种权重能否通过梯度下降算法学到,仍是未知数。

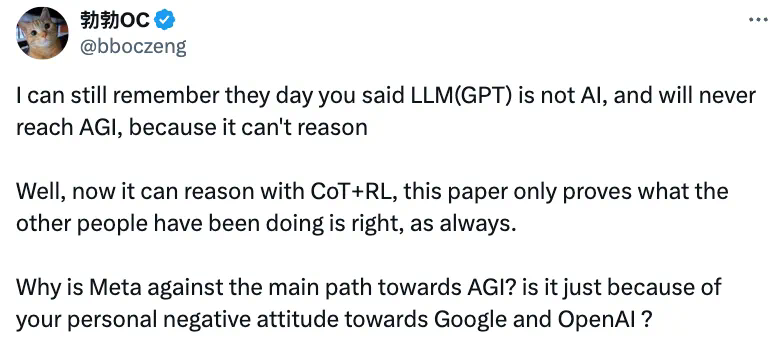

我还记得你曾说过,LLM(GPT)不是 AI,也永远无法达到 AGI,因为它无法进行推理。

然而,现在通过 CoT+RL,它可以推理了。这篇论文只是证明了其他人一直以来所做的是正确的,一如既往。

为什么 Meta 反对通往 AGI 的主流路径?难道只是因为你个人不喜欢 Google 和 OpenAI 吗?