文章来源于互联网:刚刚,Llama 3.2 来了!支持图像推理,还有可在手机上运行的版本

-

Llama 3.1 8B 升级成 Llama 3.2 11B Vision -

Llama 3.1 70B 升级成 Llama 3.2 90B Vision

-

文章目录

Toggle官网下载:https://llama.meta.com

-

Hugging Face:https://huggingface.co/meta-llama

-

提示词和响应可以带来即时完成的感觉,因为处理过程都在本地进行; -

本地运行模型时,无需将消息和日历等隐私信息上传到云端,从而保证信息私密。由于处理是在本地进行,因此可让应用判断哪些任务可以在本地完成,哪些需要借助云端的更强大模型。

模型评估

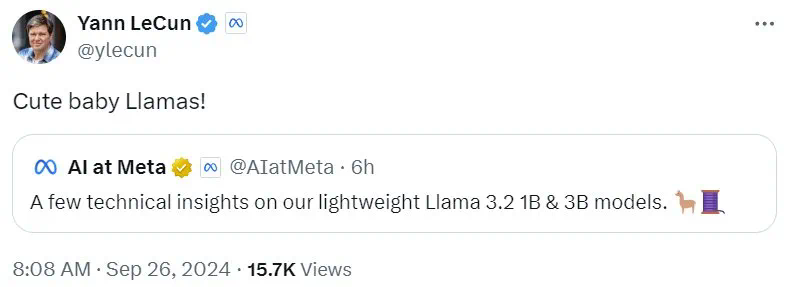

视觉模型

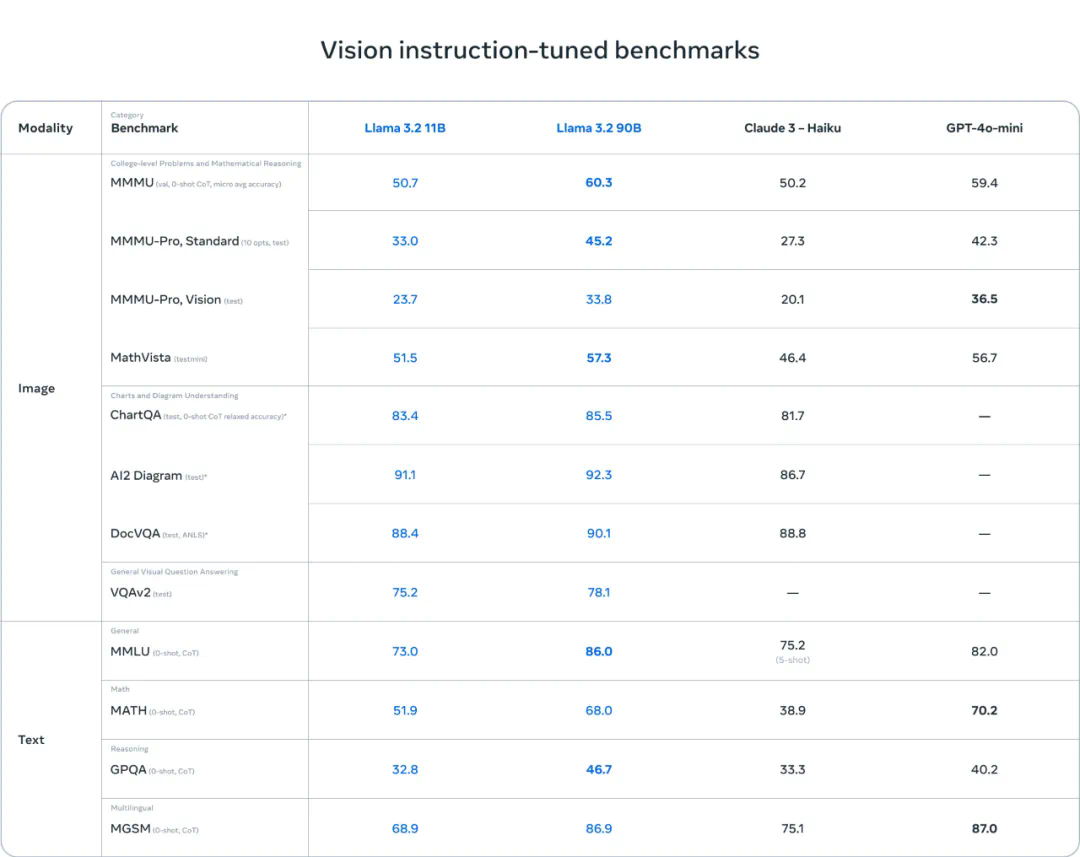

轻量级模型

以上演示基于一个未发布的量化模型

以上演示基于一个未发布的量化模型

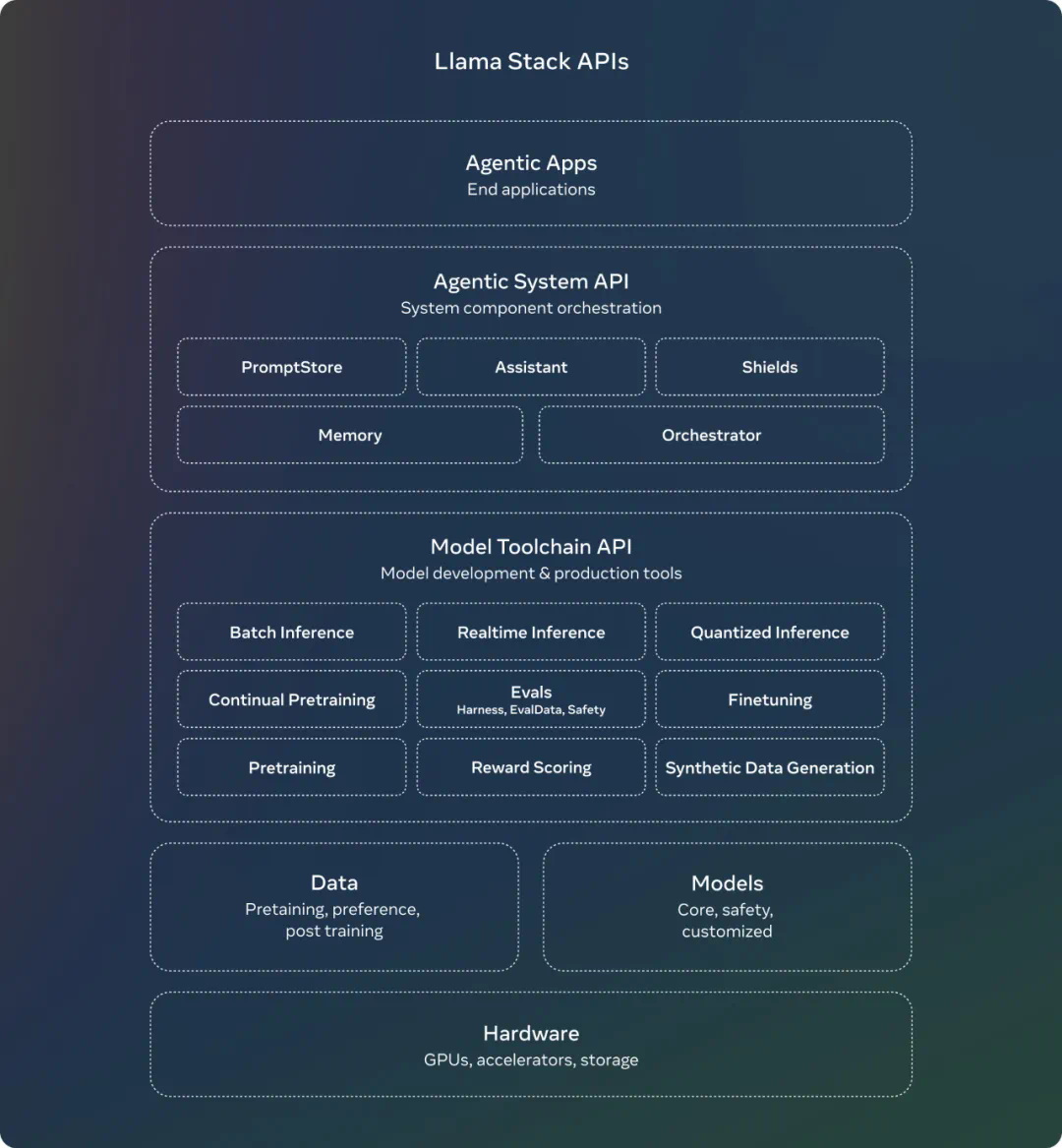

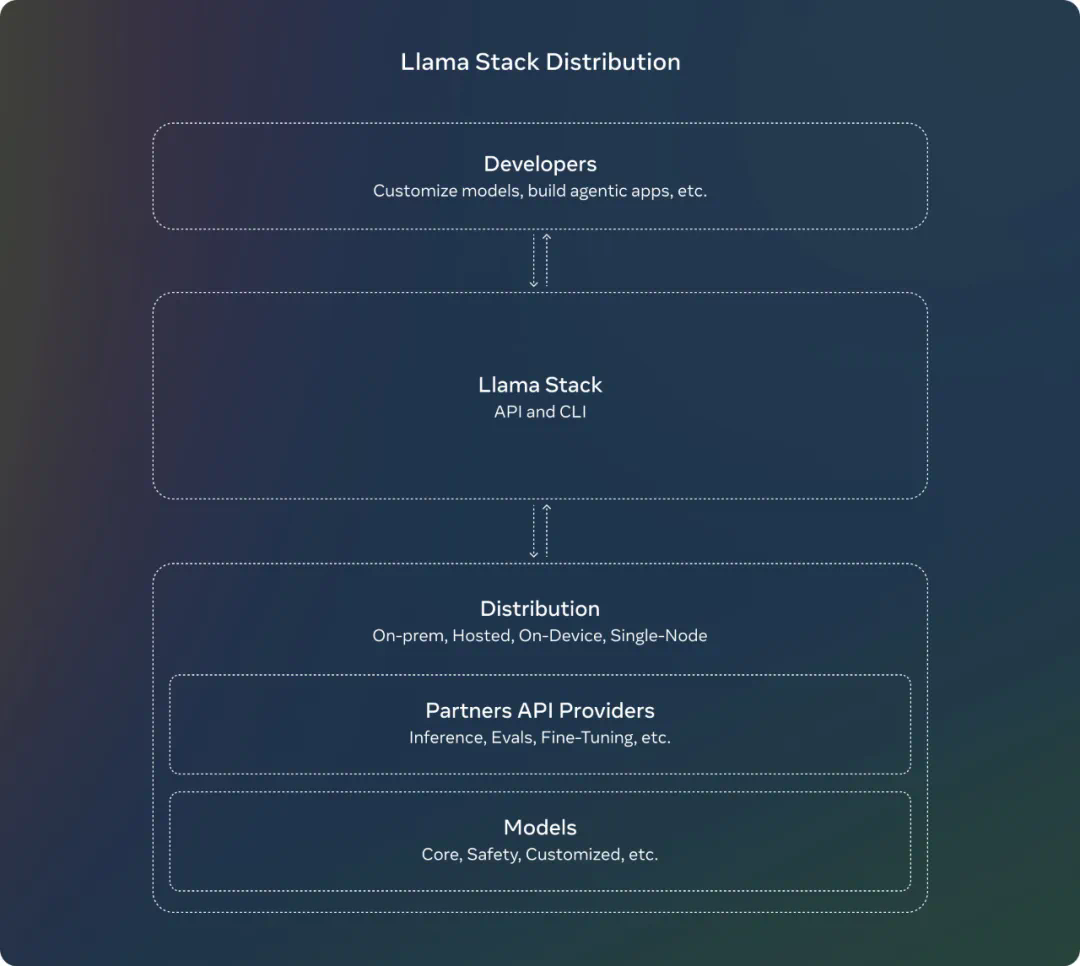

Llama Stack 发行版

-

Llama CLI(命令行界面),用于构建、配置和运行 Llama Stack 发行版 -

多语言客户端代码,包括 Python、Node、Kotlin 和 Swift -

Llama Stack Distribution Server 和 Agents API Provider 的 Docker 容器 -

多个发行版 -

-

通过 Meta 内部实现和 Ollama 提供的单节点 Llama Stack 发行版 -

通过 AWS、Databricks、Fireworks 和 Together 提供的云 Llama Stack 发行版 -

通过 PyTorch ExecuTorch 在 iOS 上实现的设备上 Llama Stack 发行版 -

由 Dell 支持的本地 Llama Stack 发行版

-

系统级安全

-

首先,他们发布了 Llama Guard 3 11B Vision,它旨在支持 Llama 3.2 的新图像理解能力,并过滤文本 + 图像输入提示或这些提示的文本输出响应。 -

其次,由于 Meta 发布了 1B 和 3B 的 Llama 模型,用于更受限的环境,如设备上使用,他们还优化了 Llama Guard,大幅降低了其部署成本。Llama Guard 3 1B 基于 Llama 3.2 1B 模型,经过剪枝和量化,其大小从 2,858 MB 减少到 438 MB,使其部署变得更加高效。

参考链接:https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/

文章来源于互联网:刚刚,Llama 3.2 来了!支持图像推理,还有可在手机上运行的版本