文章来源于互联网:还是原装Transformer好!北大清华团队同时揭示Mamba等推理短板

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

北京大学的工作来自智能学院王立威、贺笛老师课题组,发表于ICML 2024。作者包括北京大学图灵班本科生杨铠;苏黎世联邦理工学院硕士生Jan Ackermann;北京大学智能学院博士生何震宇、冯古豪、张博航;纽约大学博士生冯韫禛;北京智源研究院研究员叶启威;清华大学的工作来自于明年即将入职清华大学交叉信息院做助理教授、目前在加州大学伯克利分校 Simons Institute 做博士后的吕凯风研究员。作者包括斯坦福在读一年级博士温凯越;清华大学姚班本科生党星宇。

-

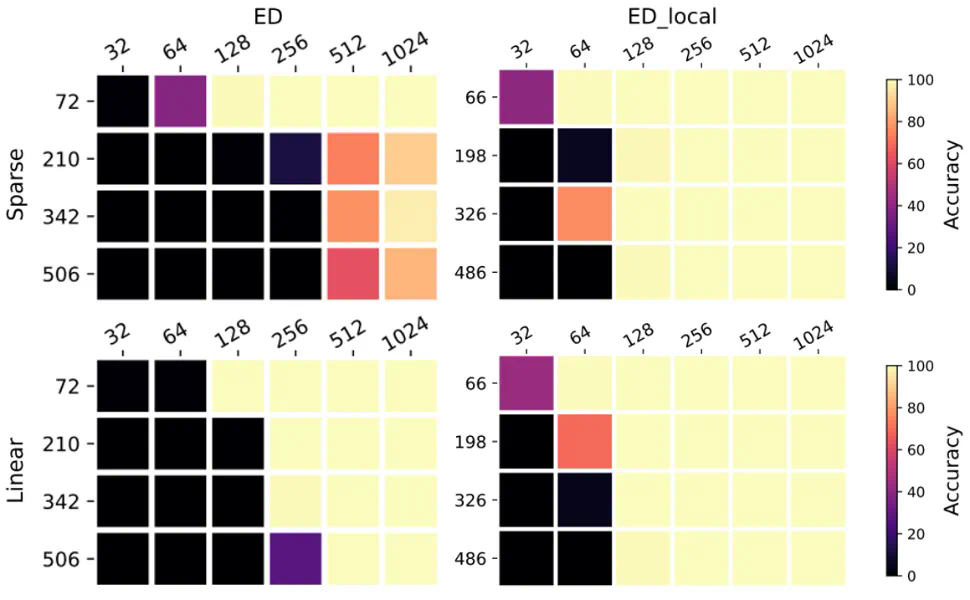

论文 1:Do Efficient Transformers Really Save Computation? (发表于 ICML 2024) -

论文链接:https://arxiv.org/abs/2402.13934

-

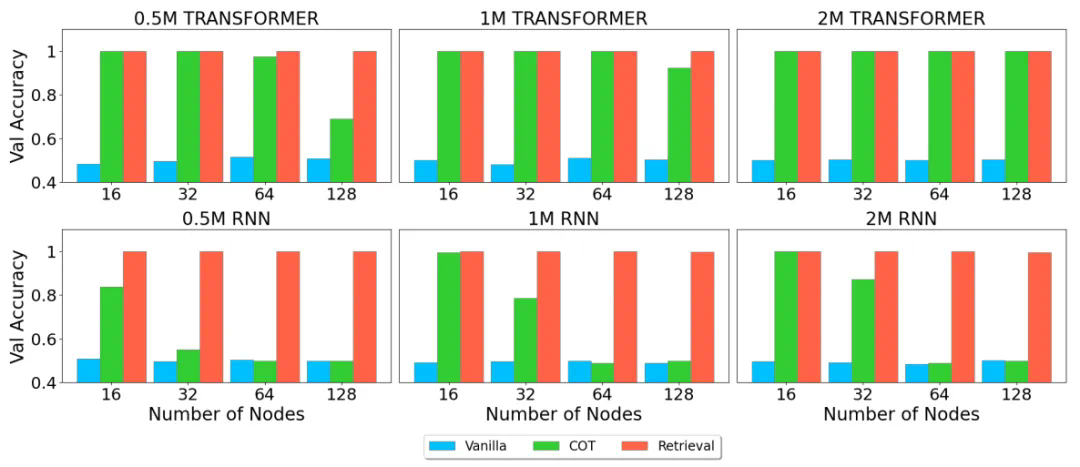

论文 2:RNNs are not Transformers (Yet): The Key Bottleneck on In-context Retrieval -

论文链接:https://arxiv.org/abs/2402.18510