文章来源于互联网:让机器人拥有人一样「潜意识」,英伟达1.5M小模型就能实现通用控制了

当机器人也有潜意识。

-

论文标题:HOVER: Versatile Neural Whole-Body Controller for Humanoid Robots -

论文地址:https://arxiv.org/pdf/2410.21229 -

项目地址:https://hover-versatile-humanoid.github.io/

-

头部和手部姿势,可通过 Apple Vision Pro 等增强现实设备捕捉; -

全身姿势,可通过 MoCap 或 RGB 相机; -

全身关节角度:外骨骼; -

根速度命令:操纵杆。

-

一个统一的界面,可让控制者使用任何方便的输入设备来控制机器人; -

一种更简单的全身远程操作数据收集方法; -

一个上游的视觉 – 语言 – 动作模型,可用于提供运动指令,之后 HOVER 会将其转换为高频的低级运动信号。

。

。-

动作

表示目标关节位置,这些位置会被输入到 PD 控制器中以驱动机器人,他们使用了近端策略优化 (PPO) 算法来最大化累积折扣奖励

表示目标关节位置,这些位置会被输入到 PD 控制器中以驱动机器人,他们使用了近端策略优化 (PPO) 算法来最大化累积折扣奖励

-

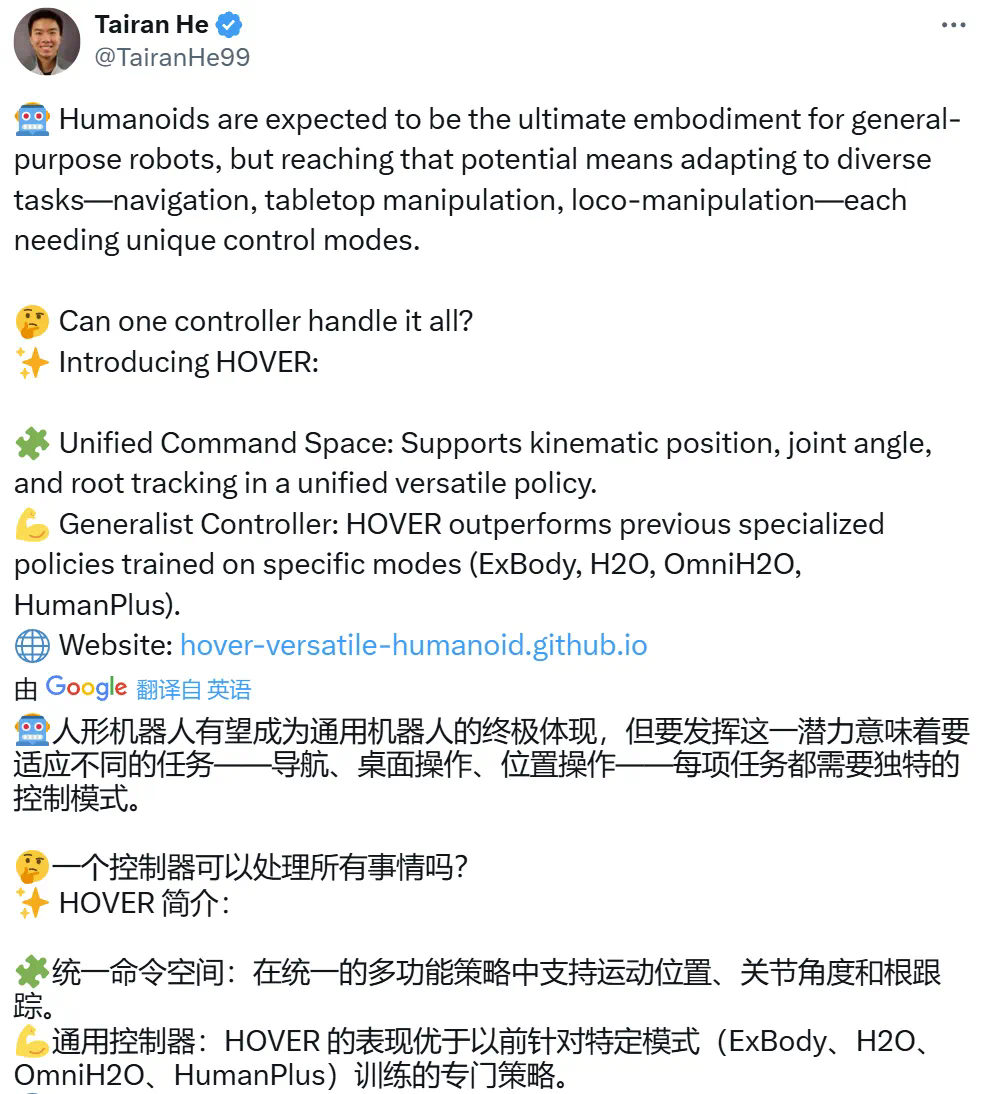

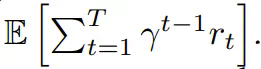

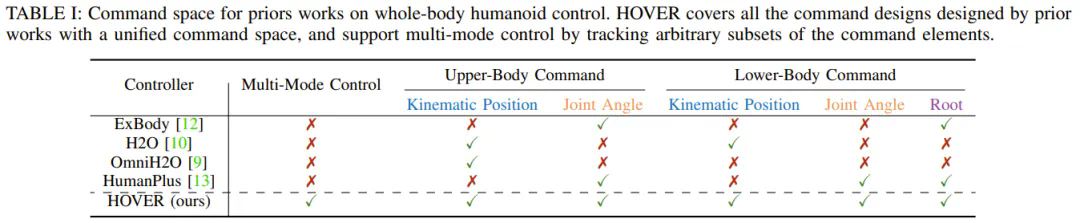

通用性:命令空间应包含大多数现有配置,允许通用控制器替换针对特定任务的控制器,同时还不会牺牲性能或多功能性。并且该空间应具有足够的表现力,以便与现实世界的控制设备交互,包括操纵杆、键盘、动作捕捉系统、外骨骼和虚拟现实 (VR) 头设,如图 1 所示。 -

原子性:命令空间应由独立的维度组成,从而能够任意组合控制选项以支持各种模式。

-

运动位置跟踪:机器人上关键刚体点的目标 3D 位置; -

局部关节角度跟踪:每个机器人电机的目标关节角度; -

根跟踪:目标根速度、高度和方向,由滚动、俯仰和偏航角指定。

-

运动重定向

-

状态空间设计

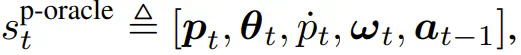

其中 p_t 是人形机器人刚体位置 、θ_t 是方向、p_t 是线速度、 ω_t 是角速度、a_{t−1} 是前一个动作。本体感觉定义为

其中 p_t 是人形机器人刚体位置 、θ_t 是方向、p_t 是线速度、 ω_t 是角速度、a_{t−1} 是前一个动作。本体感觉定义为

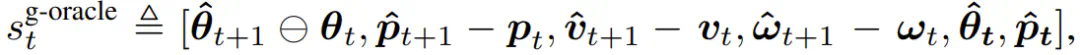

其中包含参考姿态以及人形机器人所有刚体的参考状态与当前状态之间的一帧差异。他们使用的策略网络结构为层尺寸为 [512, 256, 128] 的三层 MLP。

其中包含参考姿态以及人形机器人所有刚体的参考状态与当前状态之间的一帧差异。他们使用的策略网络结构为层尺寸为 [512, 256, 128] 的三层 MLP。-

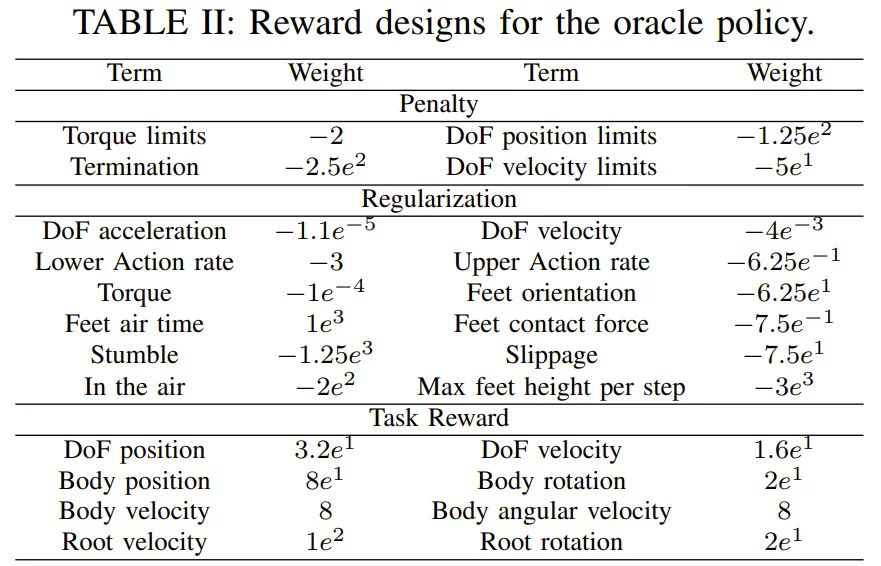

奖励设计和域随机化

-

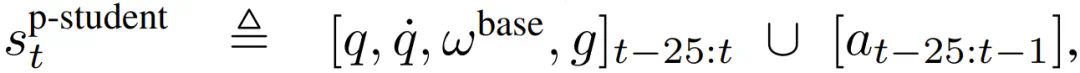

本体感受

其中 q 是关节位置,

其中 q 是关节位置,  是关节速度,ω^base 是基准角速度,g 是重力向量,a 是动作历史。

是关节速度,ω^base 是基准角速度,g 是重力向量,a 是动作历史。

-

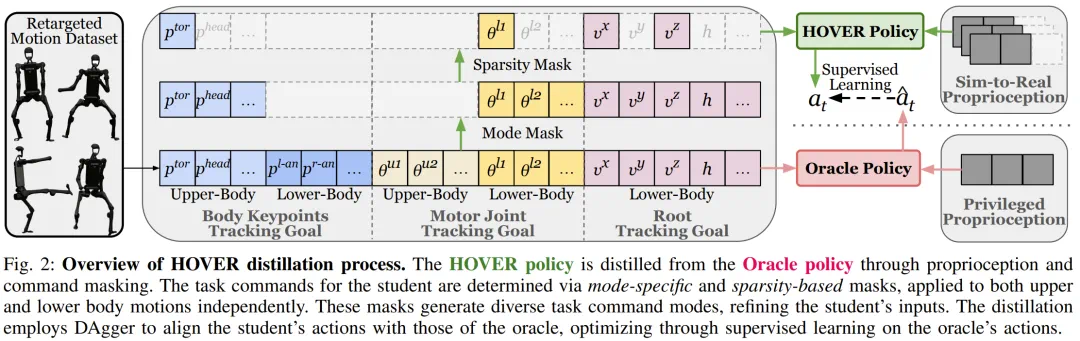

命令掩码

-

策略蒸馏

,从而得到

,从而得到 的轨迹。

的轨迹。 使用这些 oracle 状态,可以查询 oracle 教师策略

使用这些 oracle 状态,可以查询 oracle 教师策略 以获得参考动作

以获得参考动作

来更新学生策略 π^student。

来更新学生策略 π^student。-

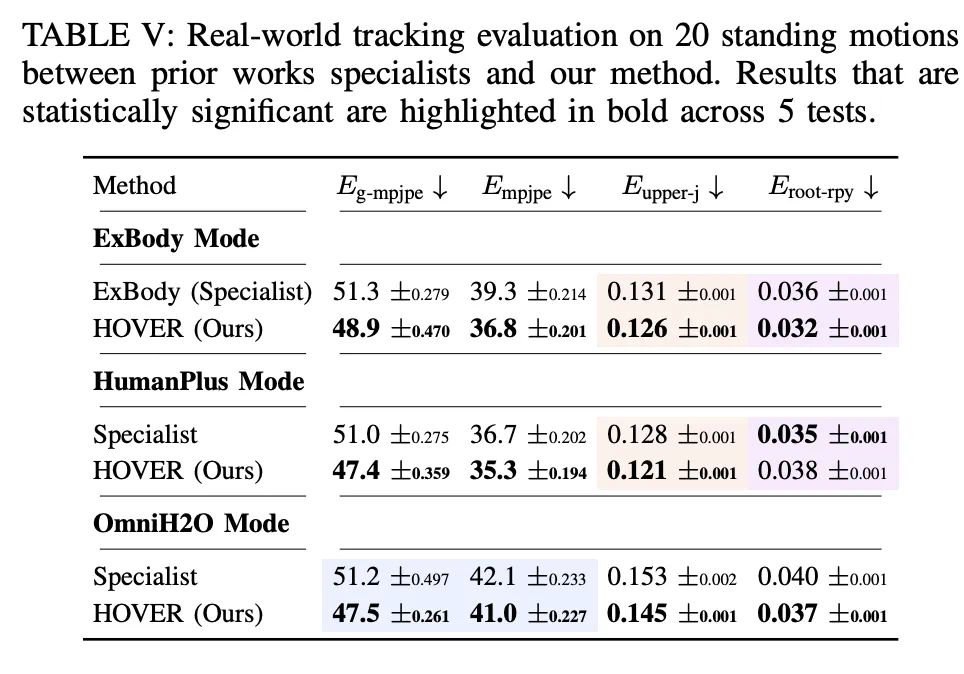

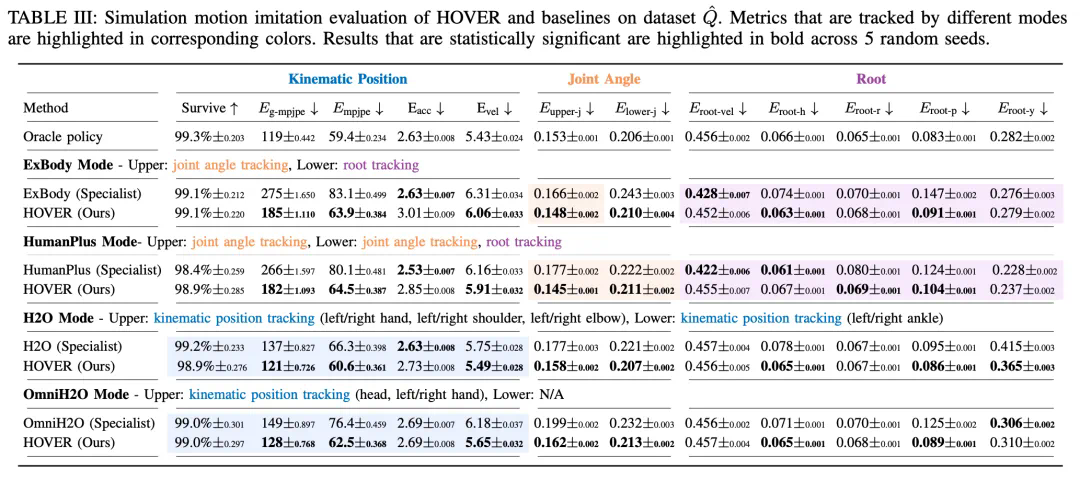

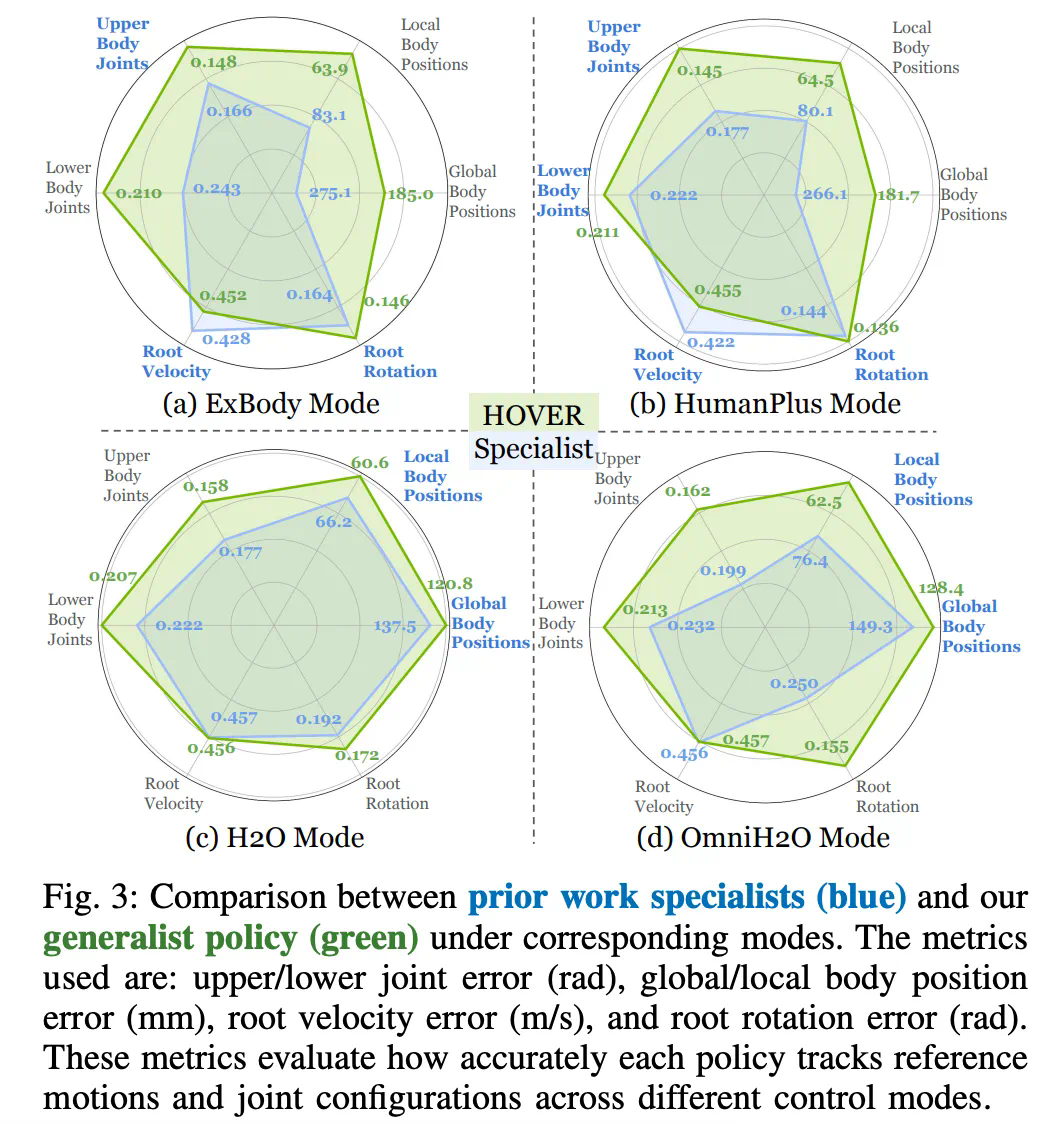

Q1: HOVER 这个通用策略能比那些只针对特定指令训练的策略表现得更好吗? -

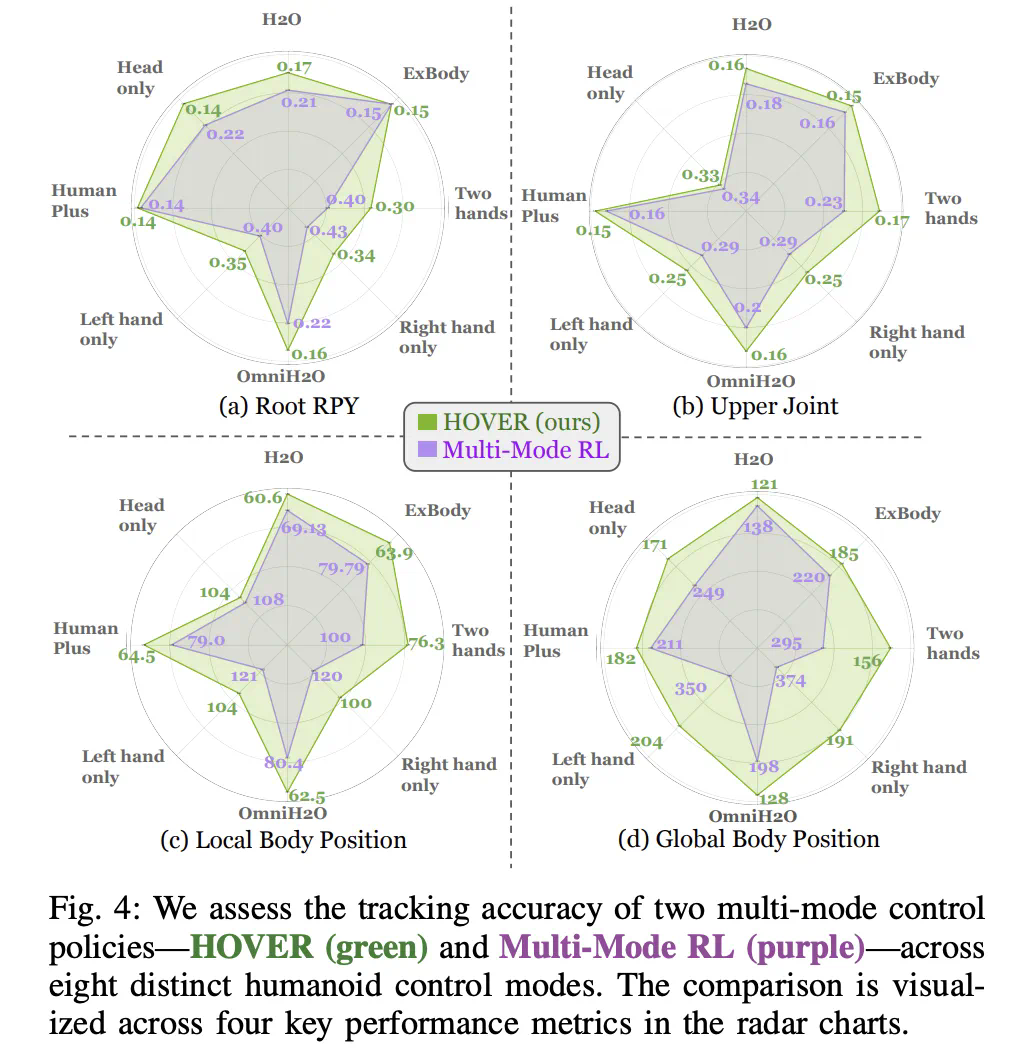

Q2: HOVER 能比其他训练方法更有效地训练多模态仿人机器人控制器吗? -

Q3: HOVER 能否在真实世界的硬件上实现多功能多模态控制?

-

站立时的动作评估

-

多模态评估

文章来源于互联网:让机器人拥有人一样「潜意识」,英伟达1.5M小模型就能实现通用控制了