文章来源于互联网:媲美OpenAI事实性基准,这个中文评测集让o1-preview刚刚及格

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

核心作者包括贺彦程,李世龙,刘佳恒,苏文博。作者团队来自淘天集团算法技术 – 未来生活实验室团队。为了建设面向未来的生活和消费方式,进一步提升用户体验和商家经营效果,淘天集团集中算力、数据和顶尖的技术人才,成立未来生活实验室。实验室聚焦大模型、多模态等 AI 技术方向,致力于打造大模型相关基础算法、模型能力和各类 AI Native 应用,引领 AI 在生活消费领域的技术创新。

如何解决模型生成幻觉一直是人工智能(AI)领域的一个悬而未解的问题。为了测量语言模型的事实正确性,近期 OpenAI 发布并开源了一个名为 SimpleQA 的评测集。而我们也同样一直在关注模型事实正确性这一领域,目前该领域存在数据过时、评测不准和覆盖不全等问题。例如现在大家广泛使用的知识评测集还是 CommonSenseQA、CMMLU 和 C-Eval 等选择题形式的评测集。

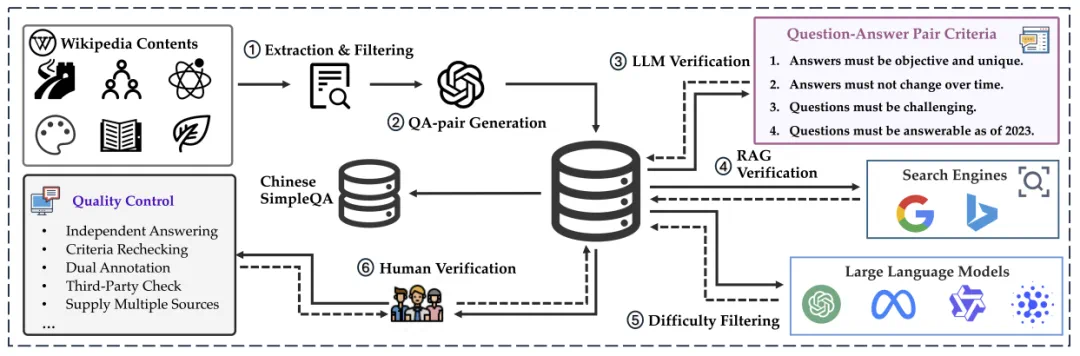

为了进一步同步推进中文社区对模型事实正确性的研究,淘天集团算法技术 – 未来生活实验室团队提出了 Chinese SimpleQA,这是第一个系统性地全面评估模型回答简短事实性问题能力的中文评测集,可以全面探测模型在各个领域的知识水平。具体来说,Chinese SimpleQA 主要有六个特点:

-

中文:专注于中文语言,并特地包含中国文化等特色知识相关的问题 -

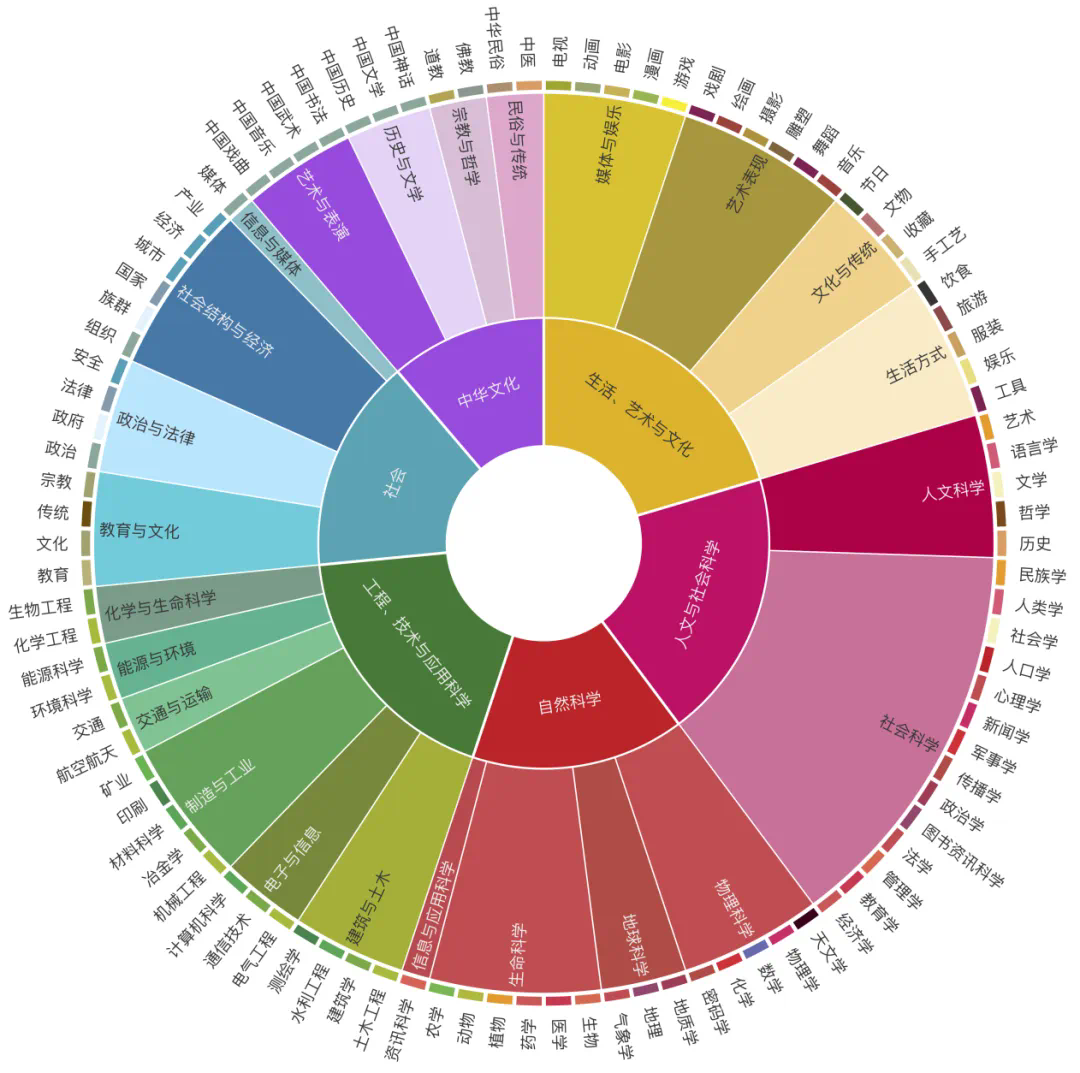

全面性:涵盖 6 个大类主题(中华文化、人文与社会科学、自然科学、生活艺术与文化、工程技术与应用科学、社会)和 99 个子类主题 -

高质量:我们进行了全面且严格的质量控制,有包括 52 位外包和 6 位算法工程师的参与 -

静态:参考答案都是在时间上保持不变的,保证了评测集的长期有效性,可以长期作为模型知识能力的评估基准 -

易于评估:评测数据的问题和答案非常简短,评测可以基于任意的模型,能够以较低成本和较快速度进行高一致性的评测。 -

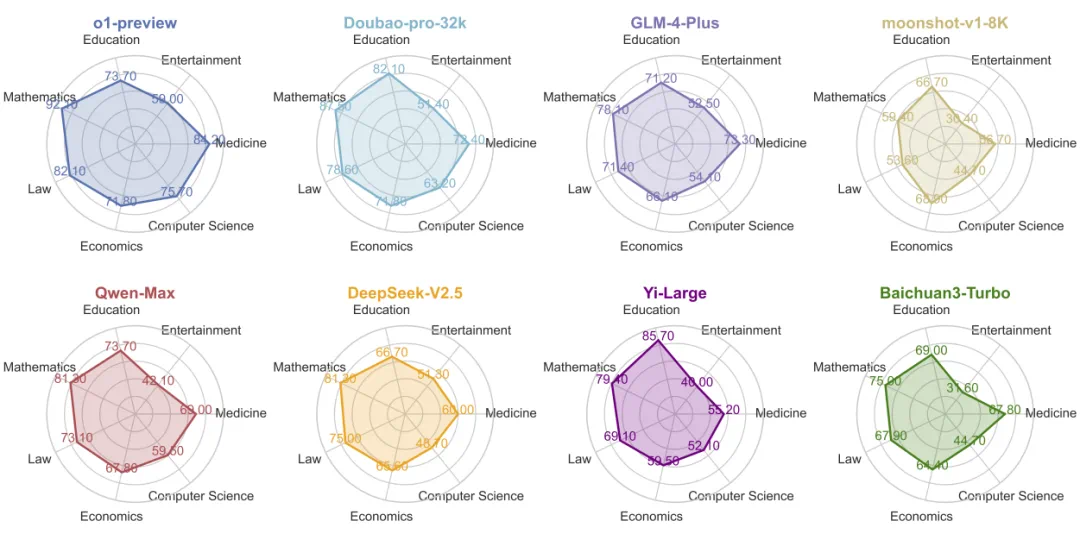

有难度和区分度:我们评估了 40 + 国内外开源和闭源大模型。目前在评测集上 o1-preview 都仅刚过及格线 (正确率 63.8), 其他大部分模型都处于低分状态,其中 GPT-4o mini 仅 37.6 分,ChatGLM3-6B 和 Qwen2.5-1.5B 仅 11.2 和 11.1 的准确率。

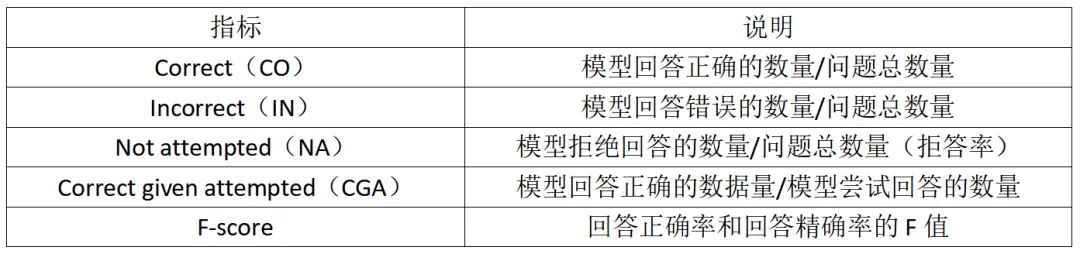

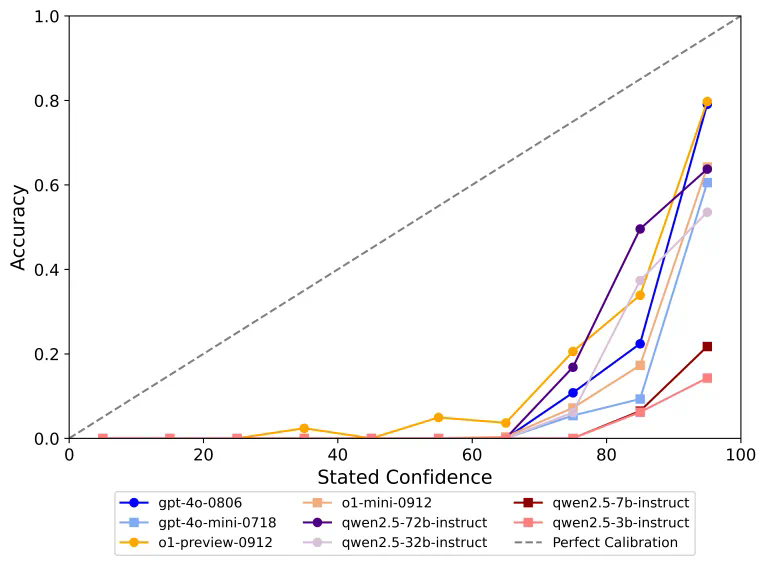

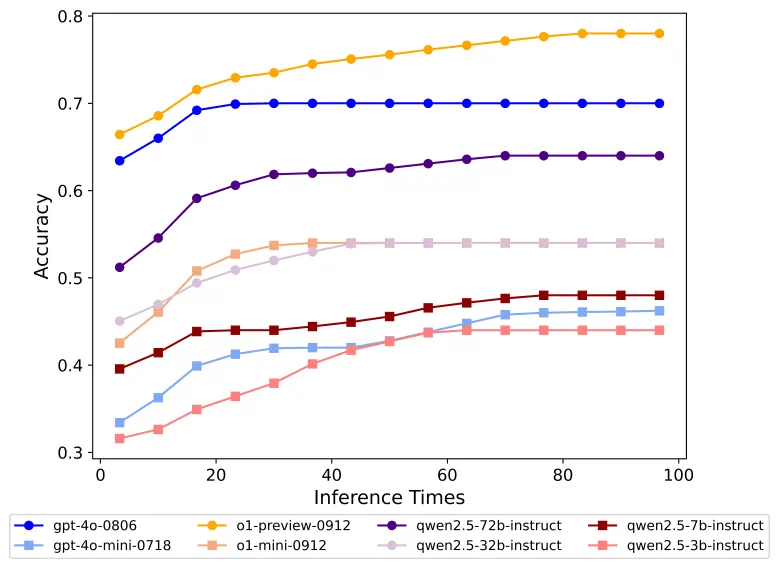

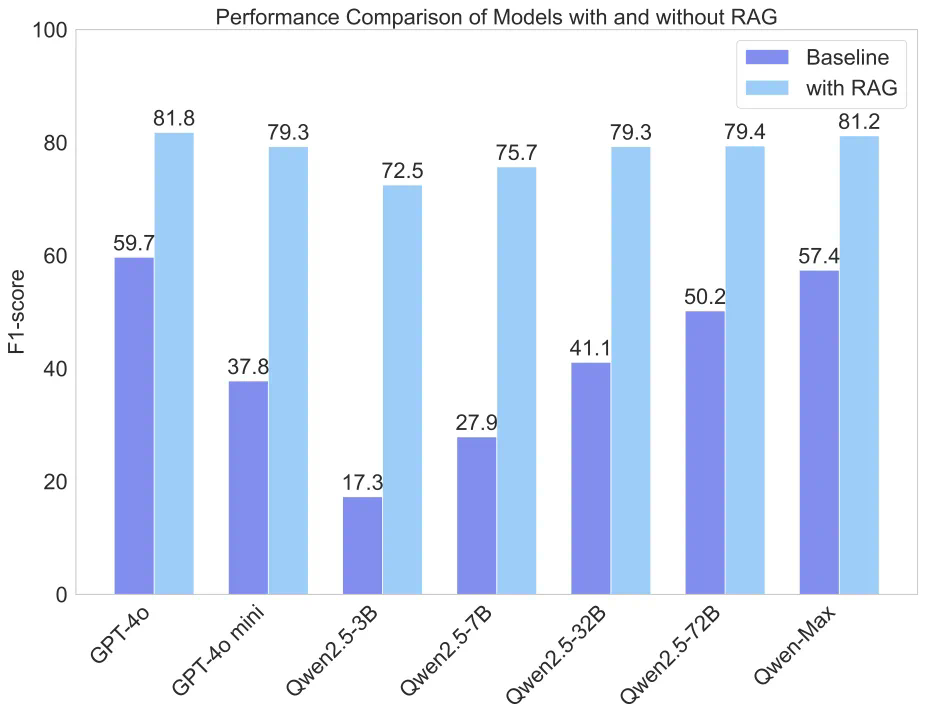

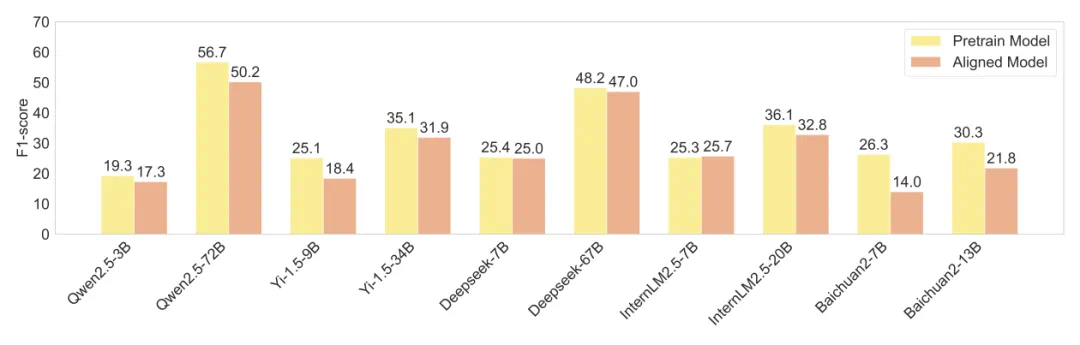

基于中文 SimpleQA,我们对现有 LLM 的事实性能力进行了全面的评估。并维护一个全面的 leaderboard 榜单。同时我们也在评测集上实验分析了推理 scaling law、模型校准、RAG、对齐税等研究问题,后续本评测集都可以作为这些方向的重要参考之一。

总之,我们希望 Chinese SimpleQA 能帮助开发者深入了解其模型在中文领域的事实正确性,同时也能为他们的算法研究提供重要基石,共同促进中文基础模型的成长。

-

论文链接:https://arxiv.org/abs/2411.07140 -

项目主页:https://openstellarteam.github.io/ChineseSimpleQA -

数据集下载:https://huggingface.co/datasets/OpenStellarTeam/Chinese-SimpleQA -

代码仓库:https://github.com/OpenStellarTeam/ChineseSimpleQA

文章来源于互联网:媲美OpenAI事实性基准,这个中文评测集让o1-preview刚刚及格