文章来源于互联网:撞墙还是新起点?自回归模型在图像领域展现出Scaling潜力

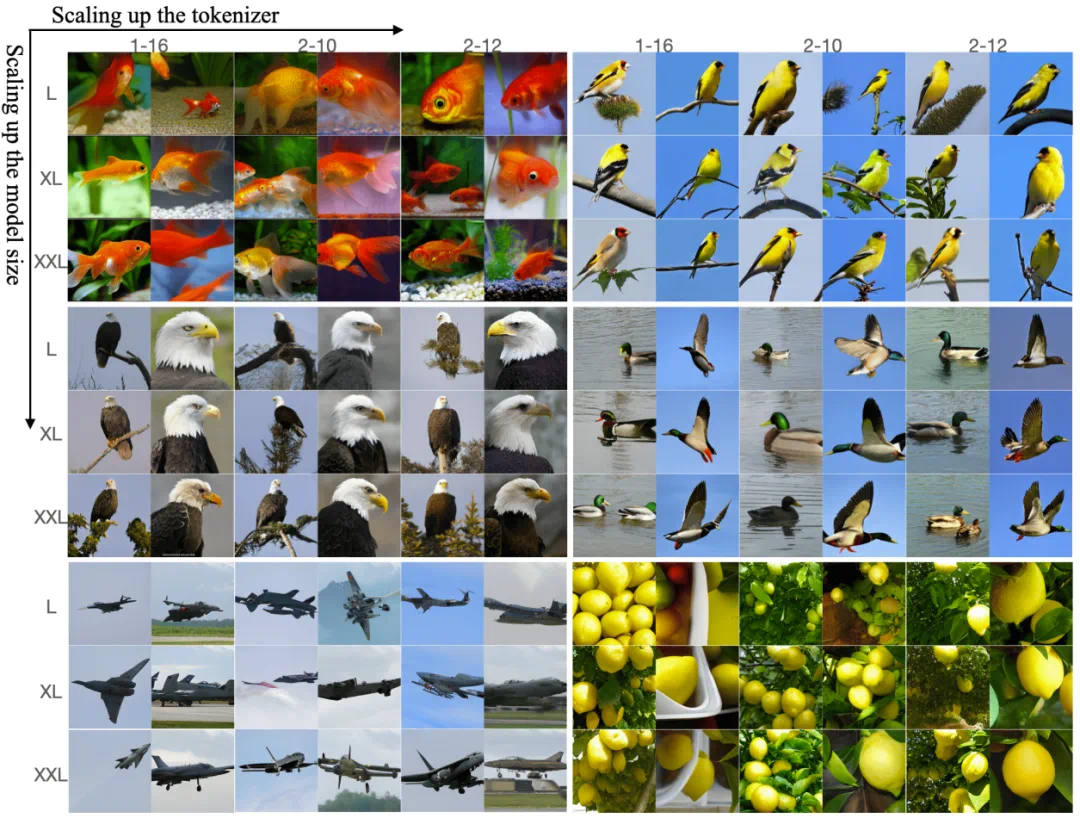

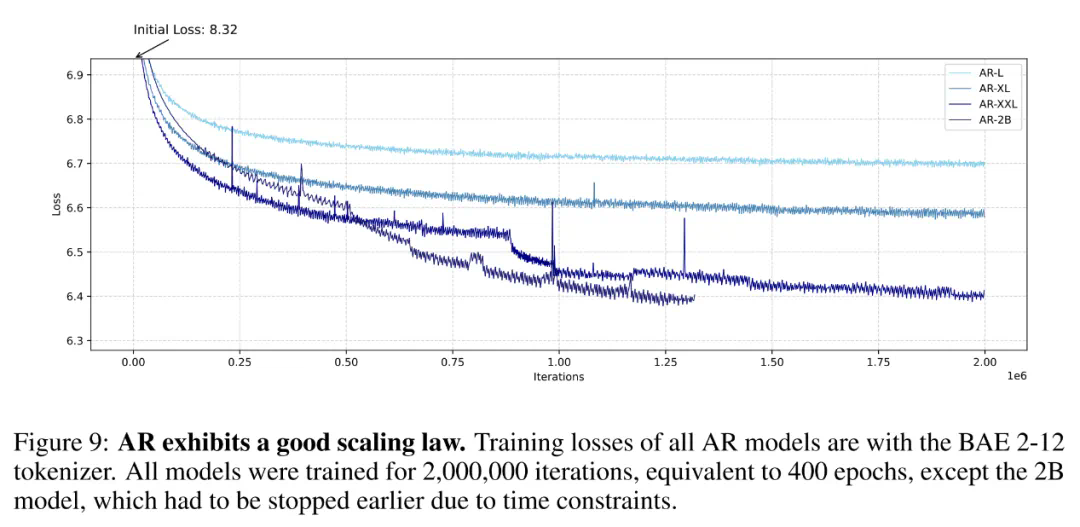

自回归方法,在图像生成中观察到了 Scaling Law。

「Scaling Law 撞墙了?」这恐怕是 AI 社区最近讨论热度最高的话题。

该话题始于 The Information 的一篇文章。这篇文章透露,OpenAI 下一代旗舰模型的质量提升幅度不及前两款旗舰模型之间的质量提升,因为高质量文本和其他数据的供应量正在减少,原本的 Scaling Law(用更多的数据训练更大的模型)可能无以为继。

文章发布后,很多人反驳了这一观点,认为 Scaling Law 还没到撞墙的地步,毕竟很多训练大模型的团队依然能够看到模型能力的持续提升。而且,我们现在所说的 Scaling Law 更多是指训练阶段,而推理阶段的 Scaling Law 还未被充分挖掘,借助测试时间计算等方法,大模型的能力还能更上一层楼。

-

论文标题:Elucidating the design space of language models for image generation -

论文链接:https://arxiv.org/pdf/2410.16257 -

代码与模型:https://github.com/Pepper-lll/LMforImageGeneration

-

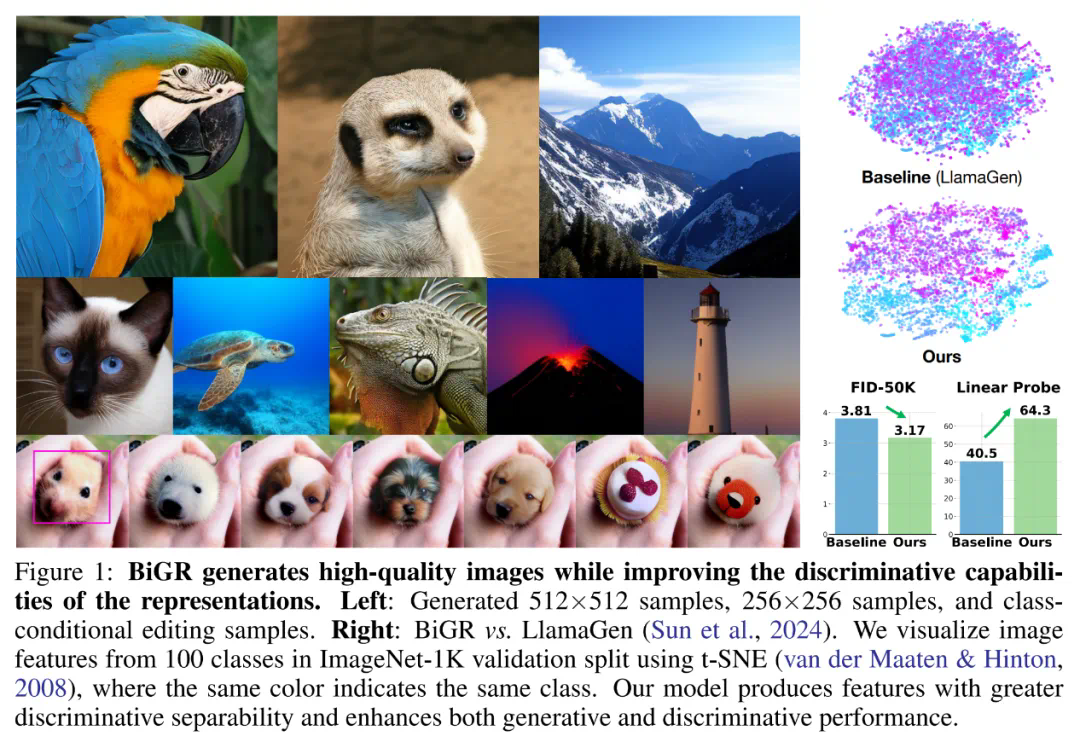

论文标题:BiGR: Harnessing Binary Latent Codes for Image Generation and Improved Visual Representation Capabilities -

论文链接:https://arxiv.org/pdf/2410.14672 -

代码与模型:https://github.com/haoosz/BiGR

-

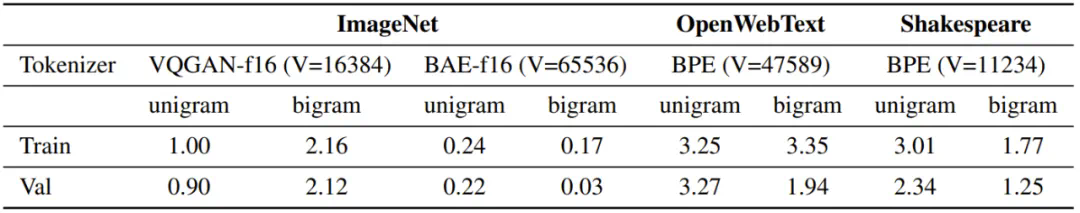

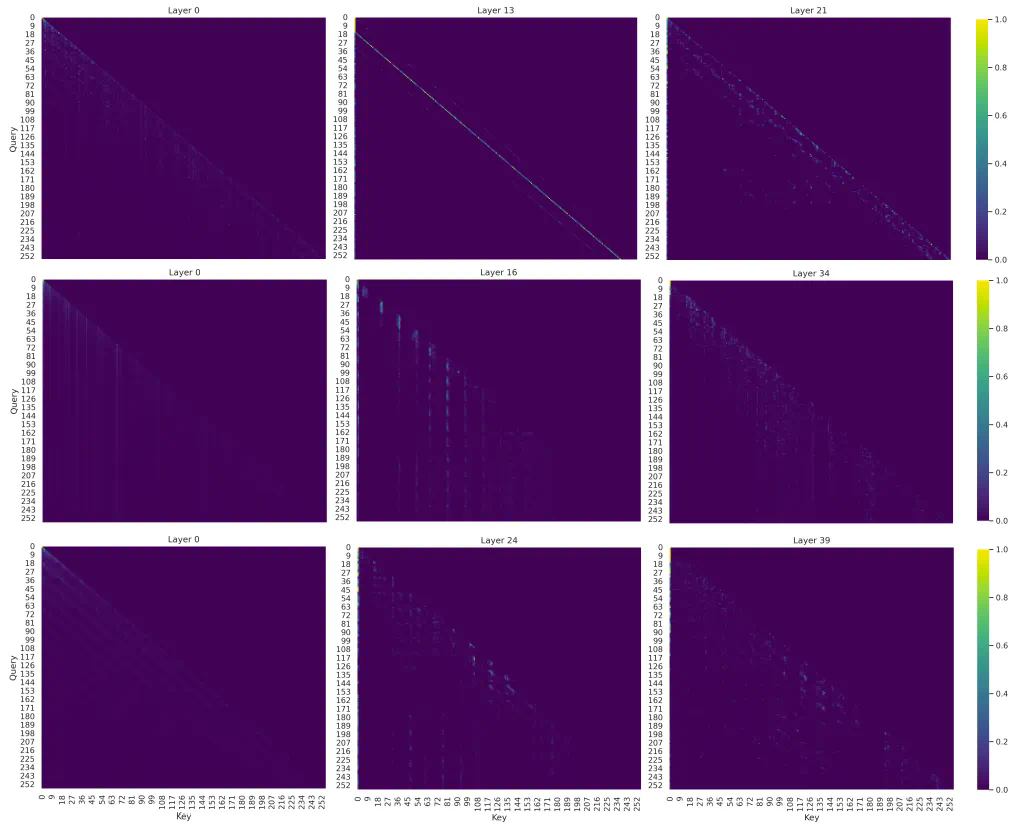

图像数据缺乏语言数据常有的那种内在结构和序列顺序。这种图像 token 分布的随机性表明图像生成并不依赖严格的序列模式。 -

接近均匀的 token 分布表明生成任务对错误的容忍度更高。由于所有 token 的概率几乎相等,因此该模型可以容忍不太精确的 token 预测,同时还不会显著影响输出的质量。

-

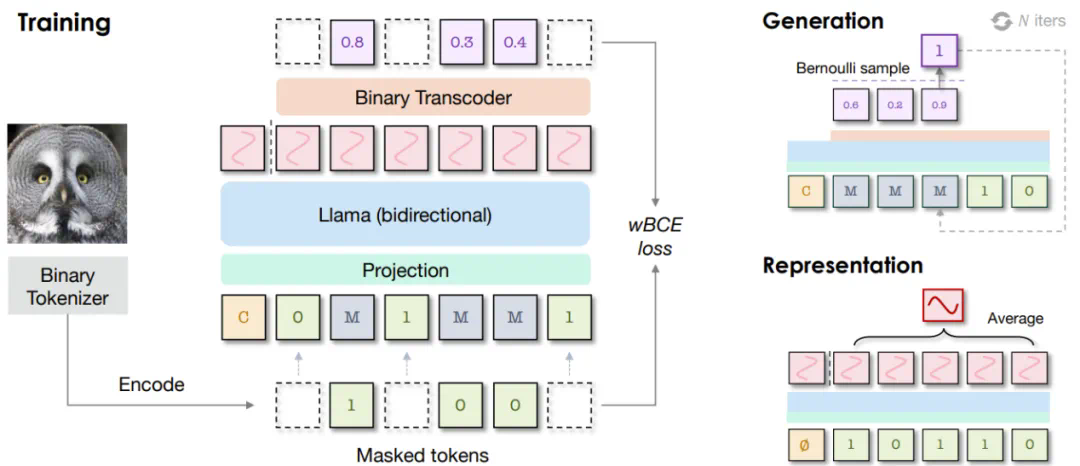

一个二元 token 化器,其作用是将像素图像转换成二元隐码构成的序列; -

一个仅解码器 Transformer,并配备了完整的双向注意力; -

一个二元转码器(binary transcoder),作用是将连续特征转换成伯努利分布的二元编码。

-

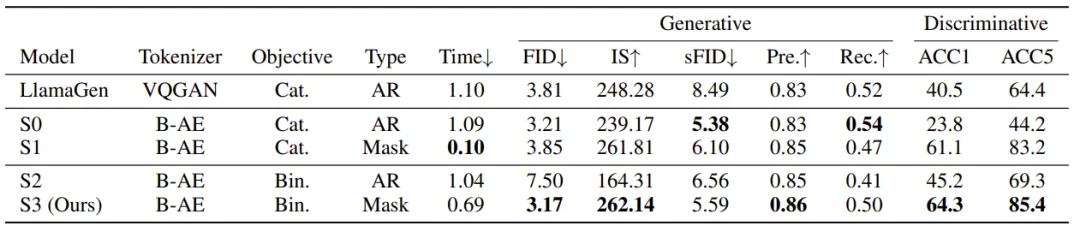

通过比较 LlamaGen 和 S0,可知相比于使用 VQGAN,使用二元自动编码器可以带来更好的生成性能,但判别性能会下降一些。 -

对于生成任务,AR 建模更适合分类损失,而掩码建模更适合二元损失。 -

对于判别任务,不管哪种损失,掩码建模都大幅优于 AR 建模,而二元损失能进一步提升性能。 -

与 AR 建模相比,掩码建模由于采样迭代次数较少,因此推理速度明显更快,而二元目标的扩散过程需要更多时间。

的谱能量集中。另外一项则是设计了高效且稳定的 Transformer 模块。

的谱能量集中。另外一项则是设计了高效且稳定的 Transformer 模块。文章来源于互联网:撞墙还是新起点?自回归模型在图像领域展现出Scaling潜力