文章来源于互联网:12%计算量就能媲美原模型,Adobe、罗切斯特大学等提出YOPO剪枝技术

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文:Treat Visual Tokens as Text? But Your MLLM Only Needs Fewer Efforts to See -

论文链接:https://arxiv.org/abs/2410.06169 -

开源代码 & 模型:https://github.com/ZhangAIPI/YOPO_MLLM_Pruning/tree/main?tab=readme-ov-file

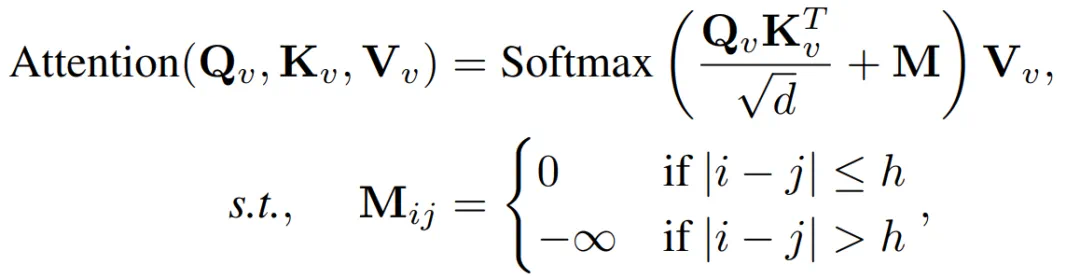

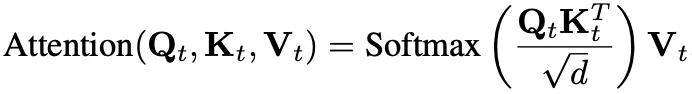

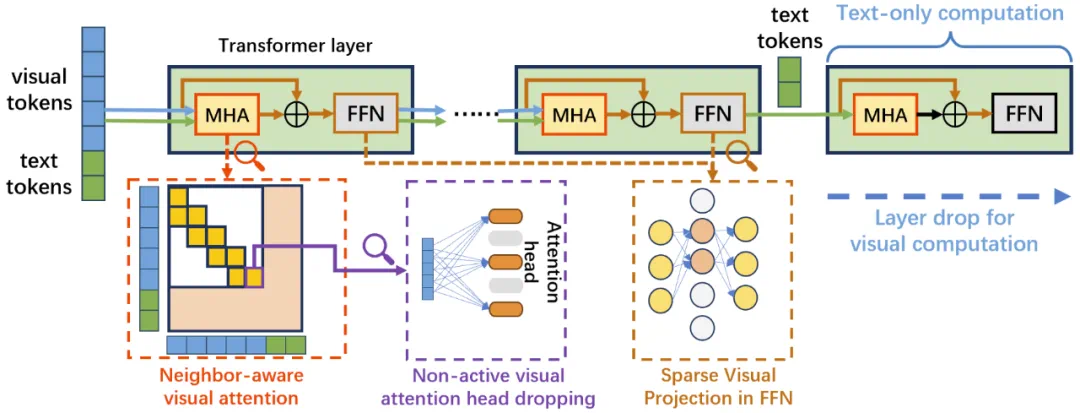

的注意力计算中,大多数注意力是稀疏的,且显著的注意力权重主要集中在相邻的视觉 tokens 上。为减少由这种冗余引起的计算负担,研究团队提出了一种简单而有效的剪枝方法,选择性地消除视觉 token 之间的非必要注意力计算。具体而言,研究团队对注意力机制进行了修改,使得只有相邻的视觉 token 彼此关注,而文本 token 则保留了在视觉 token 和文本 token 之间自由关注的能力。修改后的视觉注意力计算过程如下:

的注意力计算中,大多数注意力是稀疏的,且显著的注意力权重主要集中在相邻的视觉 tokens 上。为减少由这种冗余引起的计算负担,研究团队提出了一种简单而有效的剪枝方法,选择性地消除视觉 token 之间的非必要注意力计算。具体而言,研究团队对注意力机制进行了修改,使得只有相邻的视觉 token 彼此关注,而文本 token 则保留了在视觉 token 和文本 token 之间自由关注的能力。修改后的视觉注意力计算过程如下: