内容目录

文章来源于互联网:NeurIPS Spotlight|从分类到生成:无训练的可控扩散生成

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

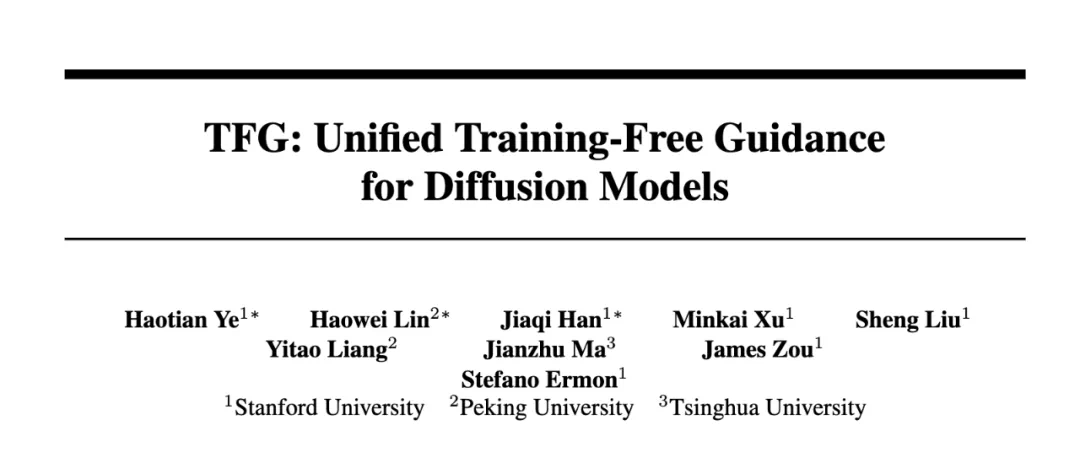

论文标题:TFG: Unified Training-Free Guidance for Diffusion Models -

论文链接:https://arxiv.org/abs/2409.15761 -

项目地址:https://github.com/YWolfeee/Training-Free-Guidance

-

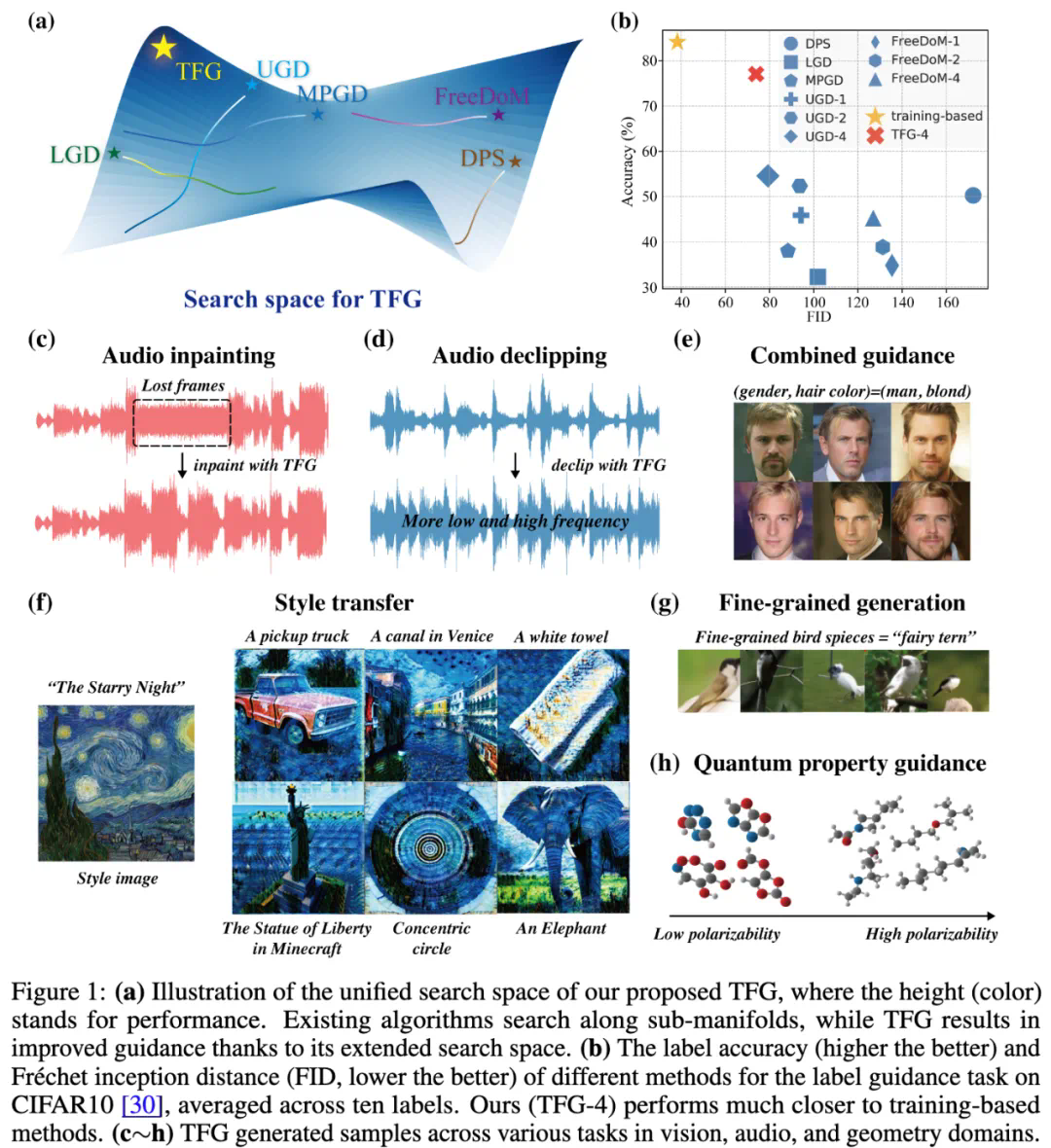

缺乏系统性理论支持和设计指导; -

即使在简单任务中表现也不稳定,容易失败; -

难以高效选择适合的超参数。

,权重随时间步逐渐增加。

,权重随时间步逐渐增加。 ,权重随时间步逐渐减小。

,权重随时间步逐渐减小。-

在每次迭代中,分别对进行倍增(如从 0.25 增加到 0.5),生成多个新配置。 -

使用小规模的生成样本测试新配置,评估其表现(例如 FID 和准确率)。

-

数据分布超出训练模型的常见分布范围,导致生成的样本极易偏离目标特性。 -

即使对于成熟的文本 – 图像生成模型(如 DALL-E),该问题也难以解决。

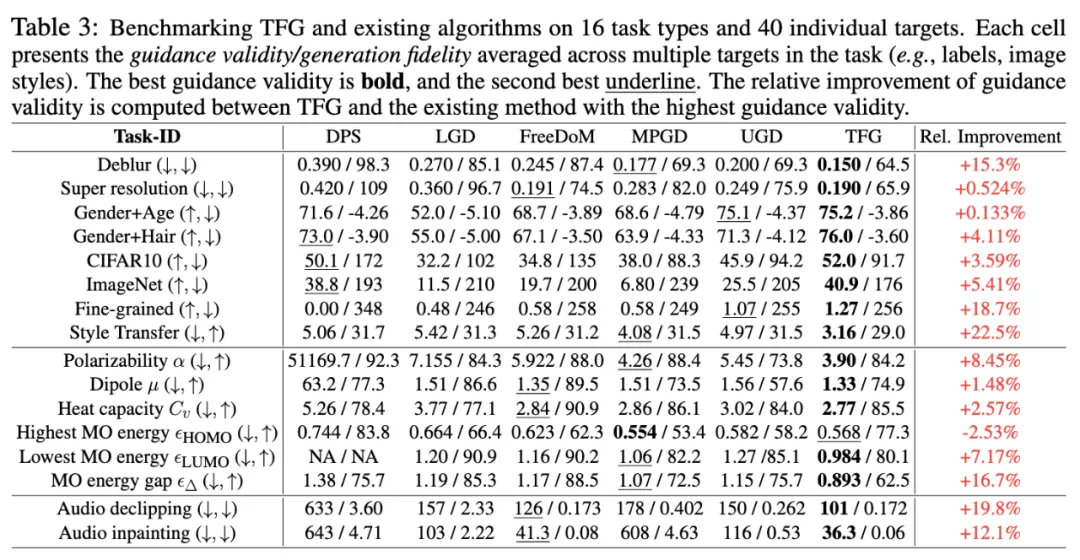

TFG 不仅为无训练指导提供了统一理论基础和实用工具,也为扩散模型在不同领域的拓展应用提供了新的思路。其核心优势包括:

-

高效适应性:无需为每个任务额外训练模型,显著降低了条件生成的门槛; -

广泛兼容性:框架适用于从图像到音频、从分子到多目标生成的多种任务; -

性能优越性:通过理论与实验的结合,显著提升了生成的准确性和质量。

未来,TFG 有望在药物设计、精准医学、复杂音频生成、高级图像编辑等领域进一步发挥作用。研究团队还计划优化框架,进一步缩小与基于训练方法的性能差距。

文章来源于互联网:NeurIPS Spotlight|从分类到生成:无训练的可控扩散生成