文章来源于互联网:3D具身基础模型!北大提出Lift3D赋予2D大模型鲁棒的3D操纵能力

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文链接: https://arxiv.org/pdf/2411.18623

-

论文标题:Lift3D Foundation Policy: Lifting 2D Large-Scale Pretrained Models for Robust 3D Robotic Manipulation

-

项目主页: https://lift3d-web.github.io/

-

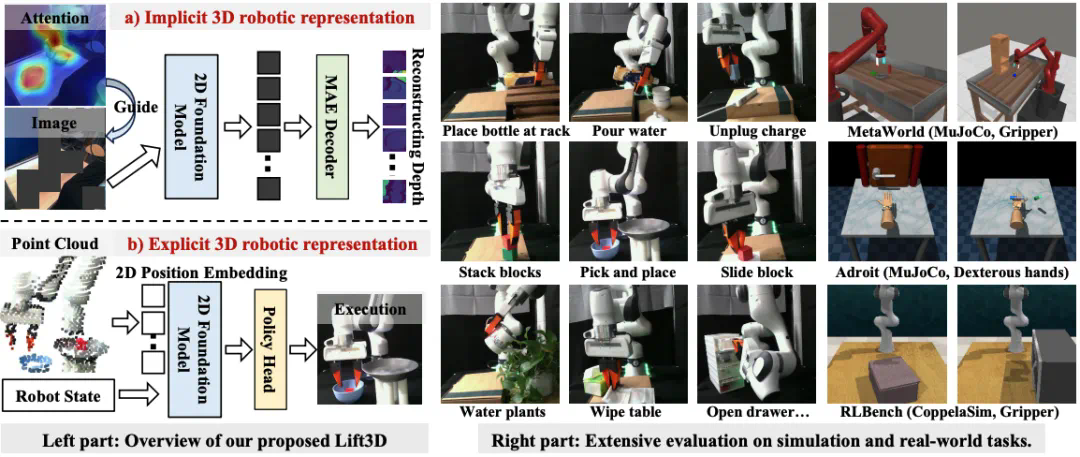

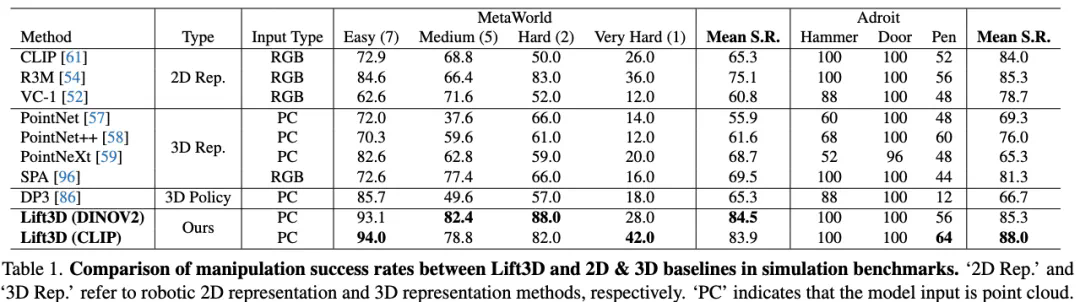

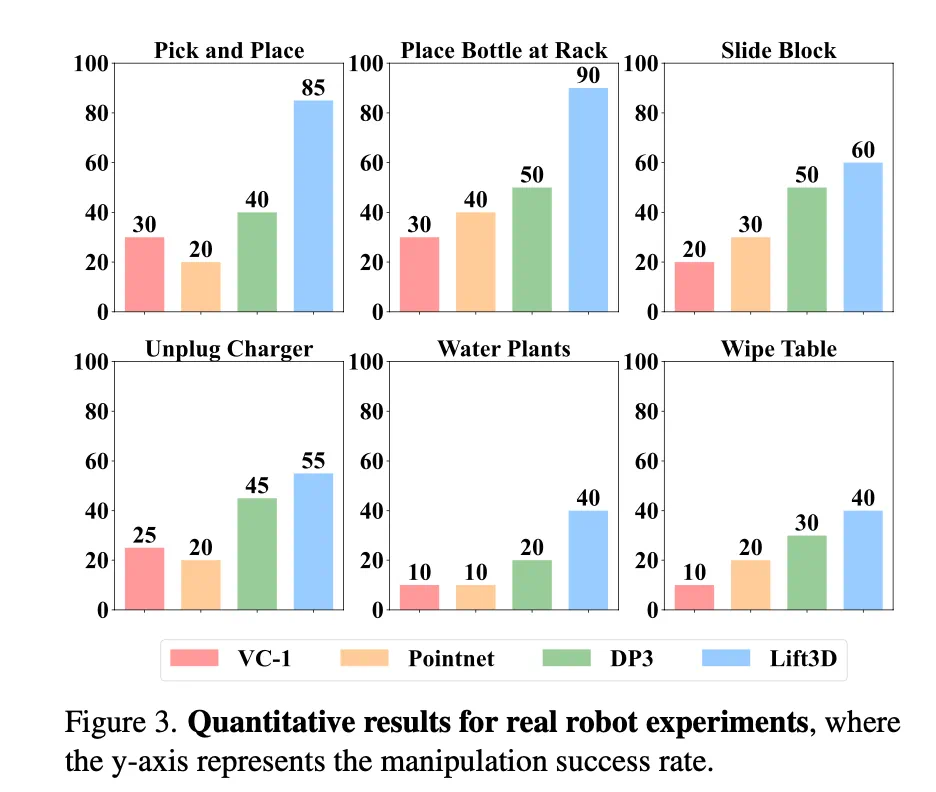

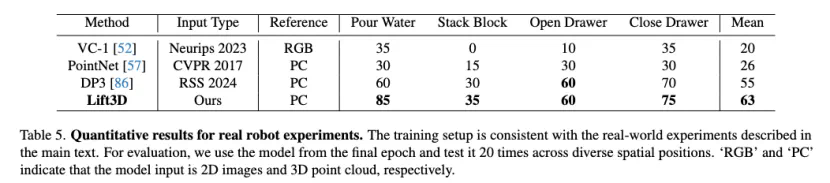

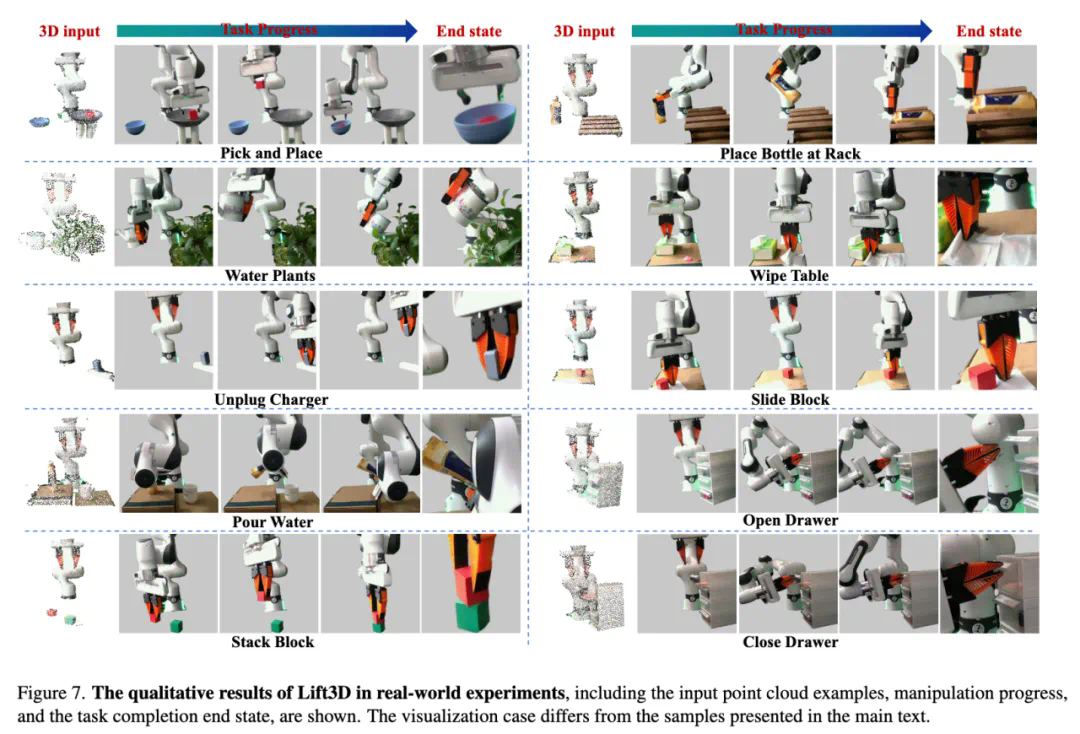

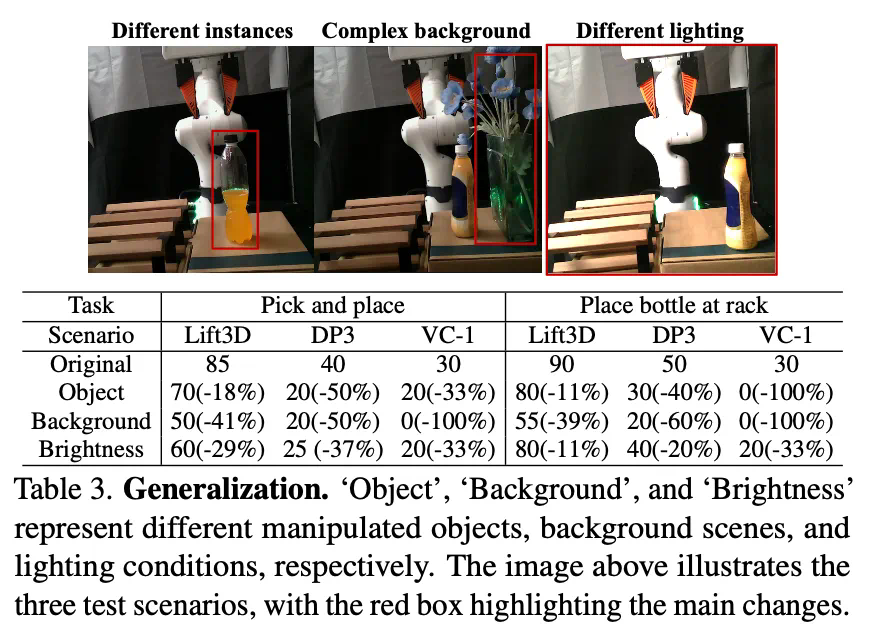

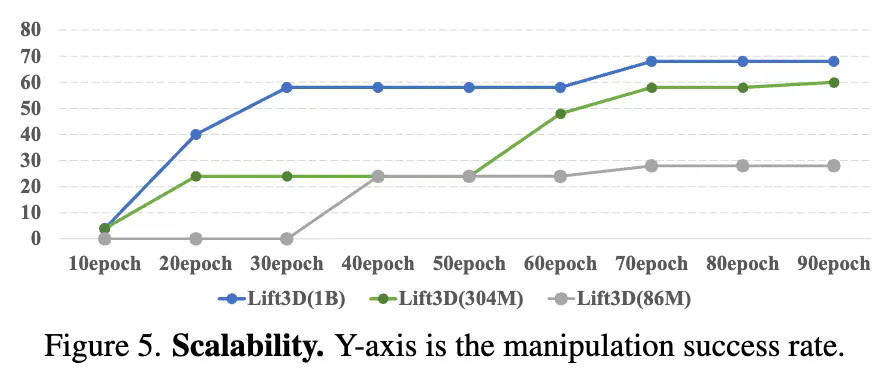

我们提出了 Lift3D,通过系统地改进隐式和显式的 3D 机器人表示,将 2D 大规模预训练模型提升为鲁棒的 3D 操纵策略模型。

-

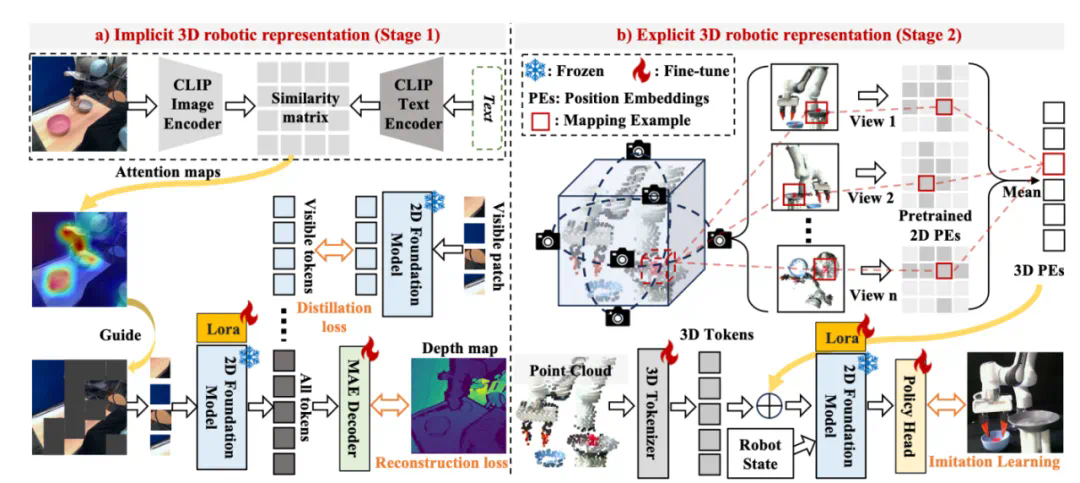

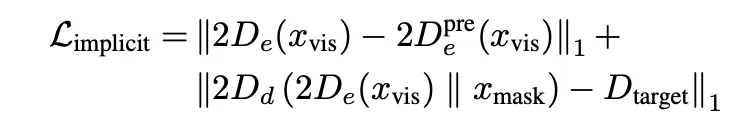

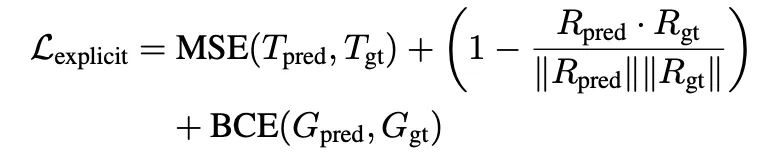

对于隐式 3D 机器人表示,我们设计了一种任务感知 MAE(Mask Autoencoder)自监督方法,它对任务相关的可操作区域进行掩蔽,并重建深度几何信息,从而增强 2D 基础模型的 3D 空间认知。

-

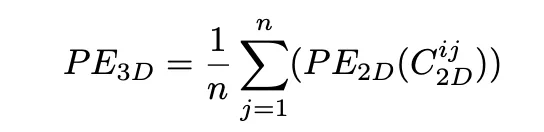

对于显式 3D 机器人表示,我们提出了一种 2D 基础模型 lifting 策略,利用 2D 基础模型的预训练位置编码(PE)来编码 3D 点云数据,用于 3D 操纵模仿学习。

文章来源于互联网:3D具身基础模型!北大提出Lift3D赋予2D大模型鲁棒的3D操纵能力