文章来源于互联网:MiniMax震撼开源,突破传统Transformer架构,4560亿参数,支持400万长上下文

「2025 年,我们可能会看到第一批 AI Agent 加入劳动力大军,并对公司的生产力产生实质性的影响。」——OpenAI CEO Sam Altman

「2025 年,每个公司都将拥有 AI 软件工程师 Agent,它们会编写大量代码。」——Meta CEO Mark Zuckerberg

「未来,每家公司的 IT 部门都将成为 AI Agent 的 HR 部门。」—— 英伟达 CEO 黄仁勋

2025 新年伊始,在很多趋势都还不明朗的情况下,几位 AI 业界的重要人物几乎在同一时间做出了类似的判断 ——2025 年将是 AI Agent 之年。

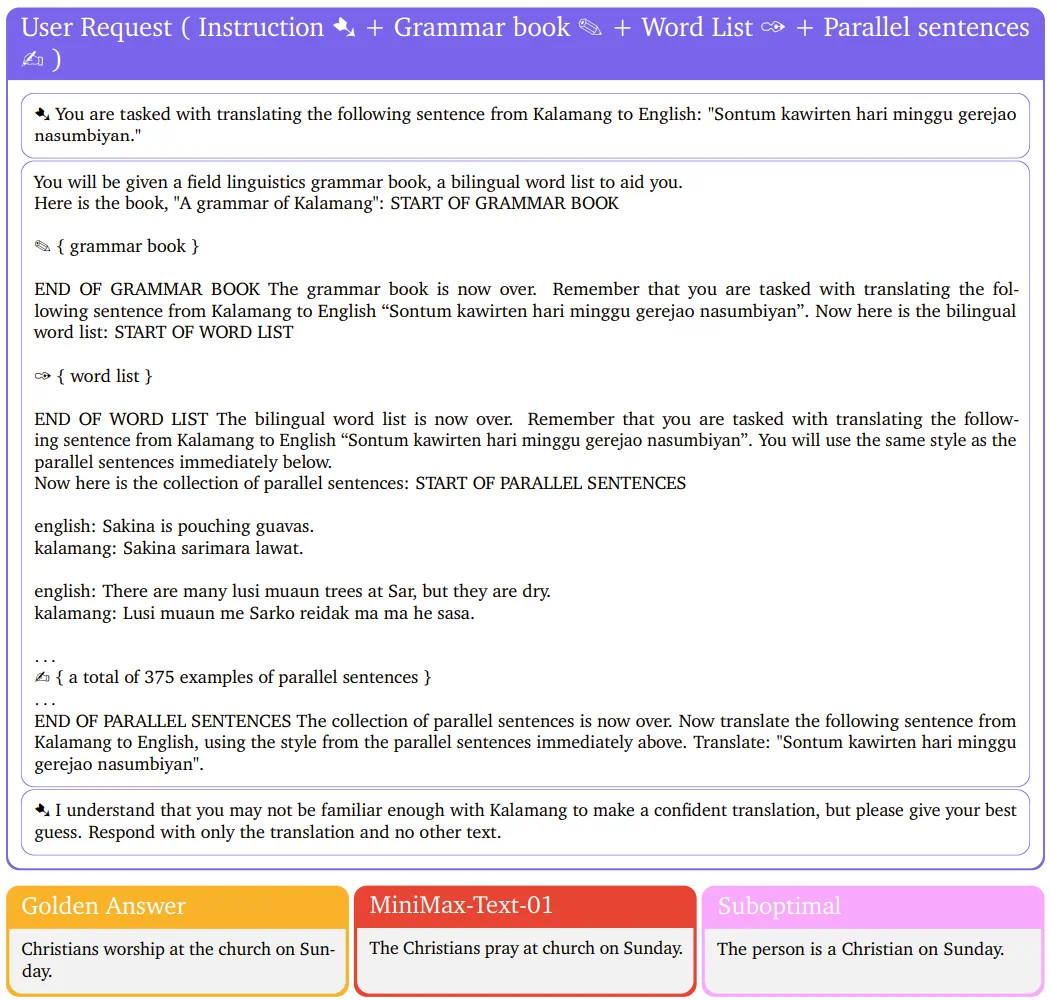

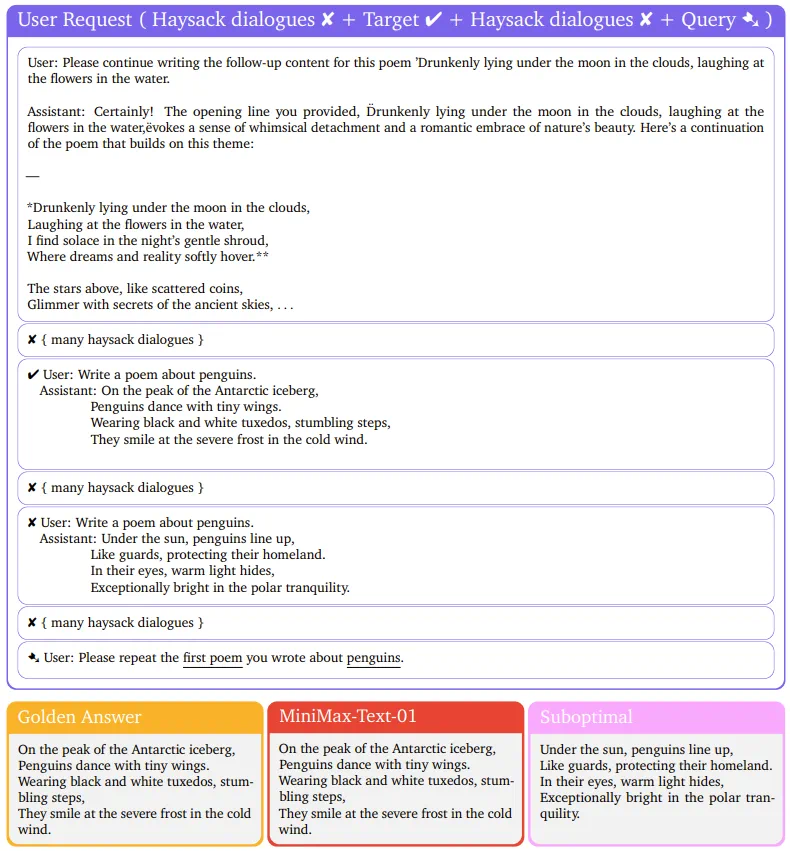

没想到,MiniMax 很快就有了动作:开源了最新的基础语言模型 MiniMax-Text-01 和视觉多模态模型 MiniMax-VL-01。

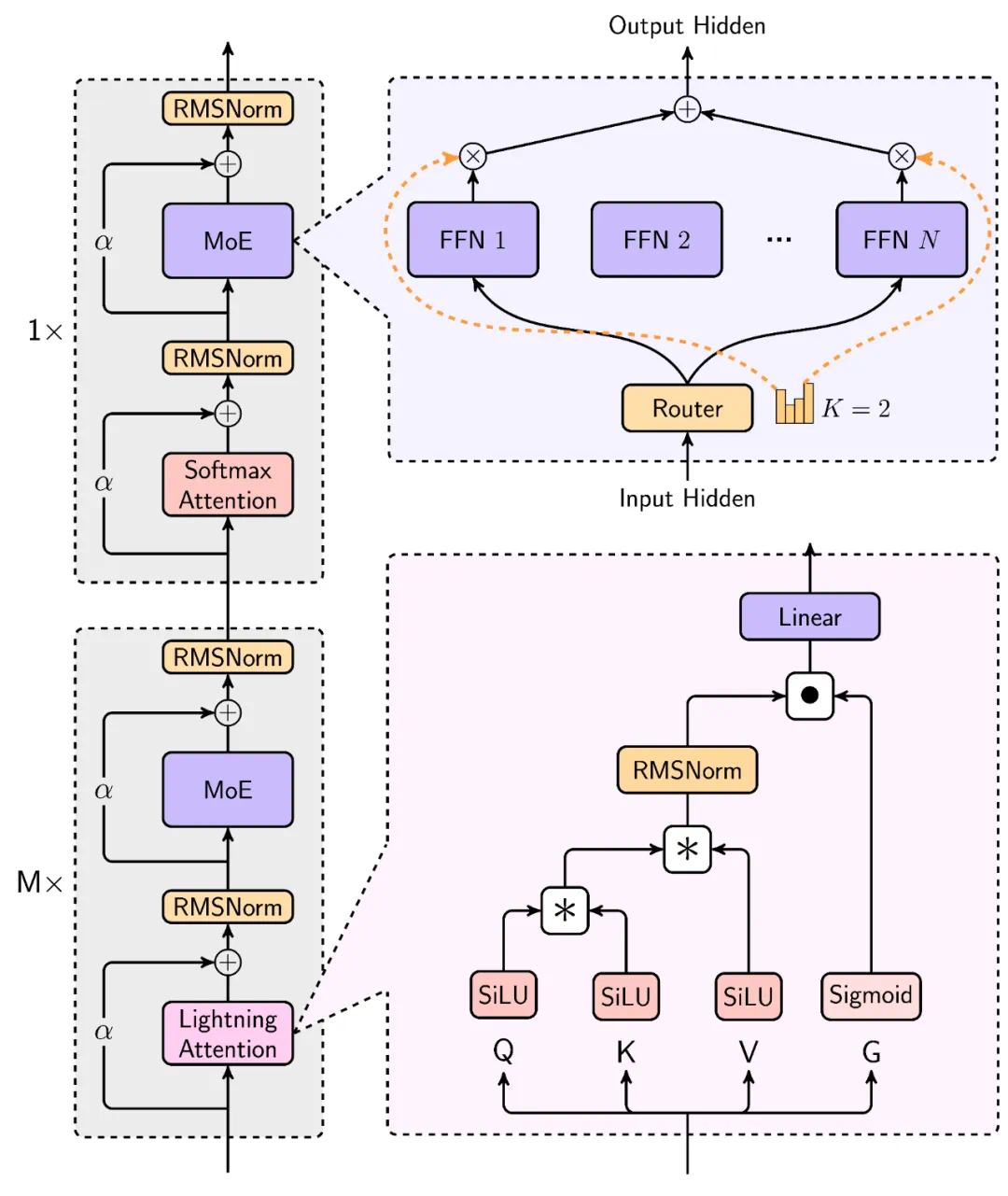

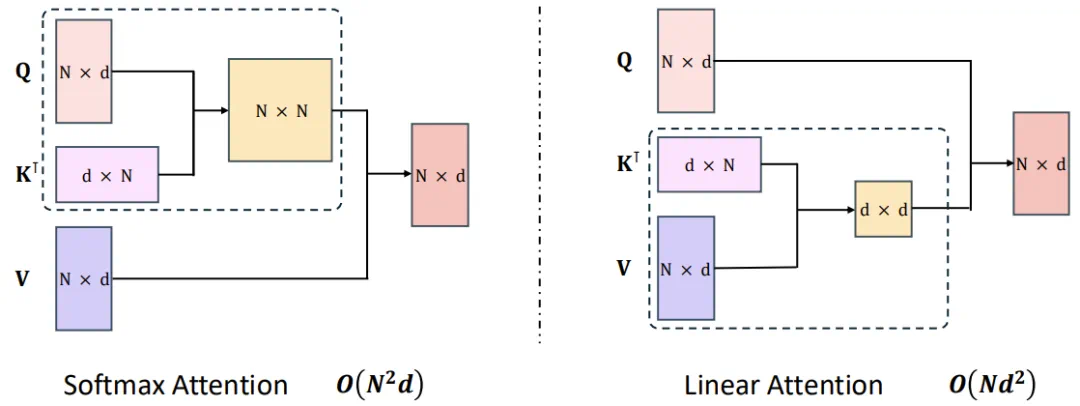

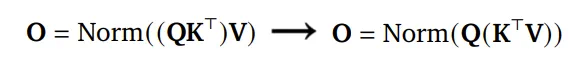

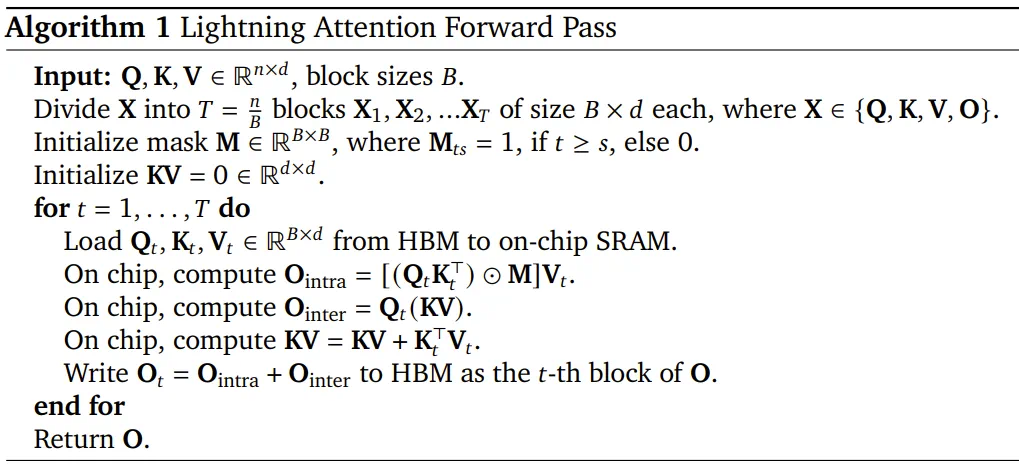

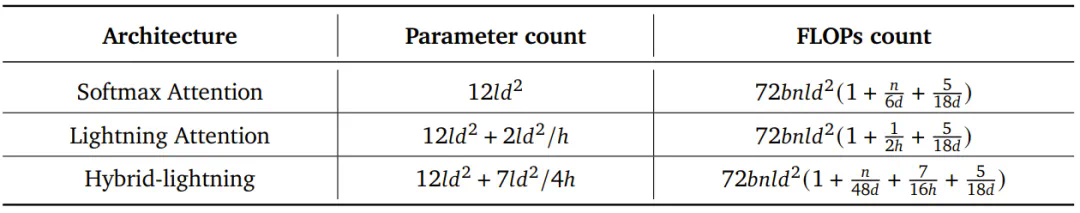

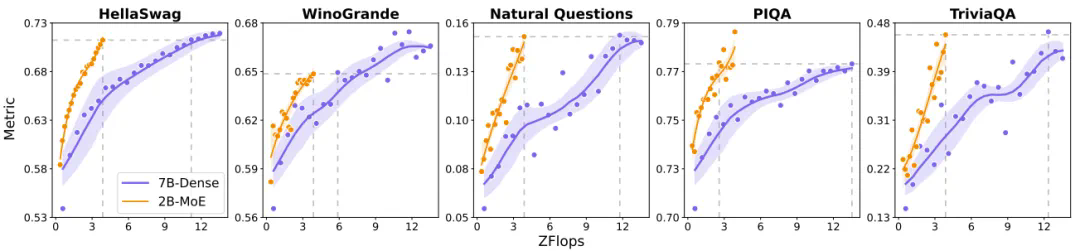

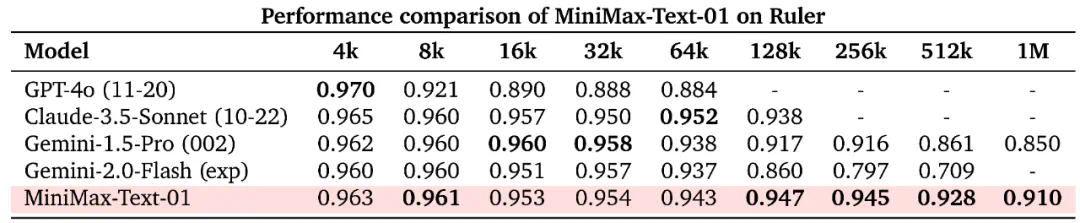

新模型的最大亮点是,在业内首次大规模实现了新的线性注意力机制,这使得输入的上下文窗口大大变长:一次可处理 400 万 token,是其他模型的 20-32 倍。

他们相信,这些模型能够给接下来一年潜在 Agent 相关应用的爆发做出贡献。

为什么这项工作对于 Agent 如此重要?

随着 Agent 进入应用场景,无论是单个 Agent 工作时产生的记忆,还是多个 Agent 协作所产生的 context,都会对模型的长上下文窗口提出更多需求。

-

开源地址:https://github.com/MiniMax-AI -

Hugging Face:https://huggingface.co/MiniMaxAI -

技术报告:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf -

网页端:https://www.hailuo.ai -

API:https://www.minimaxi.com/platform

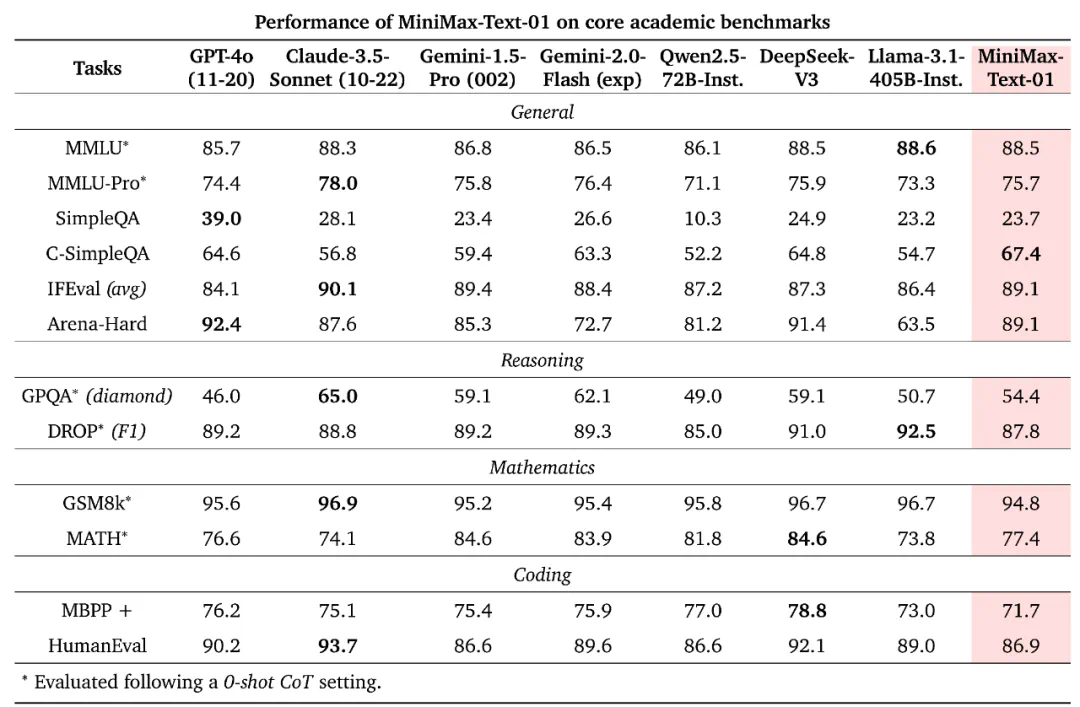

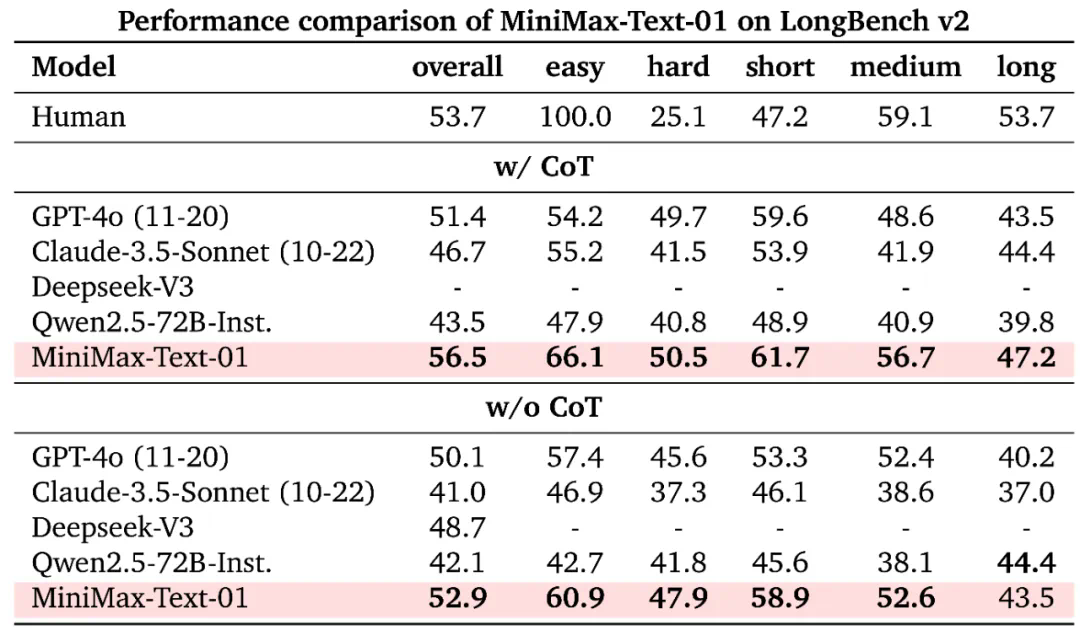

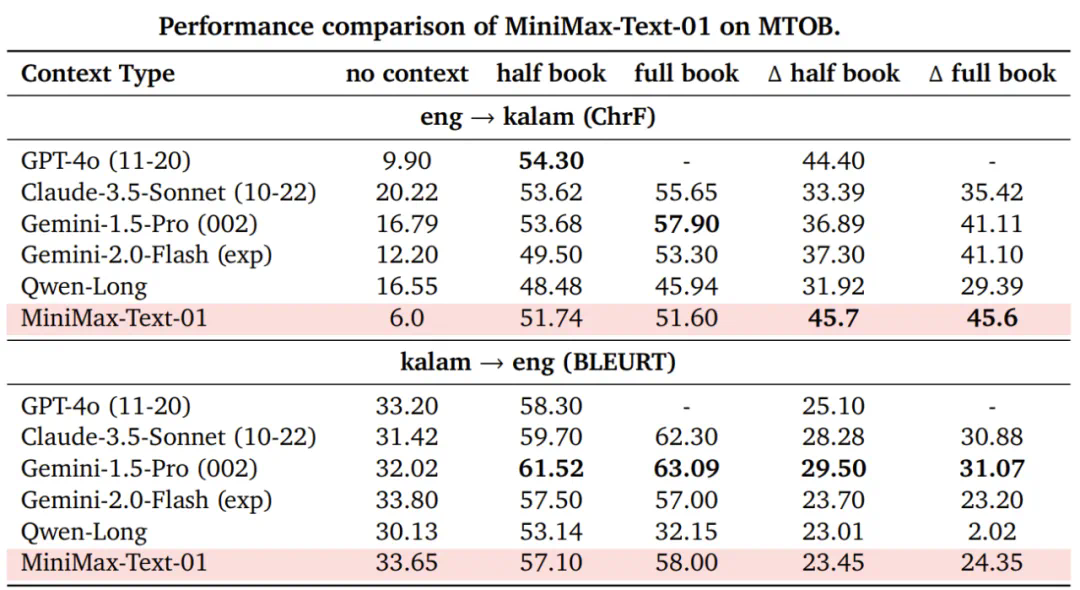

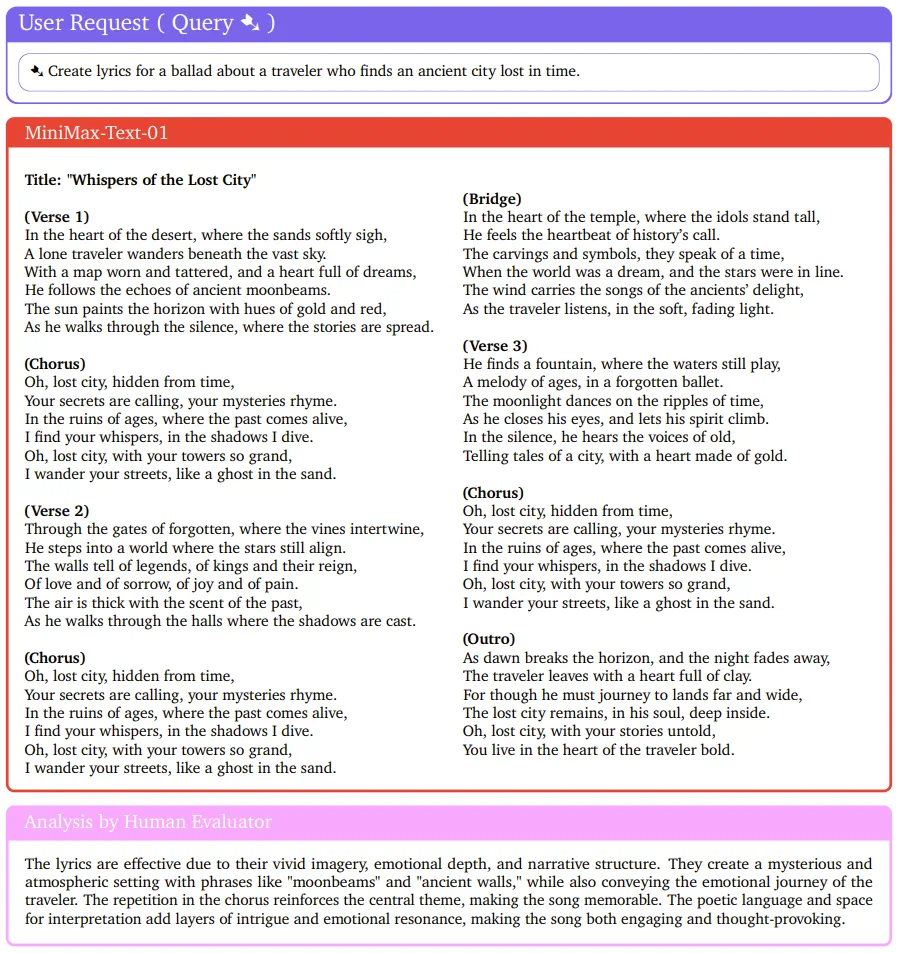

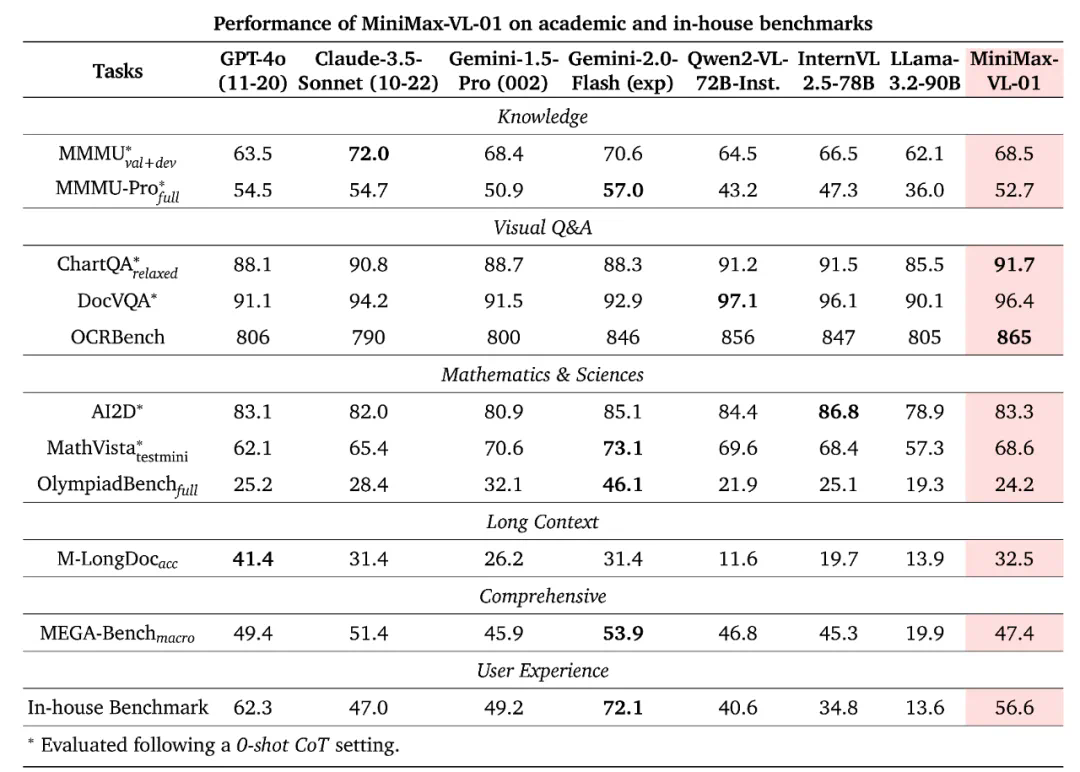

造就比肩顶尖模型的开源模型

上下文巨长,能力也够强

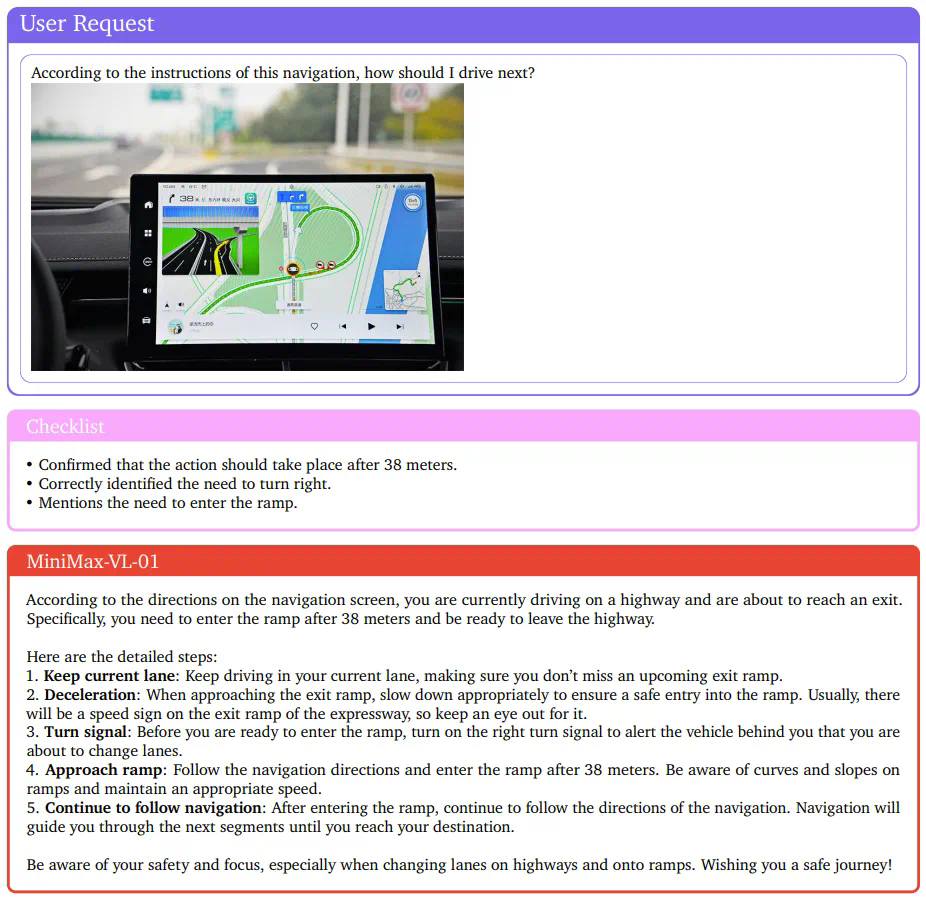

让 Agent 走进物理世界