文章来源于互联网:一次推理解决复合问题:基于MoE的大语言模型知识模块可扩展融合推理架构MeteoRA

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

-

论文标题:MeteoRA: Multiple-tasks Embedded LoRA for Large Language Models -

论文地址:https://arxiv.org/abs/2405.13053 -

项目主页:https://github.com/NJUDeepEngine/meteora

-

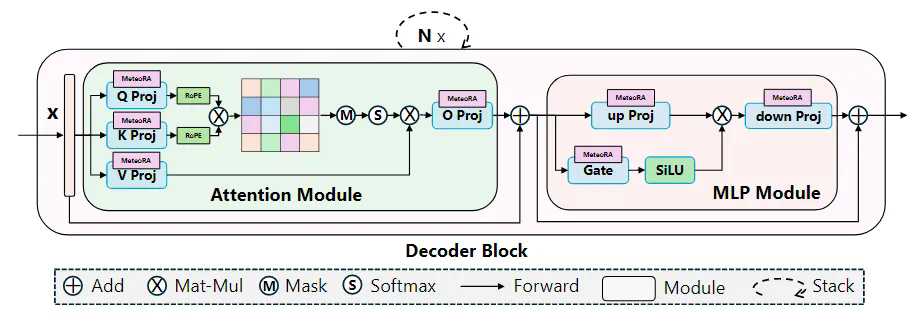

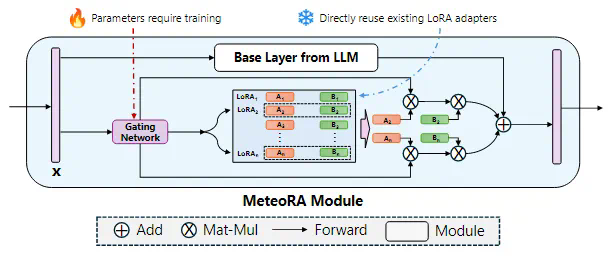

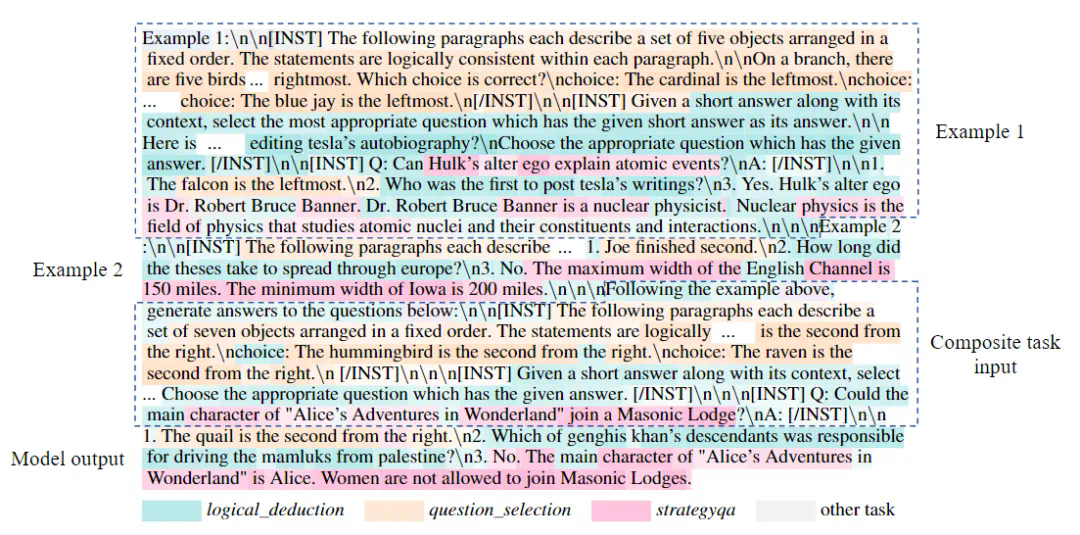

可扩展的 LoRA 集成框架:MeteoRA 框架能够整合现有的 LoRA 适配器,并提供了大语言模型自主按需选择和切换不同 LoRA 的能力。 -

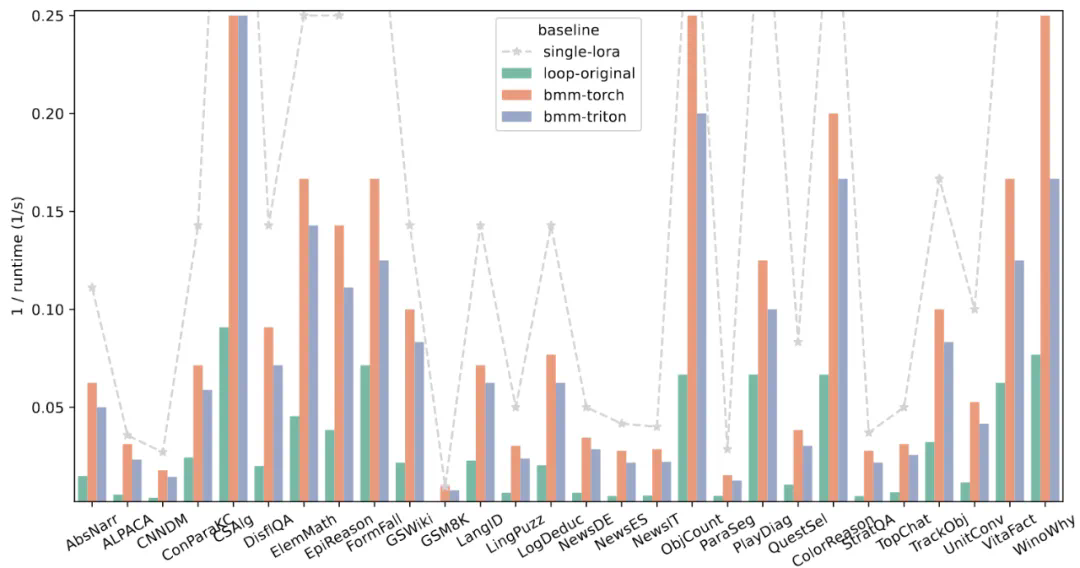

混合专家模型的前向加速策略:揭示了混合专家模型的效率问题,使用新的 GPU 内核操作实现了前向传播加速策略,在保持内存开销不变的同时实现了平均约 4 倍的加速。 -

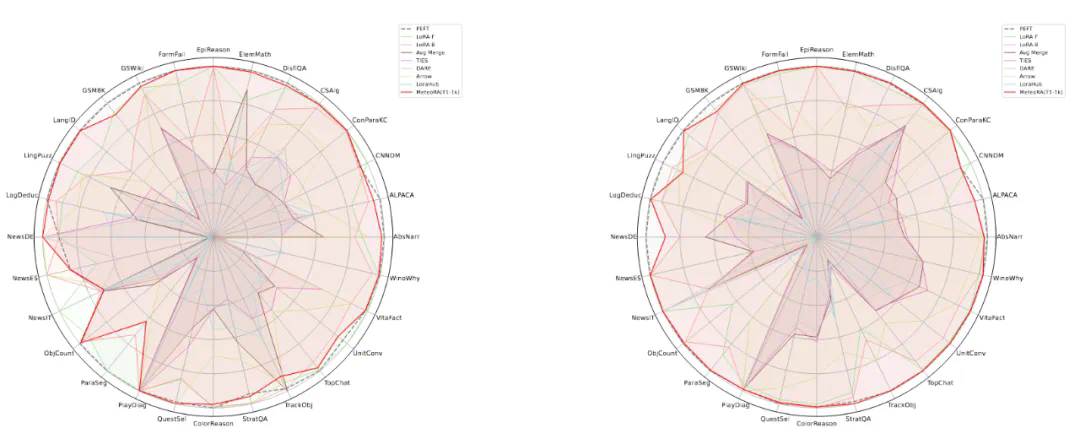

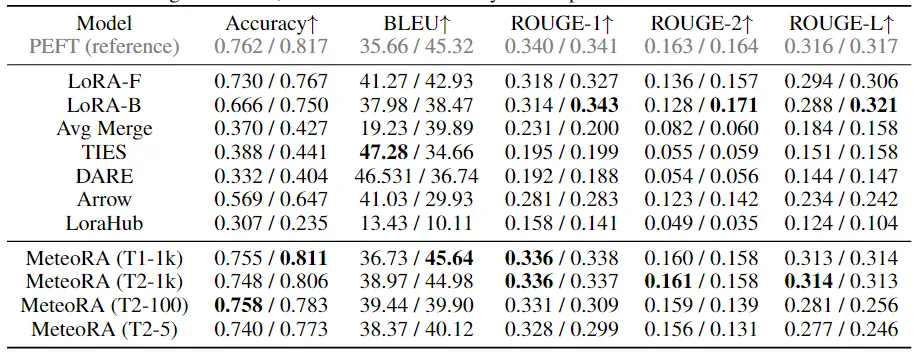

卓越的模型性能:评估表明使用 MeteoRA 框架的大语言模型在复合任务中表现出了卓越的性能,因而增强了大语言模型在结合使用现成 LoRA 适配器上的实际效果。