文章目录

Toggle前言

"日月忽其不淹兮,春与秋其代序。"

技术更新的车轮在滚滚向前,曾经名噪一时的RNN模型,在新的技术革新下也渐渐落幕,本章我们将初步了解Seq2Seq模型,同时借助Demo代码,对Seq2Seq模型有一个直观了解。

Encoder-Decoder的回顾

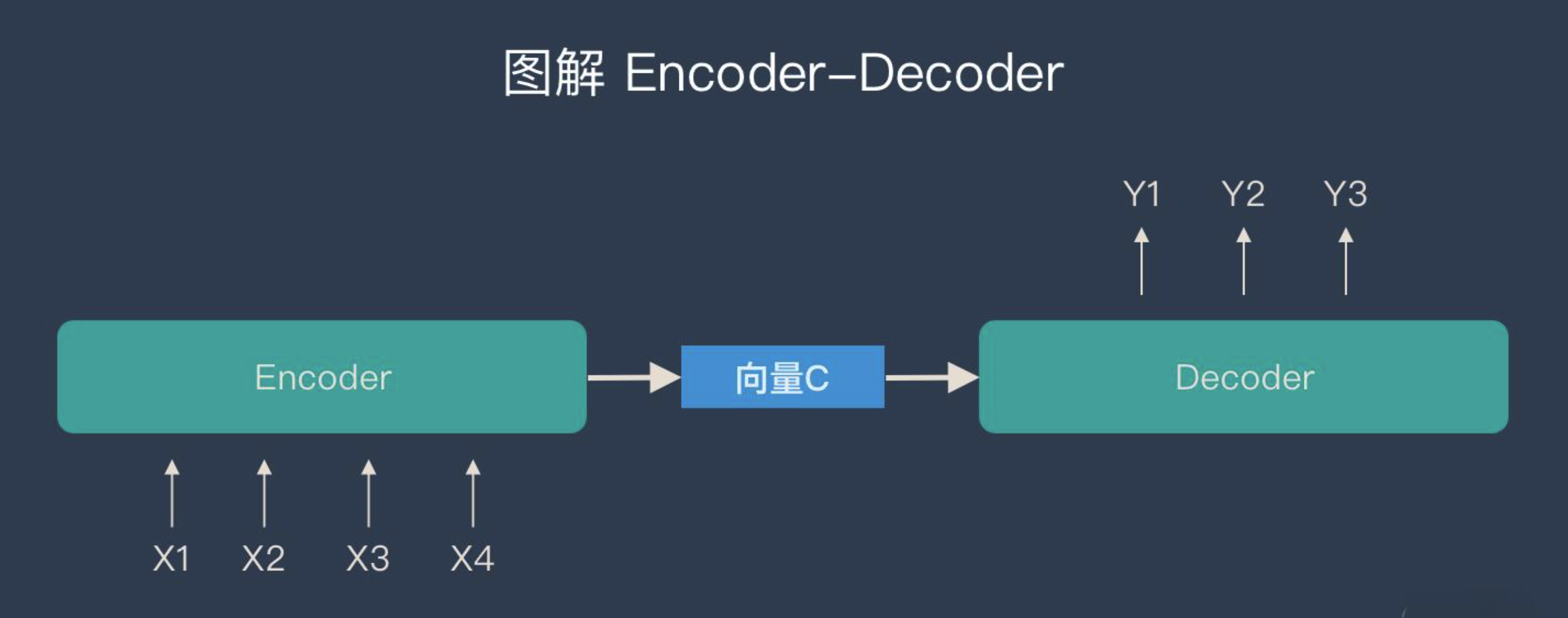

回顾【课程总结】Day15(上):图像分割之语义分割,我们曾接触到U-Net模型,它是一种Encoder-Decoder模型。在此,我们重新回顾理解Encoder-Decoder模型。

- Encoder-Decoder是一个通用的框架。

- Encoder又称作编码器。它的作用就是:将现实问题转化为数学问题。

- Decoder又称作解码器,它的作用是:求解数学问题,并转化为现实世界的解决方案。

只要符合上面的框架,都可以统称为Encoder-Decoder模型,其中sequence-to-sequence就是Encoder-Decoder的一种特例。

Encoder-Decoder的应用

图片 – 图片

音频 – 文本

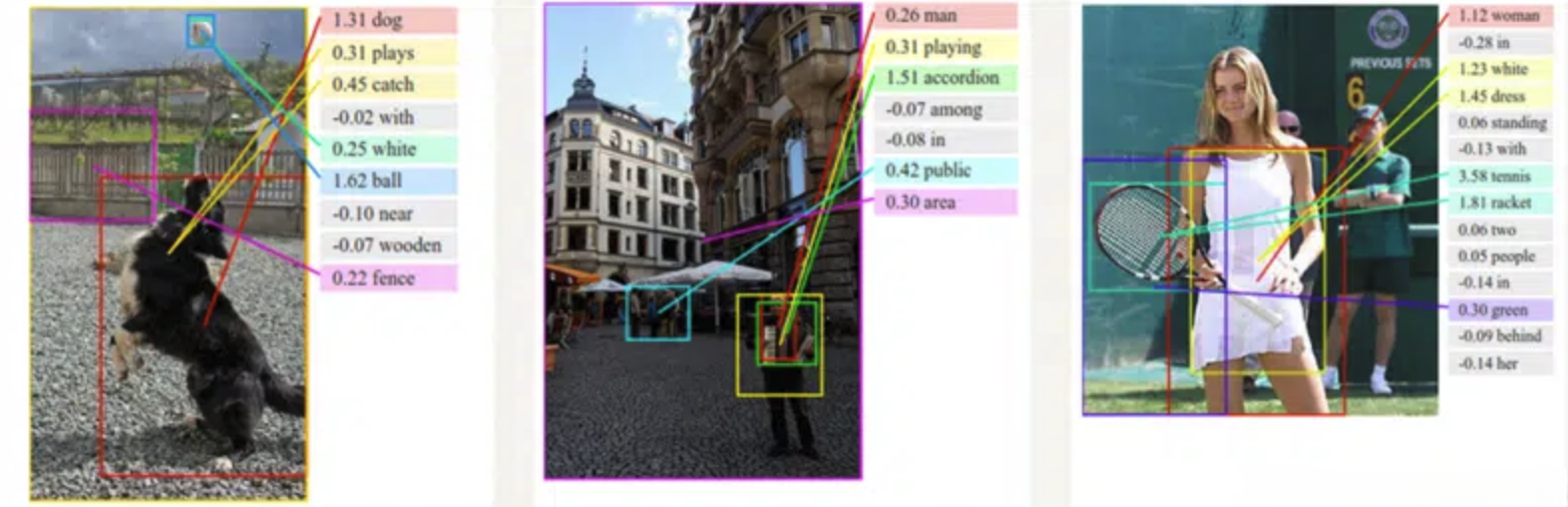

图片 – 文本

应用:图像描述生成(看图说话)

论文地址:https://arxiv.org/pdf/1505.00487

文本 – 文本

其中,文本(RNN) – 文本(RNN)是NLP第一模型!

Seq2Seq模型

模型简介

序列到序列(seq2seq)模型是一种用于处理序列数据的架构,主要用于将一个输入序列转换为一个输出序列。它广泛应用于机器翻译、文本摘要、对话系统等任务。

模型结构

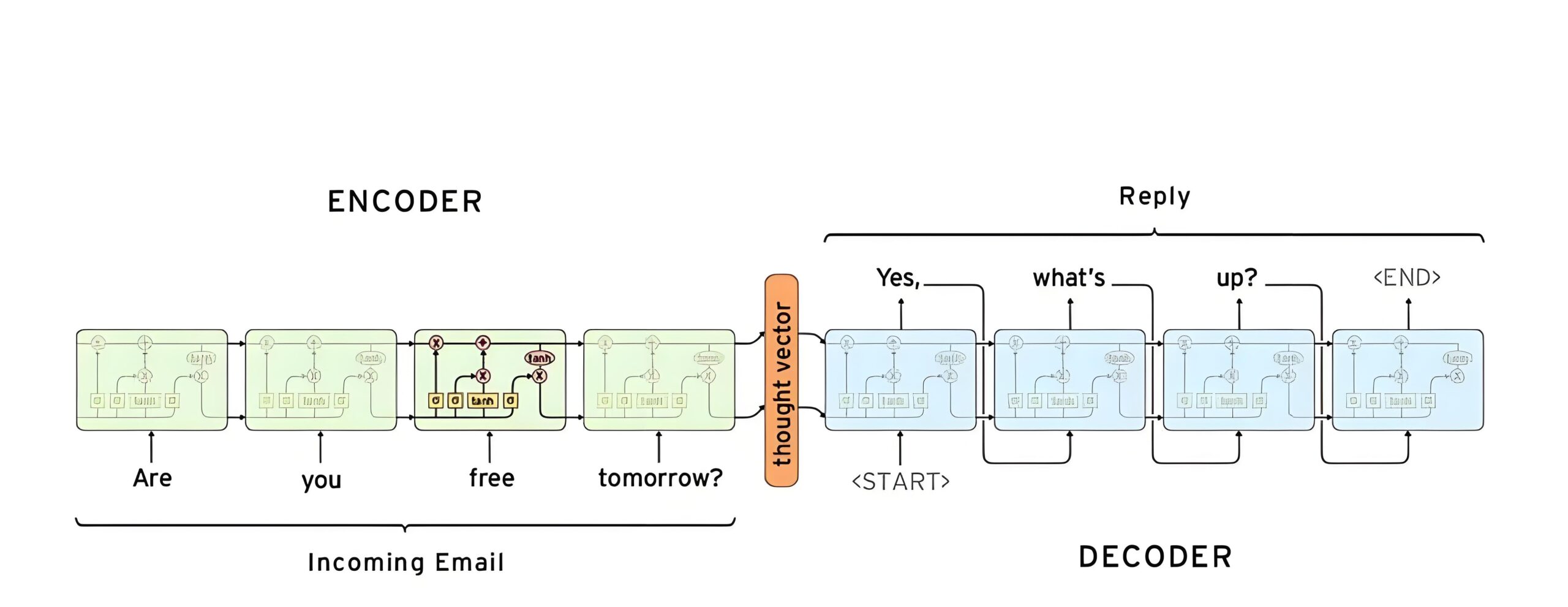

下图所示的是一个典型的机器翻译任务中,输入的文本序列(源语言表述)到输出的文本序列(目标语言表述)之间的变换。

解释说明:

-

Seq – Encoder编码器:

- 作用:解析问句,将其编码为一个中间表达

Vector。 - 本质:一个RNN(自动完成循环,一次性得到结果即可)

- 作用:解析问句,将其编码为一个中间表达

-

中间表达:

- 作用:承上启下,既是上句处理的结果,又是下句生成的参考。

- 本质:编码器RNN的最后一个时间步的隐藏状态

hn

-

Seq – Decoder解码器:

- 作用:把中间表达作为初始化状态,逐个生成下句

- 本质:一个RNN(单步生成,自回归,即:一次生成一个词)

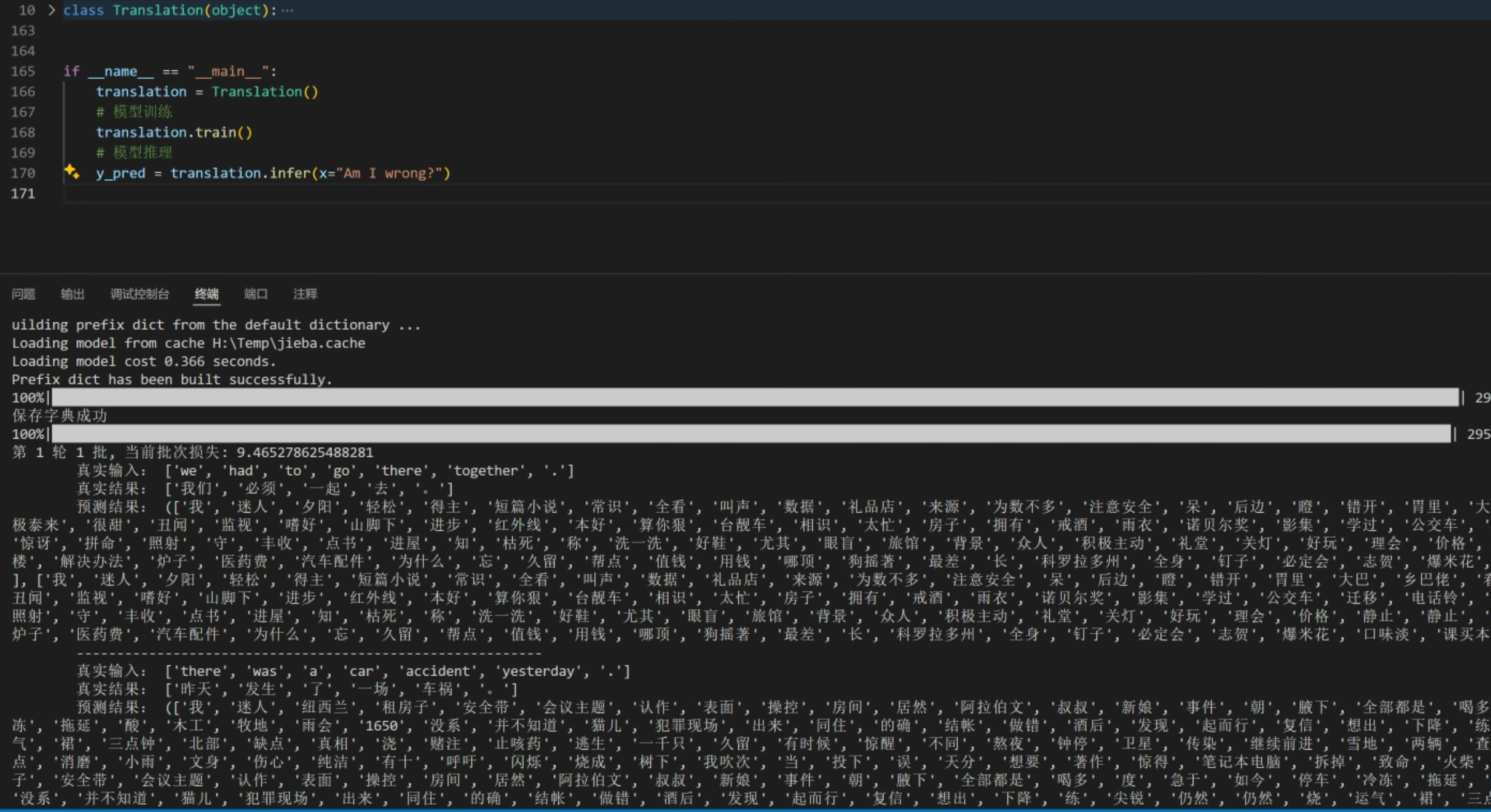

Seq2Seq的实践

接下来,我们通过运行示例代码,对Seq2Seq模型有一个直观了解。

拉取代码

git clone https://github.com/domonic18/seq2seq_demo.git安装依赖包

pip install jieba

pip install OpenCC训练

# 进入seq2seq_demo目录

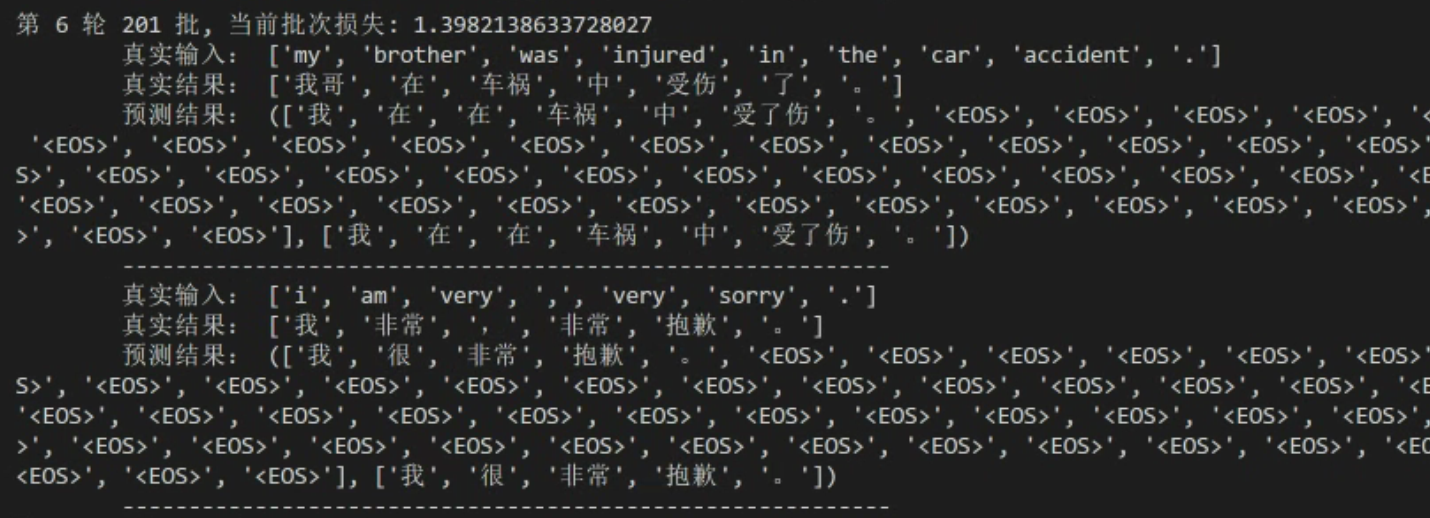

python main.py运行结果:

可以看到首次运行的时候,预测结果与真实结果相差甚远,可以说翻译的能力很差。

验证翻译能力

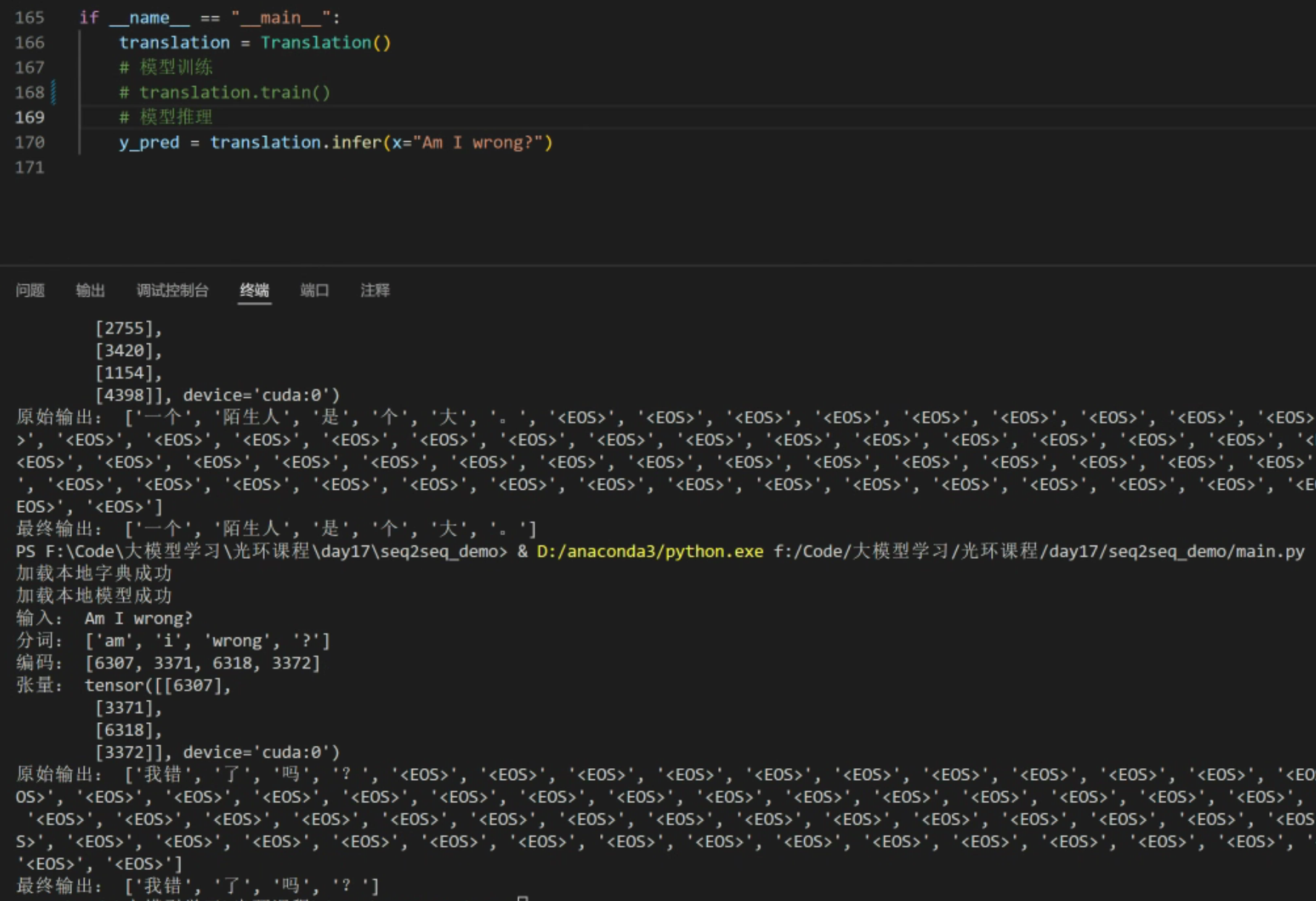

输入:Am I wrong?

可以看到经过初步训练,模型可以翻译简单的英语句子。

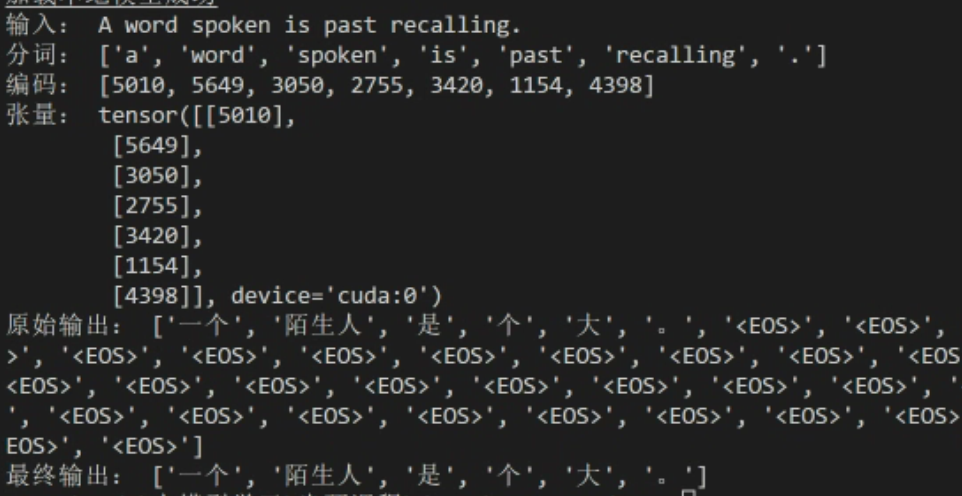

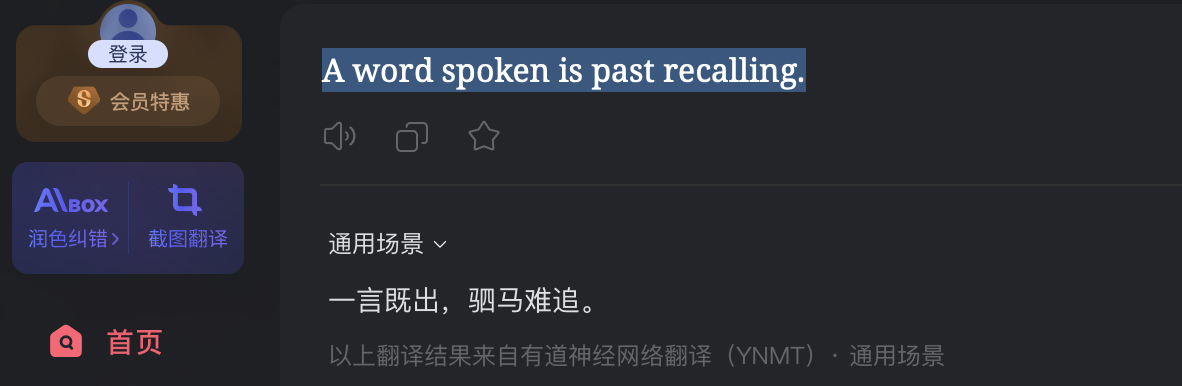

输入:A word spoken is past recalling.

对比有道词典的翻译结果,其翻译能力还是不足的。原因是当前的demo中data训练集只有3万条数据,如果加大data.txt的训练集数据,模型的能力是可以进一步提升的。

内容小结

- Encoder-Decoder是一种通用的架构,Encoder-Decoder模型有多种应用,其中文本-文本广泛应用于机器翻译、文本摘要,对话系统等任务,是NLP的第一模型。

- Seq2Seq模型是Encoder-Decoder模型的一种特例。

- Encoder编码器的作用是解析问句,将其编码为一个中间表达

Vector,其本质是一个RNN。 - 中间表达承上启下,既是上句处理的结果,又是下句生成的参考,其本质是编码器RNN的最后一个时间步的隐藏状态

hn - Decoder解码器的作用是把中间表达作为初始化状态,逐个生成下句,其本质是一个自回归的RNN。

参考资料

CNBlog:Seq2Seq原理详解

CSDN:自然语言处理从零到入门 Encoder-Decoder 与 Seq2Seq

欢迎关注公众号以获得最新的文章和新闻