文章来源于互联网:生成越长越跑偏?浙大商汤新作StarGen让场景视频生成告别「短片魔咒」

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文介绍了一篇由浙江大学章国锋教授和商汤科技研究团队联合撰写的论文《StarGen: A Spatiotemporal Autoregression Framework with Video Diffusion Model for Scalable and Controllable Scene Generation》。

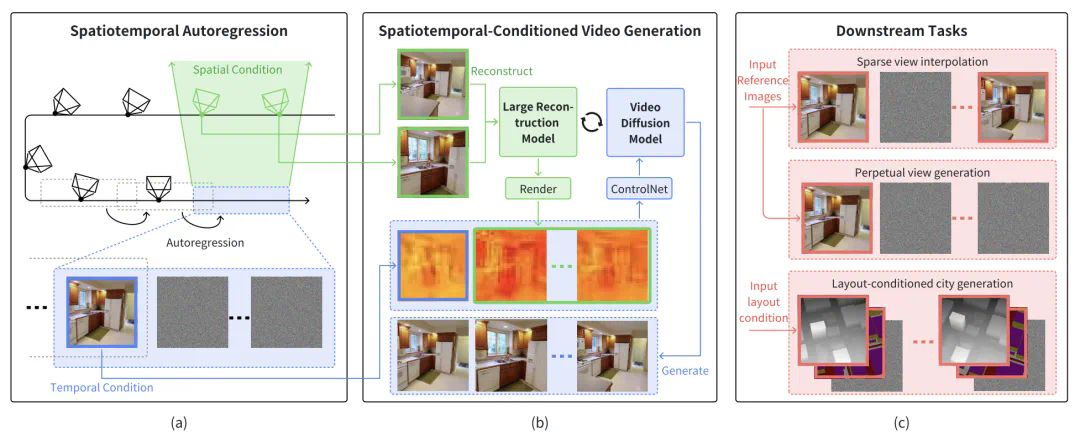

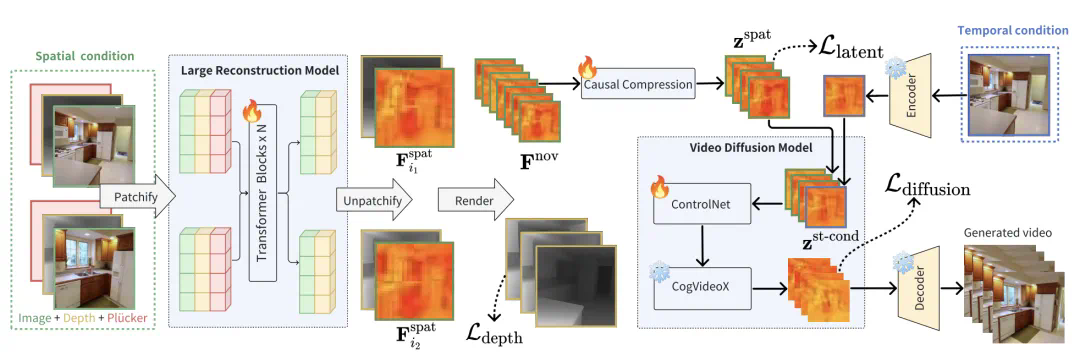

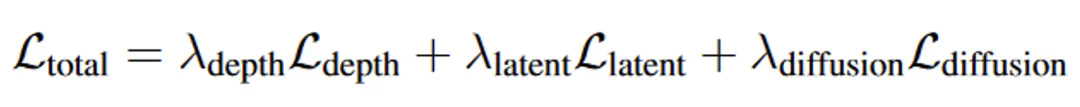

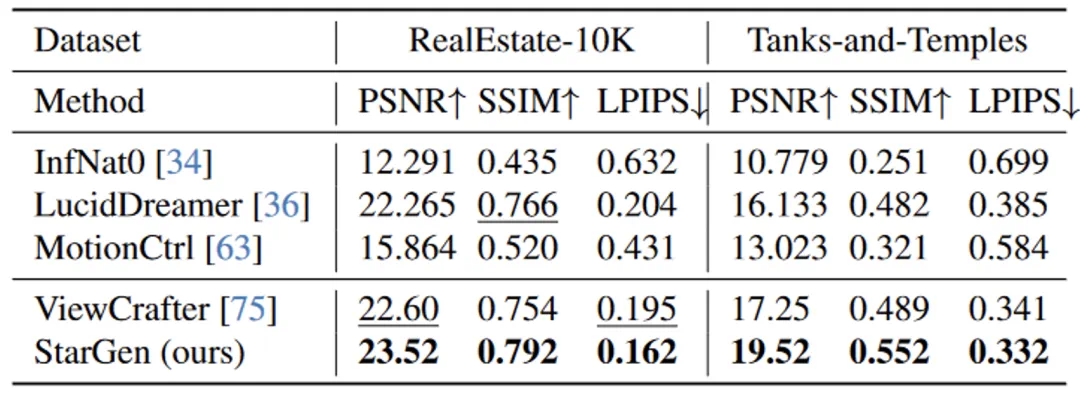

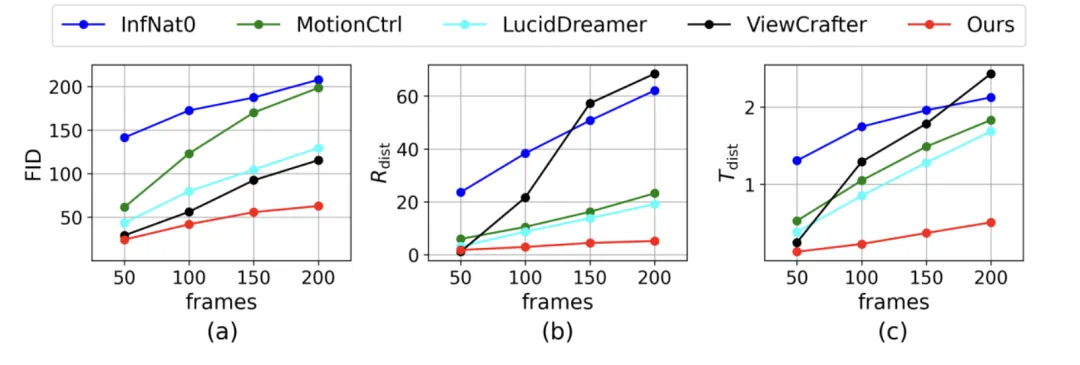

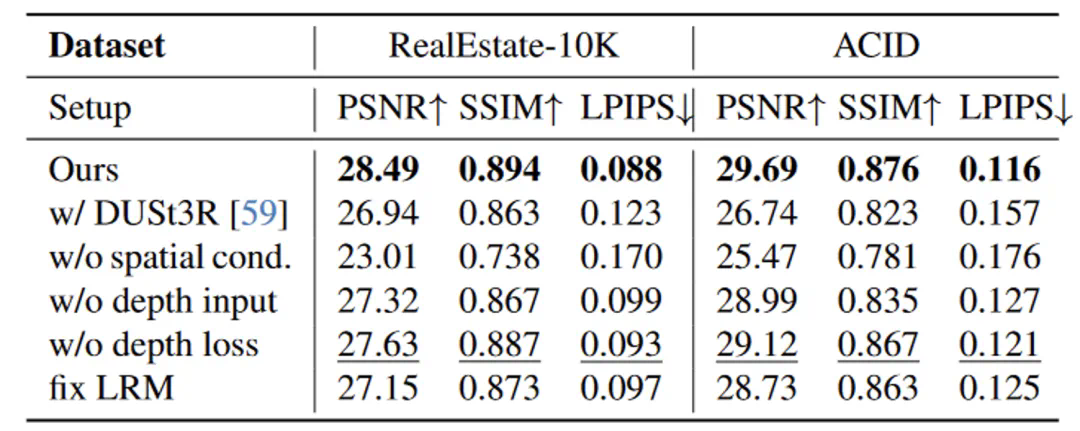

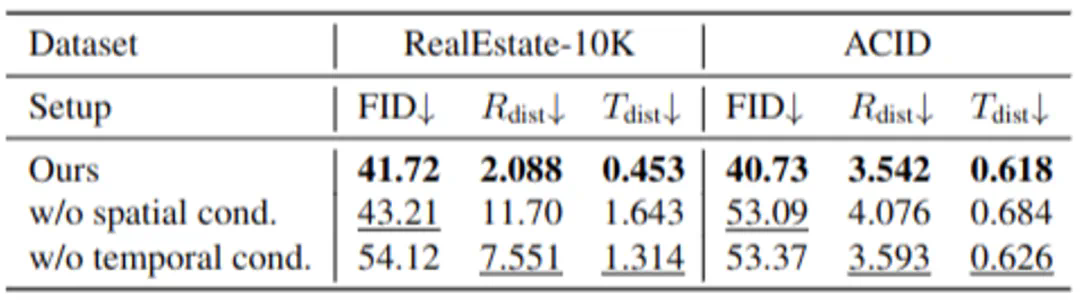

针对复杂场景的长距离场景生成的时空一致性问题,该研究团队创新提出了一种解决方案 StarGen,其核心创新在于通过引入空间与时间双重条件机制,将稀疏视图的 3D 几何信息与视频扩散模型有机结合,缓解误差累积。

StarGen 实现了多视一致的长视频生成,并且能够支持稀疏视图插值、图生视频以及布局驱动场景生成等多样化任务。实验结果表明,StarGen 在生成质量、一致性保持和场景扩展能力等方面均显著优于现有方法。

-

论文标题:StarGen: A Spatiotemporal Autoregression Framework with Video Diffusion Model for Scalable and Controllable Scene Generation

-

论文地址:https://arxiv.org/pdf/2501.05763 -

项目主页:https://zju3dv.github.io/StarGen/

-

稀疏视图插值:通过结合时空条件,生成输入图像之间的中间帧,同时支持精确的姿态控制; -

图生视频:以单张输入图像为起点,逐帧生成实现长距离视角变化; -

基于布局的城市生成:结合深度图和语义图,通过 ControlNet 对布局信息进行精准约束,生成具有大规模场景一致性的城市场景。

文章来源于互联网:生成越长越跑偏?浙大商汤新作StarGen让场景视频生成告别「短片魔咒」