文章目录

Toggle前言

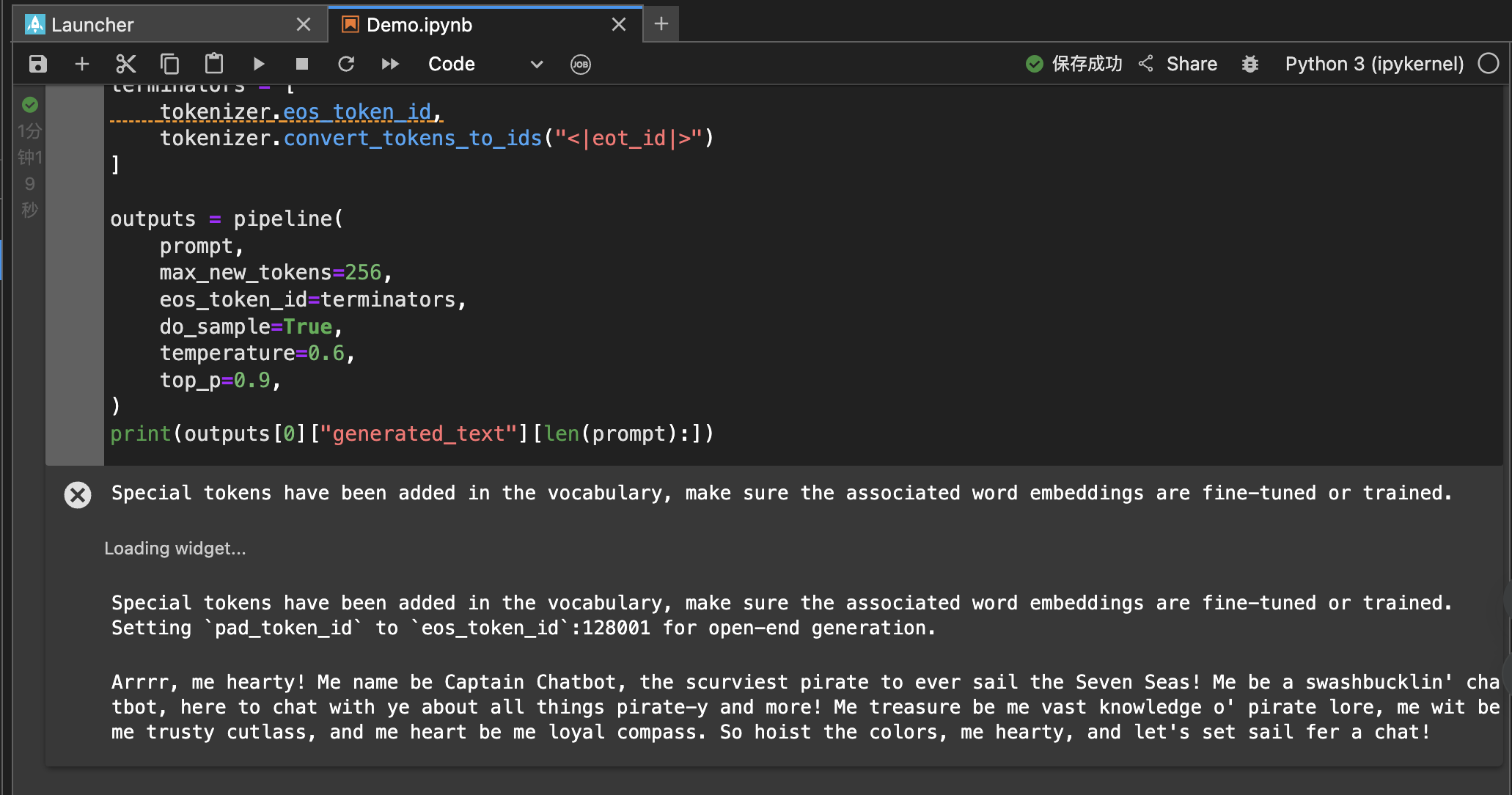

由于通过Python方式与Llama3大模型对话不够友好(如下图所示),所以我们可以借助开源的WebUI的交互界面,与大模型进行对话来实现沟通方式。

Python的交互示意图

与大模型沟通输入的内容

messages = [

{"role": "system", "content": "You are a pirate chatbot who always responds in pirate speak!"},

{"role": "user", "content": "Who are you?"},

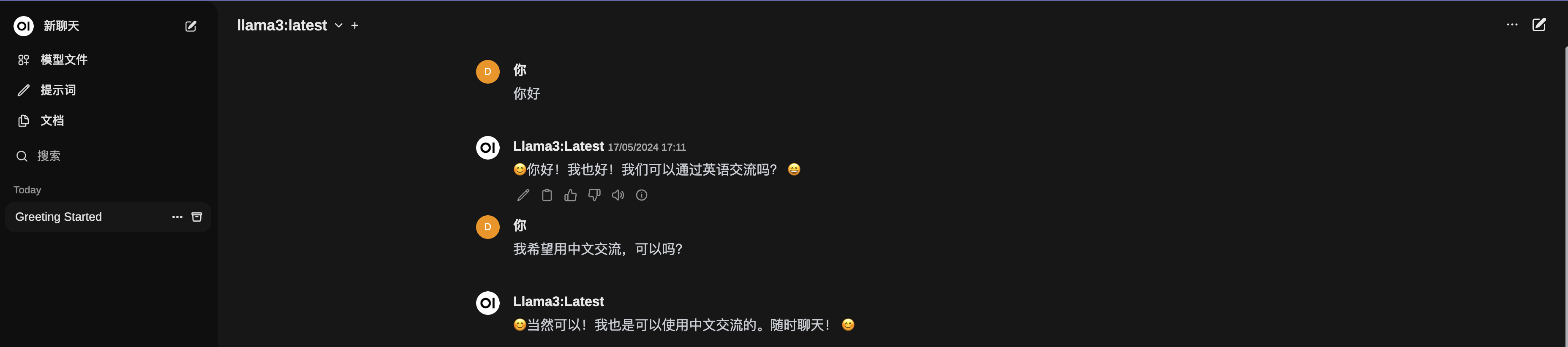

]WebUI的交互示意图

部署方式:

目前网上可以查到的大模型交互方案有两种:gpt4all 和 open-webui+ollama

由于gpt4all只需要下载安装即可使用,比较简单,所以本篇文章只进行open-webui+ollama的部署方式记录。

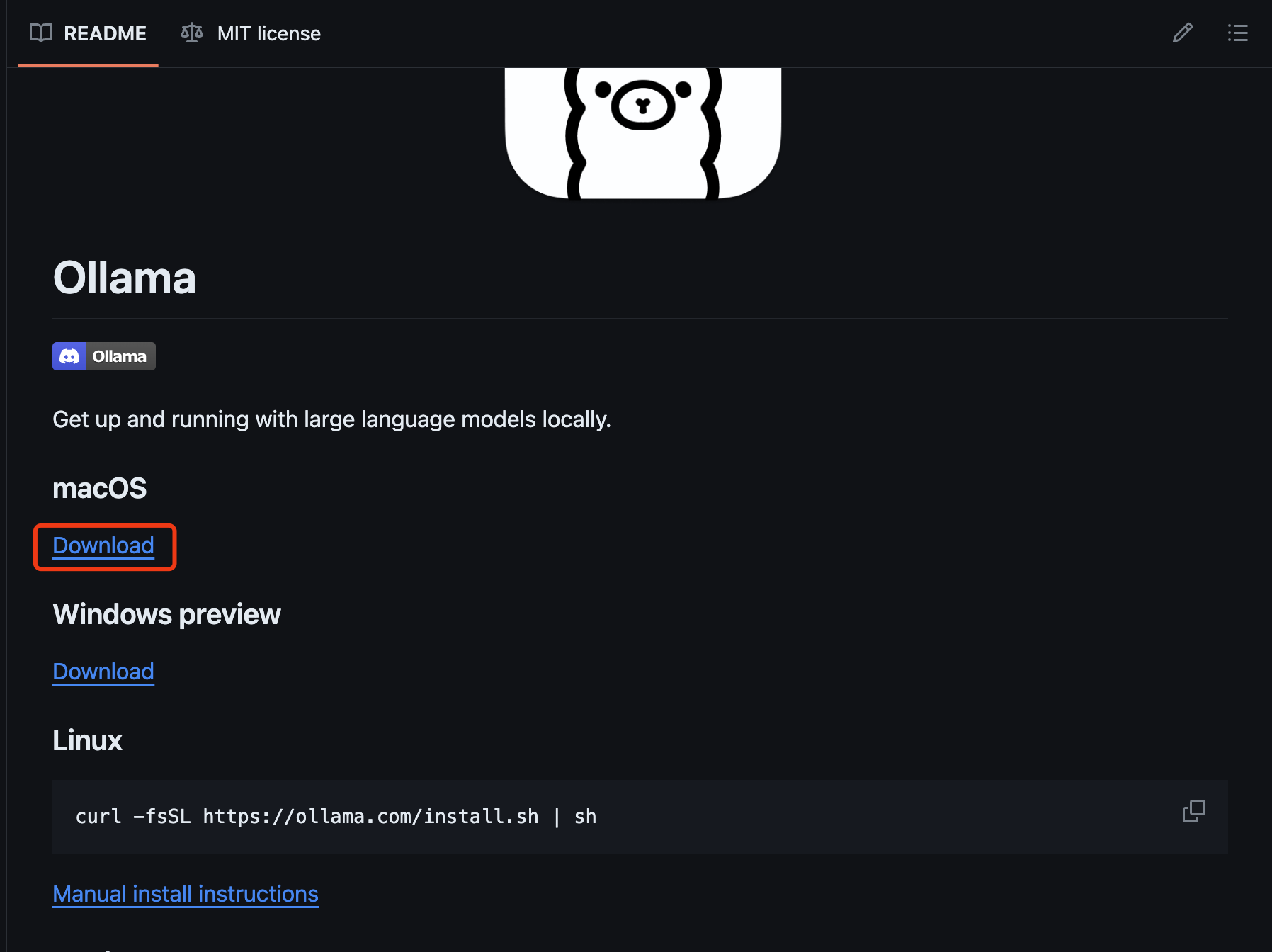

下载安装Ollama

1、访问https://github.com/ollama/ollama?tab=readme-ov-file

2、在页面中根据自己的系统情况选择对应下载链接:

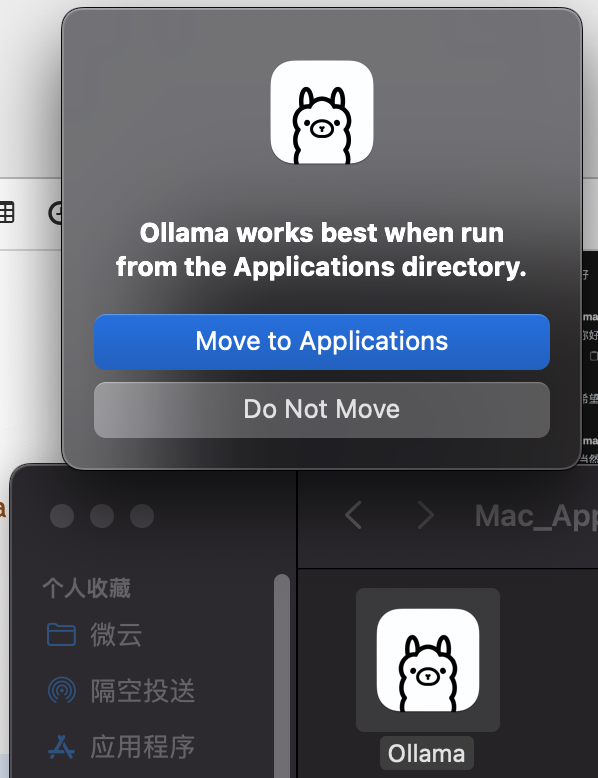

3、双击下载的.zip文件,解压后会显示Ollama的App图标,再次双击运行后选择Move to Applications即可

拉取open-webui代码

1、访问https://github.com/open-webui/open-webui?tab=readme-ov-file

2、获取代码的git路径后,在本地命令行运行如下命令拉取代码

git clone https://github.com/open-webui/open-webui.git安装Docker(如果已经Docker,可以跳过本步骤)

open-webui支持docker方式运行,这种方式可以免去很多环境依赖安装的问题,所以我们采用Docker方式来运行。

1、访问https://www.docker.com/products/docker-desktop/

2、根据仔细系统的情况选择对应下载链接:

3、下载完毕后安装即可。

Docker方式运行Open-webui

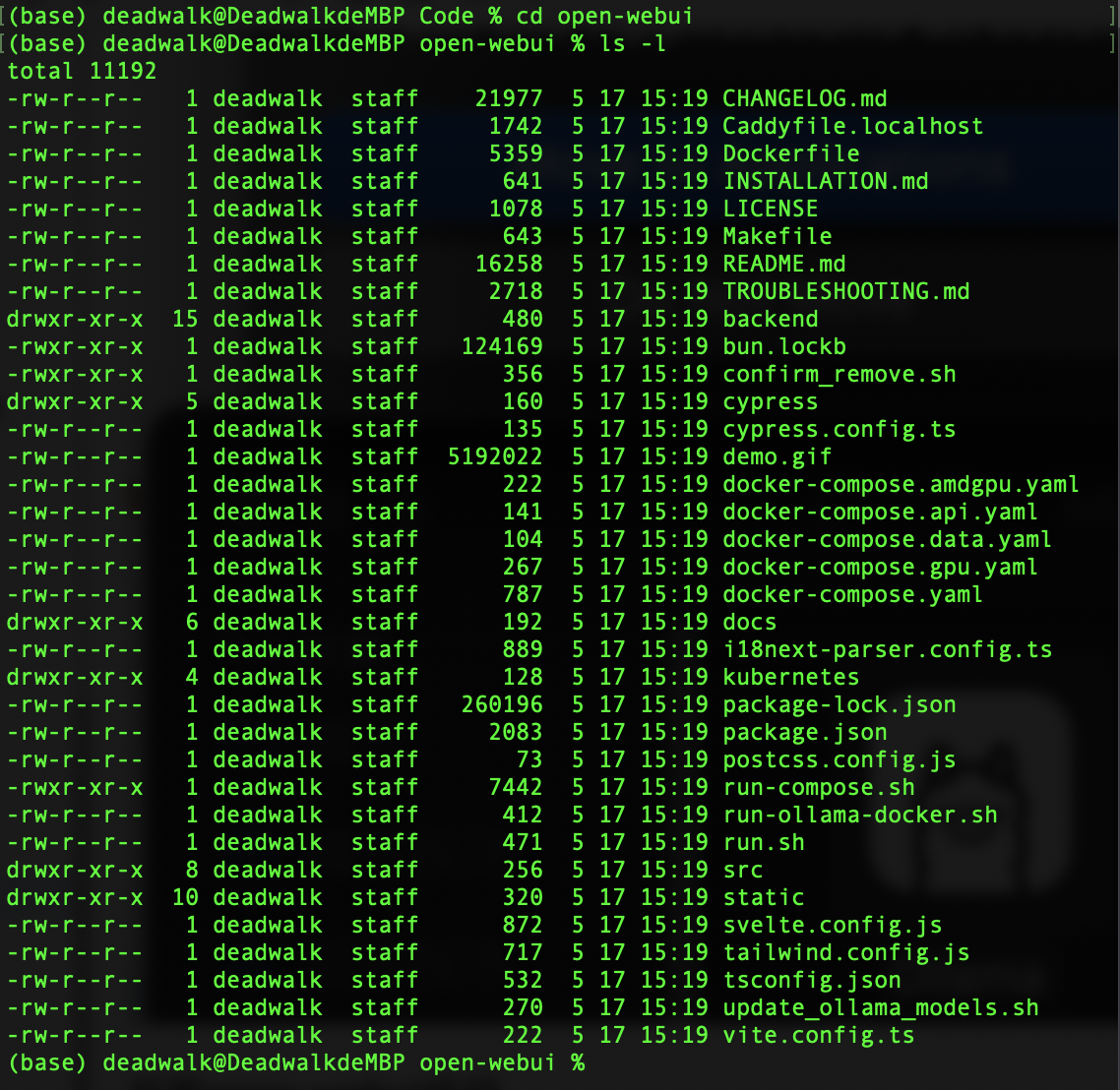

1、在命令行下进入open-webui目录下

2、运行如下命令进行Docker镜像的拉取和容器启动

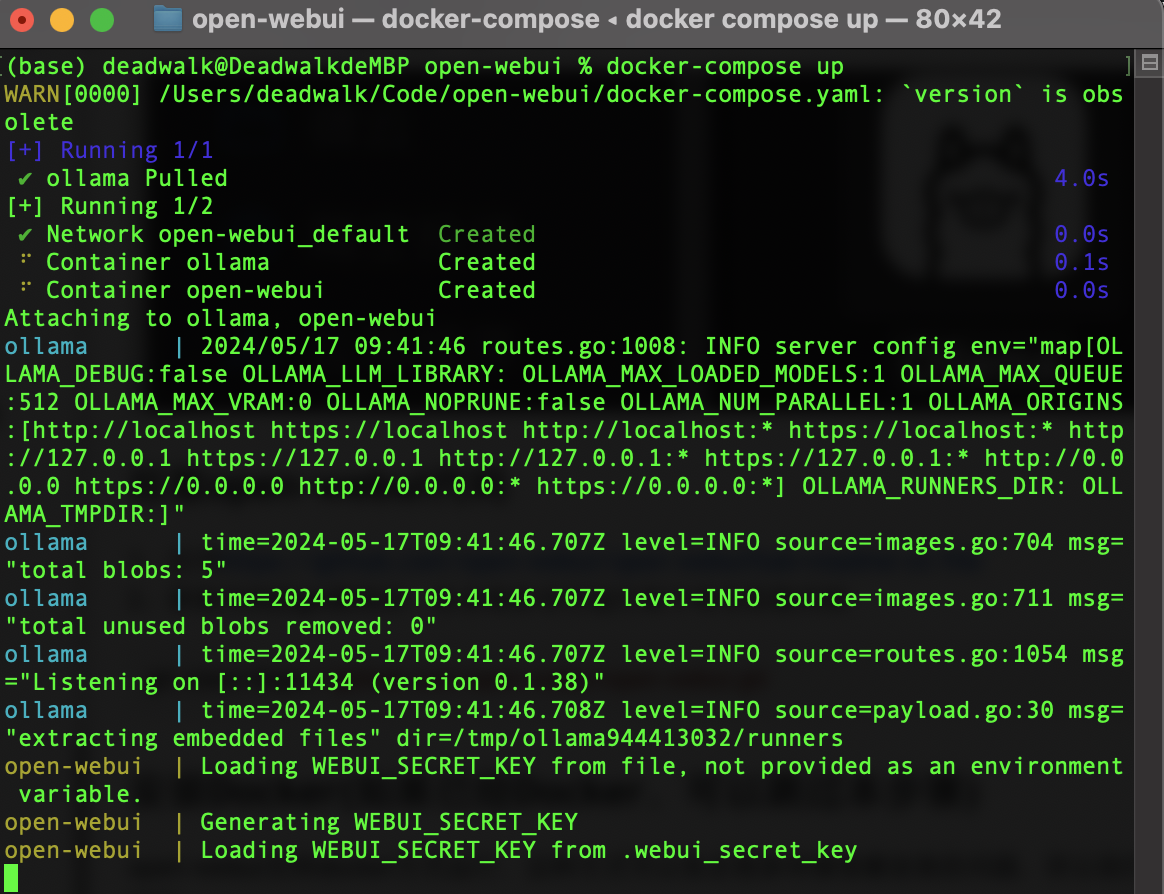

docker-compose up3、稍等片刻后,Docker容器显示如下内容代表正常启动

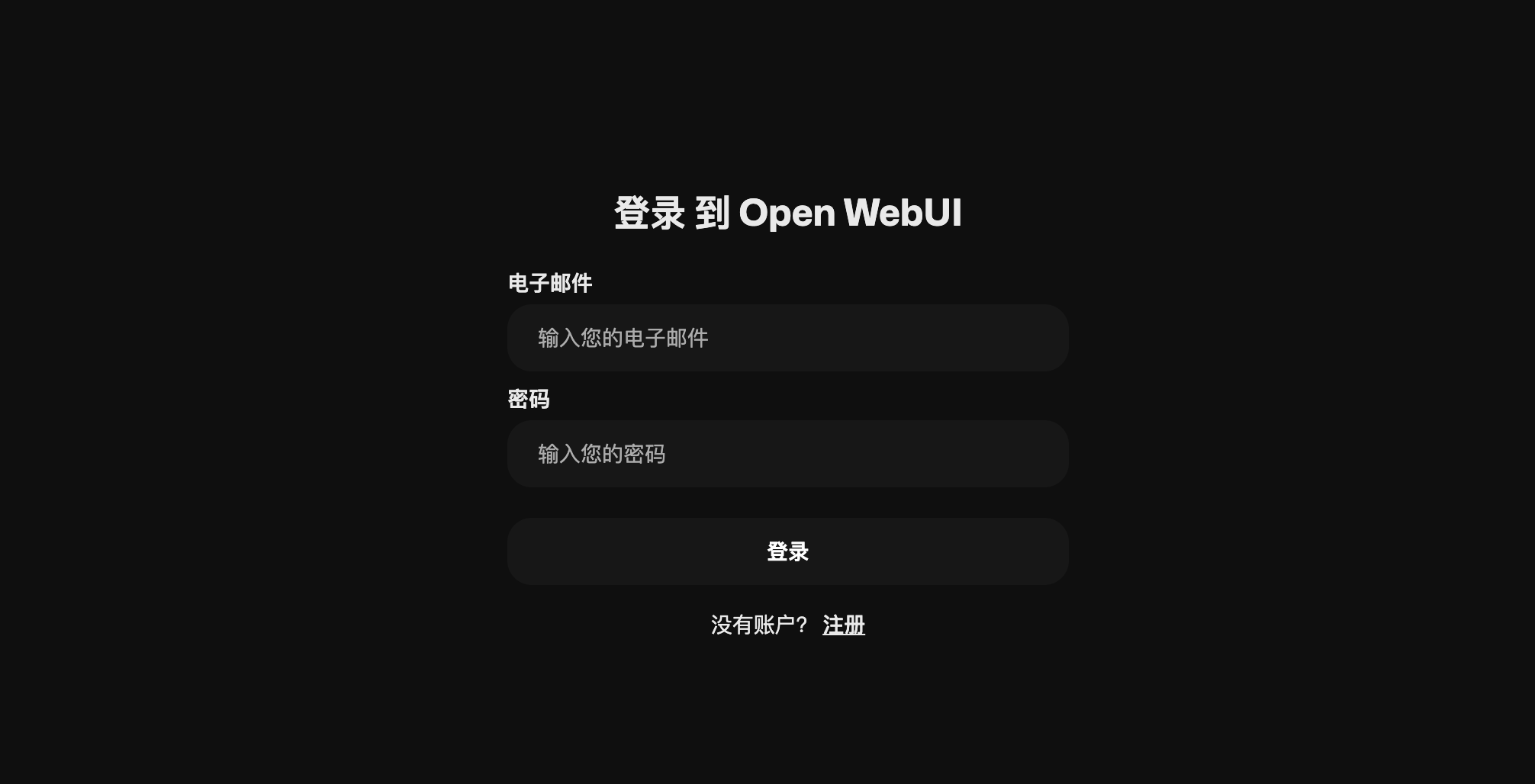

4、由于open-webui默认是3000端口,所以在浏览器访问http://localhost:3000/

5、按照页面提示注册账号后即可登录系统

下载模型文件

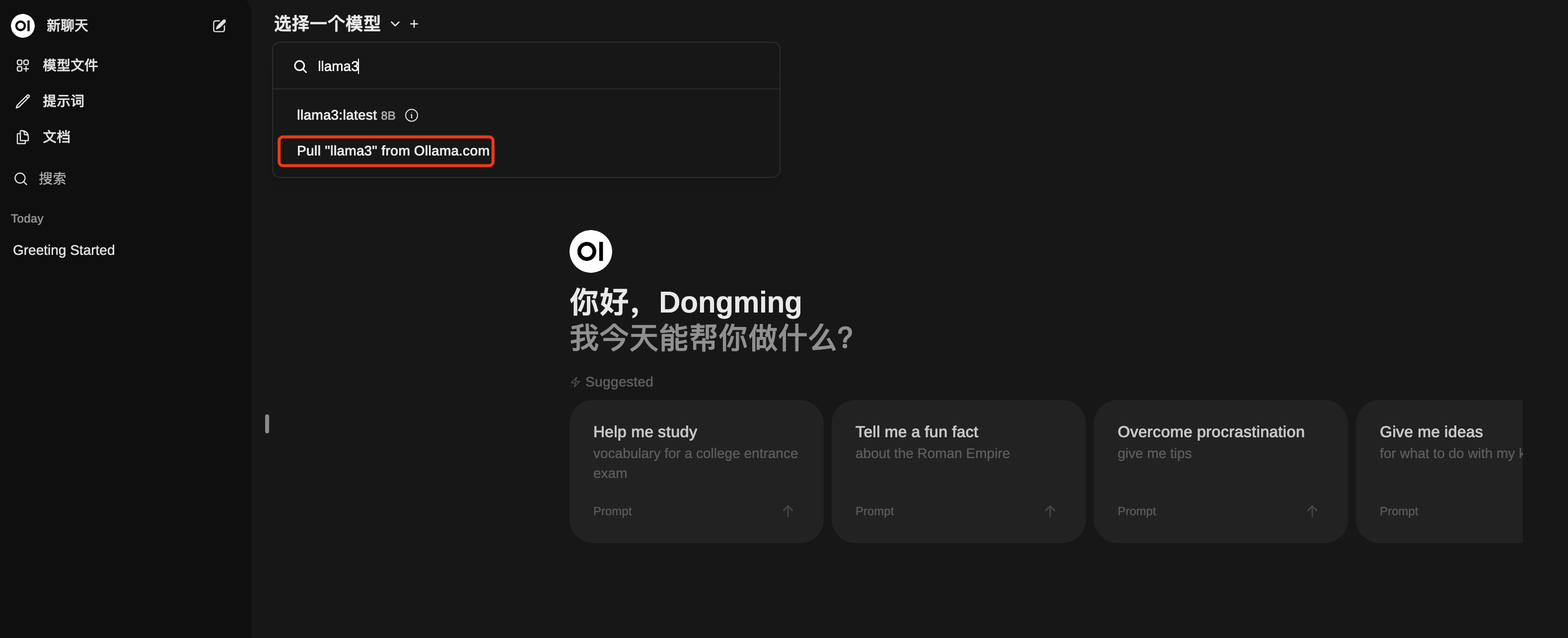

1、进入open-webui的主页面

2、选择一个模型的下拉菜单下,输入我们想下载的模型,例如:llama3

3、点击pull ‘llama3’ from Ollama.com,等待模型文件的下载

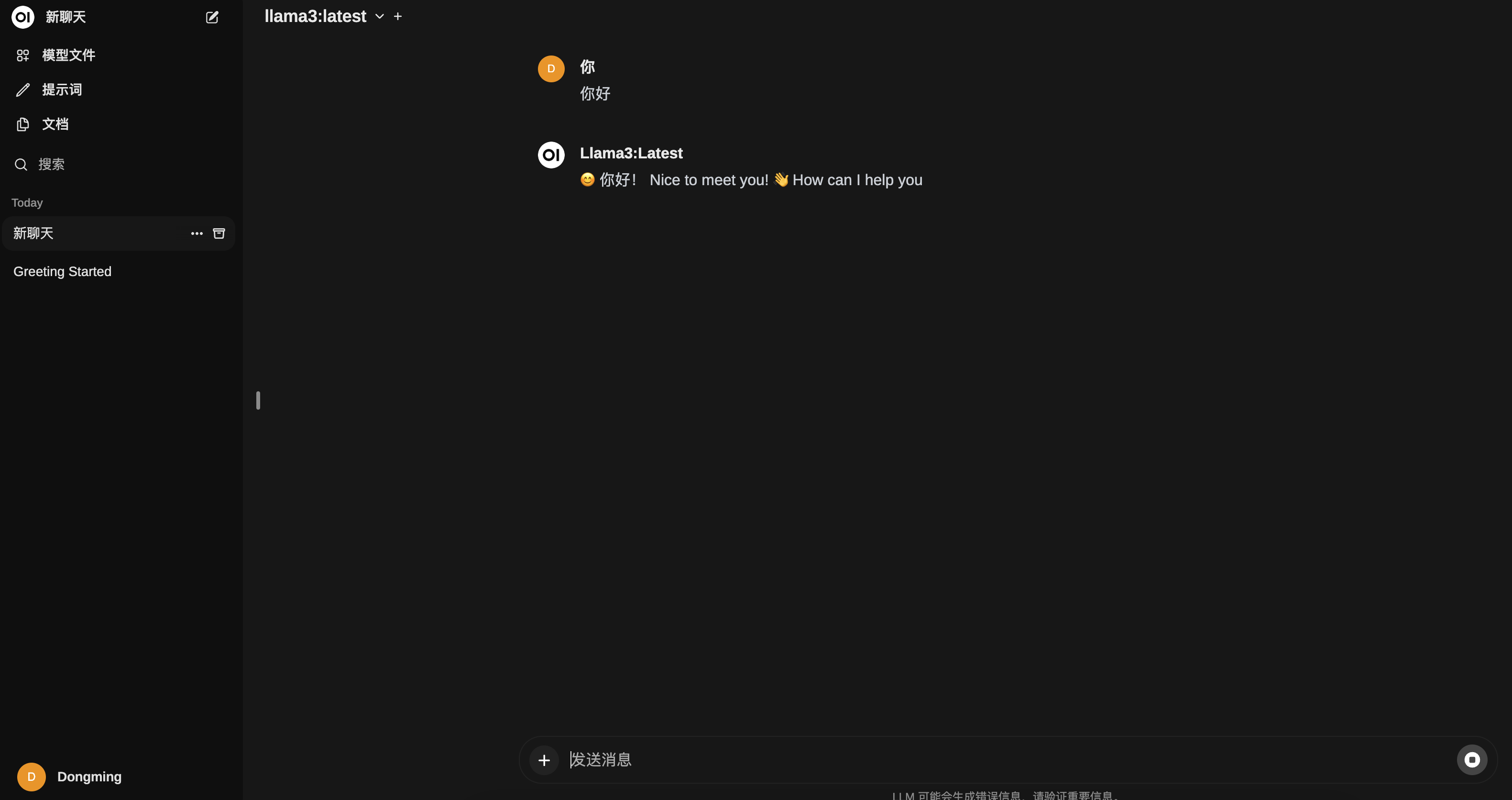

开启对话功能

下一步计划,我将尝试微调模型后,通过ollama3加载与其对话。

附录:

参考文章《open-webui+ollama本地部署Llama3》

欢迎关注公众号以获得最新的文章和新闻